Ständig wird über Deepfakes berichtet und welche Gefahr sie vielleicht darstellen, weil sie so leicht zu produzieren sind. Aber ist das wirklich so simpel? Unser Redakteur Michael Förtsch wagte den Selbstversuch und baute eigene Videofälschungen. Außerdem holte er sich Tipps von einem Profi. Das Ergebnis überraschte auch ihn.

Von Michael Förtsch

Vor rund drei Jahren habe ich das erste Mal von Deepfakes gehört. Wahrscheinlich wie die meisten anderen auch. Seitdem habe ich Hunderte dieser Videos gesehen, die mit Hilfe von Deep-Learning-Technologie manipuliert worden waren – einer Methode des maschinellen Lernens von Künstlicher Intelligenz. In den meisten davon waren die Gesichter eines Menschen auf das eines anderen projiziert worden, passend zur Mimik, die das Originalgesicht im Video zeigt. Die treibende Kraft bei der Deepfake-Entwicklung sind Pornos. Kleine Communities verwenden viel Zeit und Fachwissen darauf, die Gesichter von – vor allem weiblichen – Berühmtheiten wie Daisy Ridley auf den Kopf von Pornodarstellerinnen zu setzen. Und ja, davon habe ich so einige gesehen. Denn was da getan wird, das ist so verstörend wie beeindruckend.

Tatsächlich sind diese Videos manchmal auf den ersten Blick nicht als Fake erkennbar. Aber auch sogenannte SFWDeepfakes gibt es. Damit sind Deepfakes gemeint, in denen keine nackte Haut zu sehen ist und die oft eher spaßig gemeint sind. Hunderte davon habe ich geschaut. Da wird Nicolas Cage zum Hauptdarsteller verschiedenster Filme gemacht oder das Gesicht von Sylvester Stallone auf das von Macaulay Culkin in Kevin: Allein zu Haus geklebt. Aber selbst wenn Deepfakes vor allem Pornos und Ulk-Videos hervorbringen: Die Bundesregierung, US-Geheimdienste und Medien warnen vor den KI-Fälschungen. Sie sollen eine „Bedrohung [für] demokratischer Prozesse“ sein und für Angriffe auf Entscheidungs- und Politstrukturen taugen. Soweit die Panik und die Deepfake-Apokalypse.

Okay, wie geht nun ein Self-Made-Deepfake?

Nachdem ich mich also schon einige Jahre mit Deepfakes beschäftigt hatte, wusste ich grob natürlich, wie die zustande kommen. Aber selbst ein Deepfake erstellt, das hatte ich noch nicht. Das wollte ich nun ändern. Vor allem auch um zu erfahren, wie einfach oder schwer das nun wirklich geht; und um einschätzen zu können, wie gefährlich diese Technologie tatsächlich ist. In Folge dessen starrte ich in den letzten zwei Wochen auf tausende Bilder von echten Gesichtern und von ebenso vielen, die von einer Künstliche Intelligenz generiert worden waren.

Ich lud mir dafür sowohl FaceApp als auch DeepFaceLab herunter, zwei der populärsten Software-Tools, wenn es um das Erstellen von Deepfakes geht. Beide funktionieren grundsätzlich gleich und setzen auf TensorFlow, ein von Google entwickeltes Framework, das Machine Learning ermöglicht. Der merklichste Unterschied: FaceApp kommt mit einer benutzerfreundlichen Grafikoberfläche daher. DeepFaceLab hingegen ist simpler gestrickt und setzt auf eine Reihe von Stapelverarbeitungsdateien, die direkt aus dem Programmordner einzelne Arbeitsschritte starten. Letzteres fand ich nach erstem Herumprobieren irgendwie übersichtlicher.

Um herauszufinden, wie und wo man beim eigenen Deepfake startet, schaute ich mir zuerst auf YouTube mehrere Tutorials an. Manche davon waren gut, andere weniger. Ich las mich durch Diskussionen und Debatten auf Reddit, in der – stellenweise äußerst grenzwertigen – Community Voat und in einigen der einschlägigen Foren, wo sich manche der handwerklich besten Deepfake-Experten tummeln. Vieles davon war aufschlussreich und ließ mich von vornherein einige Fehler vermeiden. Manches ging aber weit über meinen Verständnishorizont hinaus. Doch was die ersten Schritte sind, das hatte ich verstanden.

Nämlich:

- ein Video mit einer Person finden, deren Gesicht durch das eines anderen Menschen ersetzt werden soll (ich nenne es mal Zielvideo)

und

- zahlreiche Bilder und Videos (also Quellvideos) des Menschen finden, der das „Spendergesicht“ liefern soll.

Das klingt zunächst recht unkompliziert – und ist es auch.

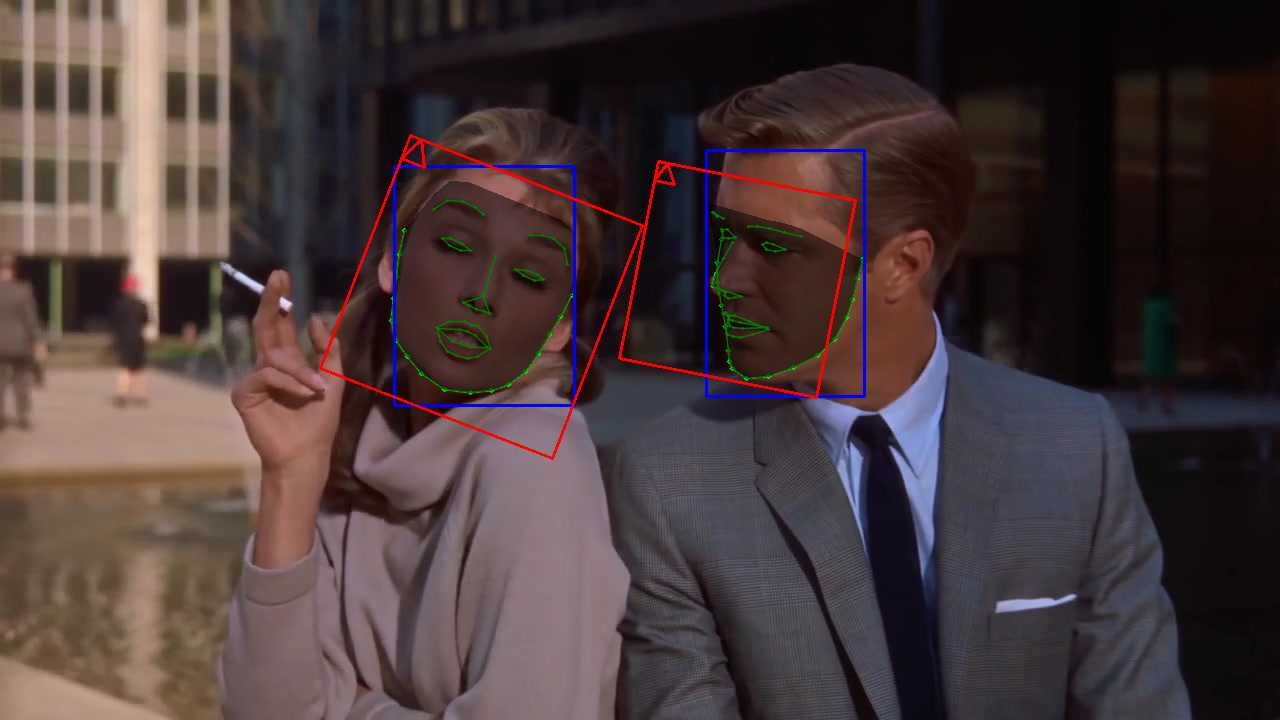

Mit DeepFaceLab wird das Zielvideo anschließend durch ein kleines Programm in seine Einzelbilder zerlegt. Aus diesen werden sämtliche Gesichter als einzelne Fotos extrahiert. Das kann mehrere Minuten dauern. Parallel fertigt die Software weitere Bilder an, in denen die Gesichter mit einer Maske aus farbigen Linien im Gesamtbild verortet werden. Das dient der Künstlichen Intelligenz später als eine Art Karte, die zeigt, wo, in welchem Winkel und mit welcher Perspektive das neue Gesicht aufgetragen werden muss.

Kommen mehrere Personen in einem Zielvideo vor, müssen sämtliche extrahierten Gesichtsbilder händisch durchgegangen werden. Nur das Gesicht der Person darf übrigbleiben, das durch ein neues Gesicht ersetzt werden soll. Die Bilder der anderen Personen werden einfach gelöscht. Ebenso wie zahlreiche vermeintlichen Gesichter, die die Software gerne falsch erkennt. Das können Falten in einem Mantel sein, die einer Nase und einer Augenpartie ähneln, oder auch eine absurd geformte Vase. Das macht diesen Arbeitsschritt etwas umständlich und zeitaufwändig.

Das gleiche Prozedere wie beim Zielvideo wird auf die Quellvideos oder auch Bilder der Person angewendet, deren Gesicht letztlich im fertigen Film landen soll: In Einzelbilder zerlegen, Gesichter extrahieren und untaugliche Gesichtsbilder löschen. War es das? Für den Einstieg: ja. Jetzt sind DeepFaceLab und der Computer dran. Was anschließend gestartet wird, ist nämlich der Lernprozess eines sogenannten Autoencoders der Künstlichen Intelligenz.

Was der tut, kann bei DeepFaceLab verfolgt werden – durch mehrere Reihen von Gesichtern, die in einem Fenster zu sehen sind. In einer Reihe sind die Originalaufnahmen des Zielgesichtes dargestellt. In einer weiteren die Rekonstruktion, also Nachbauten, des gleichen Gesichtes durch die Künstliche Intelligenz. Und in drei weiteren Reihen das Originalgesicht aus dem Zielvideo, dessen KI-Rekonstruktion und die Überblendung mit dem Zielgesicht, wie es im fertigen Video aussehen würde. Die Gesichter in der zweiten und letzten Reihe sehen zu Beginn noch sehr unscharf und verzerrt aus – werden aber stetig besser.

Was da im Hintergrund passiert und durch die Bilder illustriert wird, ist recht komplex, aber im Grunde folgendes: Jedes der Gesichter wird in einen sogenannten Encoder geleitet. Dort wird das Gesicht durch zahlreiche Schichten eines Künstlichen Neuronalen Netzes geschleust. Jede Schicht ist dabei dafür da, Merkmale des Gesichtes herauszuarbeiten, die sein einzigartiges Aussehen ausmachen, und auf eine kompakte Zahl an Variablen zu verdichten. Dabei lernt der Encoder, das Gesicht zu lesen. Es ist fast so, wie wenn ein Foto mit Transparentpapier abgepaust wird.

Dieser Prozess läuft sowohl für das neue als auch das originale Gesicht ab. Beide Gesichter werden dabei vom gleichen Encoder abgepaust. Auf der anderen Seite versucht aber jeweils ein eigener Decoder aus den abgepausten Variablen das alte oder das neue Gesicht zu rekonstruieren. Anschließend wird vom System verglichen, wie ähnlich sich die Originale und die Nachbildungen sind. Und das wieder und wieder – so, dass die Unterschiede nach und nach geringer werden.

Irgendwann merkt sich die Decoder nämlich die Gesichtszüge seines Gesichtes , die immer gleich sind und irgendwann auch nicht mehr abgepaust werden müssen. Die Decoder wissen also nach etlichen Hundert digitalen Pauspapierkopien, wie der Mund, die Augenbrauen, die Augen und die Nase ihres Gesichtes aussehen. Dadurch muss der Encoder nur noch ganz einfache Informationen weiterleiten. Nämlich: Ist der Mund offen? Wohin schauen die Augen? Sind die Brauen hochgezogen?

Wie schnell dieser Prozess vorangeht, das hängt von der Rechenkraft und dem Speicher des Rechners – insbesondere der Grafikkarte – ab. Außerdem hat die Zahl der Bilder und deren Komplexität einen Einfluss. Wie lange das Künstliche Neuronale Netz trainiert, das ist aber einem selbst überlassen. Jederzeit kann das Training gestoppt werden.

Soll anschließend das Gesicht ausgetauscht werden, tut DeepFaceLab folgendes: Es gibt die Anweisung an den Encoder, alle vorhandenen Originalgesichter nochmal vom Decoder zeichnen zu lassen. Die Befehle werden dann aber nicht an den Decoder für das Originalgesicht geleitet, sondern den für das neue Gesicht. Der bekommt dann also einfache Anweisungen wie „Zeichne ein lächelndes Gesicht“ und tut das mit dem den Mund, den Augen, der Nase und Augenbrauen des Spendergesichts. All die generierten Gesichter werden dann von der Software basierend auf der Maskenkarte in das Zielvideo kopiert. Fertig ist das Fake. Eigentlich.

Werde Mitglied von 1E9 – schon ab 3 Euro im Monat!

Als Mitglied unterstützt Du unabhängigen, zukunftsgerichteten Tech-Journalismus, der für und mit einer Community aus Idealisten, Gründerinnen, Nerds, Wissenschaftlerinnen und Kreativen entsteht. Außerdem erhältst Du vollen Zugang zur 1E9-Community, exklusive Newsletter und kannst bei 1E9-Events dabei sein.

Jetzt Mitglied werden!

Es ist nicht nur die Künstliche Intelligenz, die ein Fake ausmacht

Meine ersten Deepfake-Versuche liefen eher mau. Ich versuchte, das Gesicht eines befreundeten Games- und Kultur-Journalisten, der sich ebenfalls mit dem Thema befasste, auf den Körper von Robert Downey Jr. in Iron Man 2 zu setzen. Das Ausgangsmaterial bestand aus zwei Interviews mit meinem Bekannten – und dadurch einigen Hundert ausgelesenen Bildern seines Gesichtes – und einem kurzen Clip aus dem Marvel-Film. Ich gab DeepFaceLab zunächst eineinhalb Stunden, sich das Gesicht meines Bekannten anzutrainieren und exportierte dieses dann in ein Video. Das Ergebnis war entsprechend.

Das Gesicht meines Bekannten schwebte als verschwommenes Viereck über dem Gesicht des Schauspielers. Das sah eher nach einem Grafikfehler als nach einem Fake aus. Dennoch: Für die kurze Zeit, die ich investiert hatte, war das Ergebnis faszinierend. Die Technik funktionierte wirklich. Das war ein Ansporn, weiter zu machen. Über die kommenden Tage versuchte ich mich daher an immer neuen Gesichtern und Videos. Und ich las zahlreiche Erfahrungs- und Erfolgsberichte von anderen Hobby-Fakern und fragte auch jemanden, der sich mit der Sache wirklich auskennt.

Das war Tom, der seinen Nachnamen lieber für sich behält. Er wohnt in Tschechien und erstellt in seinem Job professionell 3D-Doppelgänger von echten Menschen. Im Internet und der Deepfake-Szene kennt man ihn aber als CTRL SHIFT FACE. Er hatte mit Videos für Aufsehen gesorgt, in denen er Christian Bale im Film American Psycho durch Tom Cruise ersetzt oder David Bowie Never Gonna Give You Up singen lässt. Vor einem Jahr fing er damit an. „Ich sah, dass [die Technik] das Zeug für echt gute Comedy hat“, sagt er. „Und ich fand das meiste, was damit angestellt wurde, nicht so richtig gut.“

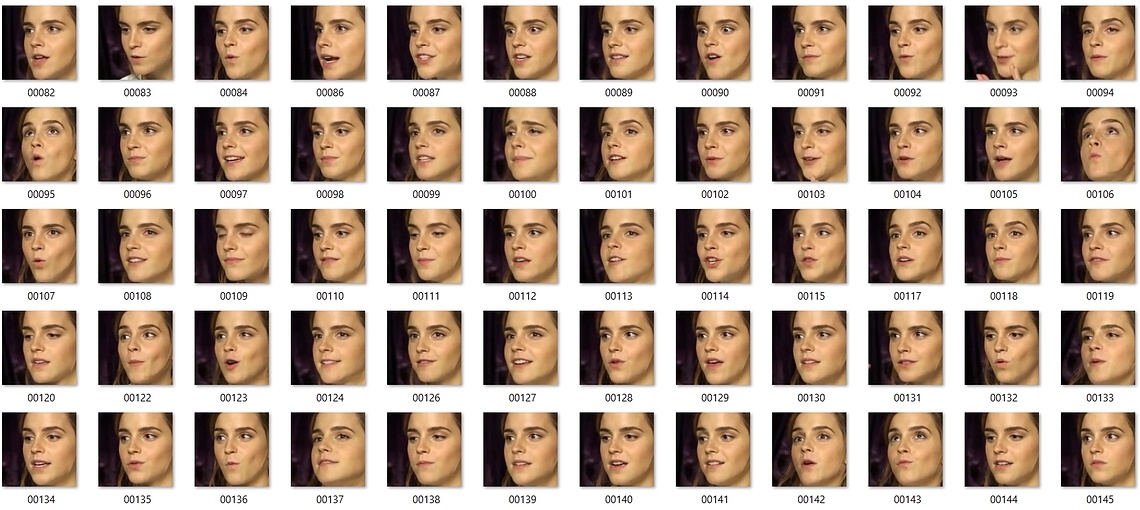

Tom erklärt mir, dass die Menge an Bildern des Gesichts, das auf ein anderes gesetzt werden soll, für das Training der Künstlichen Intelligenz durchaus von Bedeutung ist. Es sei wichtig, „ein großes Dataset“ zusammenzusuchen, sagt er. Für mich als Einsteiger bedeutet das: 1.500 bis 6.000 Bilder sollten es schon sein. Viel mehr noch zähle aber, wie und vor allem wie unterschiedlich das Gesicht eines Menschen jeweils darauf zu sehen ist. Das heißt: Sie sollten viele verschiedene Kamerawinkel und Perspektiven, unterschiedliche Gesichtsausdrücke und Lichtstimmungen zeigen.

„Je mehr [Bilder], umso besser“, sagt der Deepfake-Künstler. Das bloße Sammeln der Fotos reicht aber nicht. Das Archiv muss auch kuratiert werden. Bilder mit großen Unschärfen, Kompressionsartefakten oder zu wenigen Details müssen aussortiert werden. Denn die können das Ergebnis verschlechtern. „Lass dir Zeit mit der Erstellung deiner Datasets“, bekräftigt Tom daher. „Wenn das Dataset nicht gut ist, wird es das Endresultat auch nicht sein.“

Der Deepfake-Künstler selbst arbeitete für seine Werke mit „Tausenden über Tausenden von Bildern“, die er aus Archiven, Filmen und Videos fischt. Mit diesen lässt er eine Künstliche Intelligenz dann über eine Woche hinweg trainieren – oder eher: „mindestens eine Woche“. Dafür nutzt er keinen heimischen Rechner, wie ich. Wie viele, die es mit den Deekfakes ernst meinen, setzt er mittlerweile auf den professionellen Cloud-Dienst Paperspace, der so viel Rechenkraft zur Verfügung stellt, wie er braucht.

Die Community hilft sich, besser zu werden

Immer wieder versuchte ich mich nach den ersten Experimenten und dem Einholen von Tipps und Tricks an kleinen Deepfake-Clips. Dafür nutzte ich nun die Gesichter von Prominenten. Mit bedachterer Bildauswahl erreichte ich tatsächlich immer bessere Resultate. Händisch suchte ich mit Suchmaschinen nach Perspektiven und Blickwinkeln, die die bisherigen Bilder noch nicht abdeckten. Gezielt streute ich während der Trainingsstopps der Künstlichen Intelligenz neue Bilder eines Blinkwinkels ein und löschte alte Aufnahmen, um den auf bestimmten Fotos zu sehenden Look zu forcieren. Und ich ließ der Künstlichen Intelligenz deutlich mehr Zeit, ein Model eines bestimmten Gesichtes zu lernen.

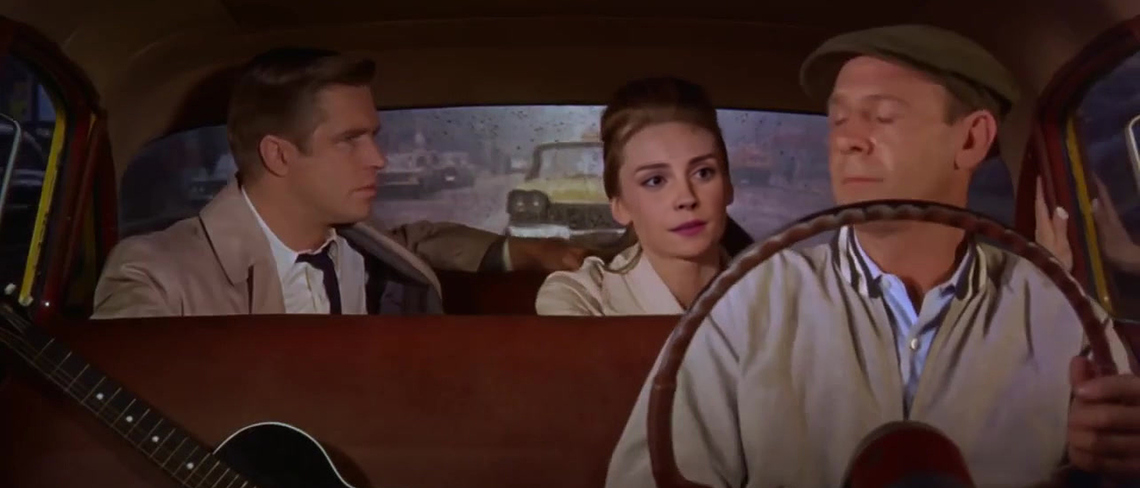

Vor allem meine Versuche, Emma Watson in die Filme von Audrey Hepburn zu projizieren, gelangen so recht gut. Natürlich waren meine Fakes keine Videos, die einen Betrachter täuschen könnten. Und von den Clips, wie sie Deepfake-Profis wie DerpFakes, iFake und CTRL SHIFT FACE produzieren, sind sie qualitativ meilenweit entfernt. Aber: „Für die ersten Versuche ist das echt gut“, sagt mir Tom, der sich einige meiner Ergebnisse anschaute, die ich auf Twitter gepostet hatte. Sein Tipp an der Stelle: Sich mit anderen aktiv austauschen, um mehr zu lernen. Vor allem auf Discord sind zahlreiche der Deepfake-Größen und auch die Entwickler von Software wie DeepFaceLab, FaceApp oder auch FaceSwap unterwegs.

Eines meiner letzten Deepfake-Videos. Es ist nicht überzeugend aber durchaus gelungen, wie ich finde.

„Ich bin in Kontakt mit den meisten von ihnen“, sagt Tom. „Wir helfen uns. Es sind viele interessante Menschen und wir diskutieren das Thema Deepfakes und Arbeitsabläufe.“ Zahlreiche der Tipps und Tricks, die für Deepfake-Profis langsam Gang und Gäbe werden – aber mein Verständnis noch übersteigen – sind dort in Debatten entstanden. Das sind Techniken, um Augen natürlich glänzen zu lassen, Lidschläge zu simulieren oder auch Schweiß, Blutspritzer (oder andere Körperflüssigkeiten) und Schatten auf ein Gesicht zu zeichnen – und Deepfakes damit noch realistischer und schwerer enttarnbar zu machen.

Hat sich meine Meinung über Deepfakes geändert?

Vor rund zwei Wochen habe ich nun also das erste mal DeepFaceLab gestartet. Ich hatte keine Ahnung, was ich damit anstellen könnte. Mittlerweile glaube ich zu wissen, was ich tue und verstehe den grundlegenden Prozess – zumindest um vieles besser als vorher. Ebenso spüre ich den Reiz, den diese Technologie entfaltet. Denn es macht einfach sehr viel Spaß, mit den Gesichtern herumzuspielen und in detektiv-gleicher Manier die passenden Rohdaten zu suchen. Es ist spannend zu sehen, wie die Künstliche Intelligenz ihre Arbeit verrichtet und reizvoll, immer wieder in den Prozess einzugreifen und ihn zu perfektionieren.

Der Einstieg in das Deepfaking ist, wie ich erlebt habe, ziemlich einfach. Aber wirklich überzeugende Deepfakes zu erstellen, das ist – jedenfalls im Moment – noch kein Kinderspiel. Es ist mit viel Zeit und handwerklichem Können verbunden – und einer gewissen Passion, einer Lust an der Bildrecherche und dem Ausprobieren. Es gibt aber genügend Menschen, die all das aufbringen und die Technologie dadurch immer zugänglicher machen – wohl bis an einen Punkt, an dem ein gutes Deepfake irgendwann mit wenigen Mausklicks produziert werden kann. Die nächsten Fassungen von DeepFaceLab und FaceApp sollen bereits einfacher zu nutzen sein, wodurch Anfängerfehler vermieden werden können. Und sie sollen Optionen mitbringen, die die Ergebnisse noch raffinierter machen.

Ein weiteres Deepfake, das vor einigen Tagen entstand. Weitere Versuche könnt ihr auf dem YouTube-Kanal zu diesem Projekt finden.

Ob das allerdings die große Verunsicherung von Behörden, Medien und Politik rechtfertigt, darüber mag ich nach meinem Selbstversuch immer noch nicht urteilen – eigentlich sogar noch weniger als zuvor. Denn die Gefährlichkeit der Deepfakes hängt allem voran von jenen ab, die sie erstellen und nutzen, aber auch jenen, die ihre Verbreitung zulassen. Unbestreitbar ist, dass Deepfakes einen Schaden anrichten können – nicht zuletzt für jene, deren Körper und Gesicht darin böswillig missbraucht werden.

Allerdings sind Deepfakes auch nicht perfekt. Seien es gefälschte Reden von Trump, Putin und Co. oder Fake-Pornos: Sie können mit gutem Auge oder entsprechender Software enttarnt werden. Aber das geht nicht immer sofort. Damit sind Deepfakes letztlich wenig anders als andere Falschmeldungen und Fake News, die von Medien und Menschen unkritisch und übereilig aufgegriffen und weitergetragen werden. Vielleicht sind nicht Deepfakes die große Gefahr, sondern mangelnde Skepsis und ihre unkritische Verbreitung?

Werde ich weitermachen?

Nach dem ich selbst nun vor allem mit Filmausschnitten herumexperimentiert und mich viel durch Foren und Debatten gelesen habe, ist für mich eines unbestreitbar. Deepfakes haben ein großes Potential als Werkzeug der Kunst, Kreativität und Kultur. Das MIT Center for Advanced Virtuality ließ Richard Nixon damit eine Rede über den Tod der Apollo-11-Astronauten halten, die er glücklicherweise nie halten musste. Das Dalí Museum in Florida ließ den exzentrischen Maler in einer Weise wiederauferstehen, die ihm sicher gefallen hätte. Und Deepfake-Künstler auf YouTube lassen Schauspieler in Rollen schlüpfen, die sie abgelehnt oder nie bekommen hatten. Und wieder andere zeigen, wie mit der Technik besser als mit 3D-Modellen Schauspieler digital verjüngt werden können.

Diese Bandbreite an bekannten und den noch vielen unentdeckten Möglichkeiten reizt mich. Ich werde nach meinem Zwei-Wochen-Versuch und diesem Artikel die DeepFaceLab-Software nicht von einem Rechner löschen, sondern noch eine ganze Weile weiter damit herumexperimentieren und versuchen, weitere Hürden und Herausforderungen zu meistern. Und ich werde schauen, was ich noch dazulernen und über die Deepfake-Community, ihr Tun, ihre Absichten aber vielleicht auch ihre ethischen und moralischen Grenzen herausfinden kann. Und damit, ob und in welche Richtung die Deepfakes steuern werden.

![Tom Cruise is an American Psycho - E02: Hey Paul! [DeepFake]](https://1e9.community/uploads/db1440/original/2X/6/6b8729c5e7ba7fb35e368c15014aedaaf98c4013.jpeg)

Die Möglichkeit, Fotos zu fälschen oder Zitate als „Fake“ zu diffamieren, gibt es schon immer. Das wird nun eben auch auf Videos und Audios ausgeweitet… Ist nicht schön. Aber es ist ja bisher auch nicht so, dass die Medien voll sind mit gefälschten Bildern.

Die Möglichkeit, Fotos zu fälschen oder Zitate als „Fake“ zu diffamieren, gibt es schon immer. Das wird nun eben auch auf Videos und Audios ausgeweitet… Ist nicht schön. Aber es ist ja bisher auch nicht so, dass die Medien voll sind mit gefälschten Bildern.