Von Wolfgang Kerler

Wir müssen zuerst über Pornos reden. So eindeutig ist die Statistik. 96 Prozent der rund 14.700 Deepfake-Videos, die bereits im Netz kursieren, sind pornographisch. Das ergab eine Auswertung des niederländischen Start-ups Deeptrace, die gerade erschienen ist. In den gefälschten Pornos sind meistens britische und amerikanische Schauspielerinnen oder koreanische Musikerinnen zu sehen, wie sie vermeintlich Sex haben. In Wahrheit wurden ihre Gesichter mithilfe von Künstlicher Intelligenz auf die Köpfe von Pornodarstellerinnen verpflanzt.

Sogar der inzwischen für alle möglichen gefälschten Videos gebrauchte Begriff Deepfake geht auf die Manipulation von Pornos zurück. Im November 2017 startete der Reddit-User u/deepfakes ein gleichnamiges Forum, um sich mit anderen darüber auszutauschen, wie man Deep-Learning-Software nutzen könnte, um die Gesichter von Pornodarstellerinnen auszutauschen – mit denen von weiblichen Stars. Dieses Faceswapping wurde erst durch die Fortschritte der KI-Entwicklung außerhalb von Hollywood-Studios möglich und erschwinglich.

Das Reddit-Forum wurde schon im Februar 2018 dicht gemacht. Doch die Deepfakes waren nicht mehr zu stoppen. Jeder, der das nötige Wissen, die nötigen Rohdaten und die nötige Rechenpower hat, kann mit frei zugänglicher Software wie Faceswap oder DeepFaceLab synthetische Videos mit ausgetauschten Gesichtern erstellen. Auch auf YouTube und Instagram lassen sich inzwischen viele – nicht pornografische – Beispiele finden.

Mark Zuckerberg spricht endlich Klartext

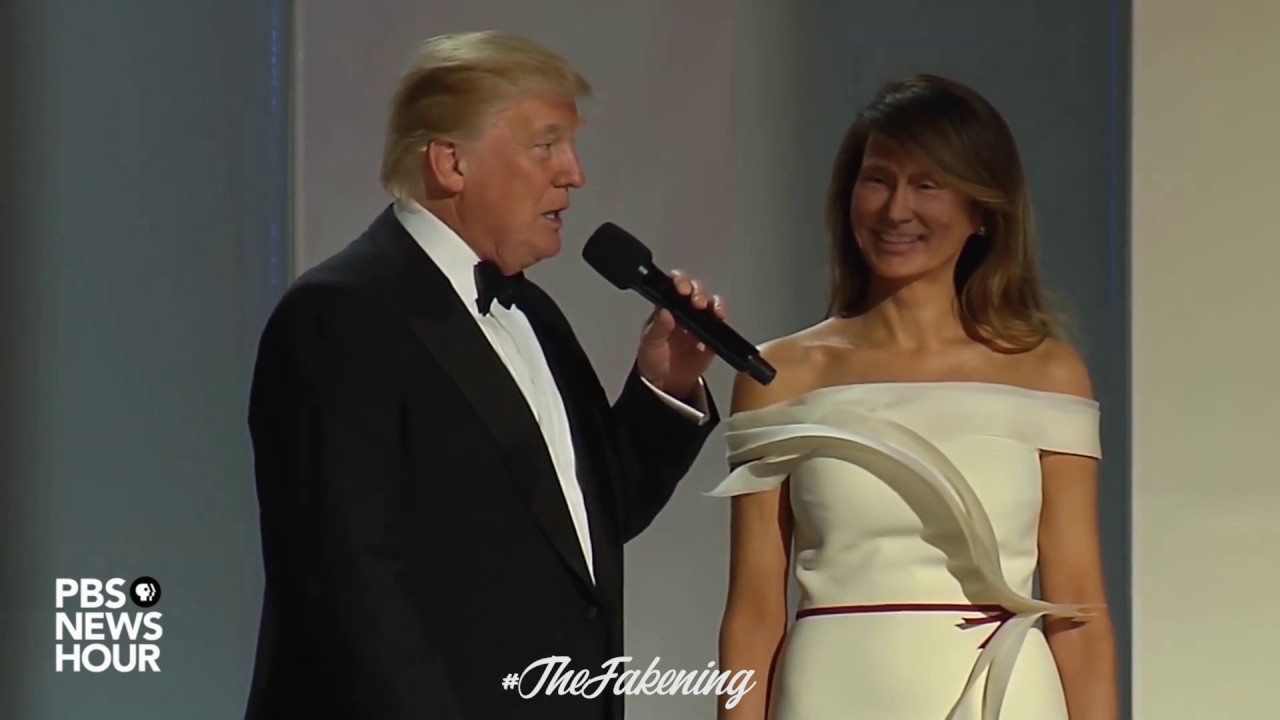

Wenn allerdings neben Donald Trump plötzlich ein langhaariger Wladimir Putin im Abendkleid lächelt oder Mark Zuckerberg offen zugibt, dass es bei Facebook nur darum geht, intime Daten von Nutzern zu verwerten, ist bisher jedem klar: Diese Videos können nicht echt sein, sie sind Satire oder Kunst. Die meisten Deepfakes sehen bisher auch noch nicht völlig überzeugend aus – und hören sich auch nicht so an.

Allerdings dürfte es nur eine Frage der Zeit sein, bis sich das ändert. Synthetische Fotos, auf denen fiktive menschliche Models zu sehen sind, die es nie gegeben hat, lassen sich schon heute nicht mehr mit bloßem Auge als Werk einer Künstlichen Intelligenz identifizieren. Was passiert also, wenn Deepfake-Videos und gefälschte Sprachaufnahmen ebenso perfekt daherkommen? Drohen uns dann Desinformationskampagnen, wie es die amerikanischen Geheimdienste oder die EU-Kommission befürchten? Oder liegen die Risiken eigentlich ganz woanders?

Die Experten, mit denen 1E9 gesprochen hat, beurteilen die Lage recht differenziert. Fangen wir damit an, welche Gefahren sie sehen, bevor wir auf die Lösungen zu sprechen kommen.

Sind Lügner die großen Gewinner?

„Von allen Deepfake-Videos, mit denen ich bisher zu tun hatte, hatte ausgerechnet eines die größten Auswirkungen, das wahrscheinlich gar kein Fake war“, sagt Giorgio Patrini im Gespräch mit 1E9 – hier ist er als @giorgiop Mitglied. Er ist Chef und Entwicklungsleiter von Deeptrace, dem Start-up, das die oben zitierte Studie veröffentlicht hat und das an Software arbeitet, mit der Fake-Videos identifiziert werden können. Sein Statement bezieht sich auf ein Video, das zum Jahreswechsel 2018/2019 im zentralafrikanischen Gabun für eine Staatskrise sorgte. Als erstes westliches Medium hatte das Magazin Mother Jones darüber berichtet.

Ende des vergangenen Jahres gab es in Gabun Spekulationen über den Gesundheitszustand des Präsidenten Ali Bongo, weil er seit Oktober nicht in der Öffentlichkeit zu sehen war. Manche behaupteten, er wäre tot. Um gegenzusteuern, veröffentlichte die Regierung pünktlich die Neujahrsansprache des Politikers. Doch diese heizte die Gerüchte noch an, denn Ali Bongo hinterließ einen sonderbaren Eindruck – seine Mimik und Gestik wirkte aus Sicht von Kritikern unnatürlich. Ein Oppositionspolitiker bezeichnete das Video schließlich als Deepfake.

Eine Woche nach Veröffentlichung der Ansprache versuchten Teile des Militärs in einem missglückten Staatsstreich die Macht in Gabun an sich zu reißen. Als einen Beleg dafür, dass mit dem Präsidenten etwas nicht stimmte, wurde die Merkwürdigkeit des Videos genannt.

Der Verdacht der Fälschung wurde bisher allerdings nicht bestätigt. Forensische Untersuchungen – auch von Deeptrace – konnten keine Beweise dafür liefern, dass das Video manipuliert wurde. Hundertprozentig ausschließen ließ es sich bisher aber auch nicht. Allerdings gab es ohnehin eine andere mögliche Erklärung für die seltsame Anmutung des Videos: Ali Bongo erholte sich zur Zeit der Aufzeichnung von einem Schlaganfall. Dass der Präsident lebt, ist inzwischen ebenfalls klar, da er wieder öffentliche Auftritte absolvierte.

Ausführlich erklärte Giorgio Patrini den Vorfall in Gabun, seine Einschätzung zur Gefahr, die von Deepfakes ausgeht, und was er und Deeptrace dagegen tun wollen, auch auf der diesjährigen DMEXCO-Konferenz im Gespräch mit @Wolfgang von 1E9.

Der Punkt, den Giorgio Patrini mit diesem Beispiel machen will: „Allein die Tatsache, dass Leute über die Existenz von Technologie Bescheid wissen, mit der man Videos so realistisch fälschen kann, stellt bereits eine Bedrohung für die Demokratie, für die Medien und die Gesellschaft dar“, erklärt er. „Jeder kann nun die Aussagekräftigkeit von Videos in Zweifel ziehen.“ Für Audios, die ebenfalls mit KI gefälscht werden können, gelte das natürlich auch.

Die amerikanischen Juraprofessoren Danielle Citron und Robert Chesney haben für dieses Problem inzwischen einen Begriff geprägt: liar’s dividend , die Lügnerdividende. In einem TED-Talk definierte Citron diese kürzlich als „das Risiko, dass sich Lügner auf Deepfakes berufen, um sich der Verantwortung für ihr Fehlverhalten zu entziehen“. Auch andere mögliche krasse Folgen von Deepfakes schildert Citron – etwa, wenn in arabischen Staaten Fake-Videos die Runde machen würden, in denen amerikanische Soldaten den Koran verbrennen.

Für Desinformation braucht es keine Deepfakes

Weniger dramatisch stuft Alexander Sängerlaub die Gefahr durch Deepfakes ein. „Bildmanipulationen gab es schon zu Zeiten von Stalin“, sagt er zu 1E9. „Auch in der Filmindustrie werden schon lange Bilder manipuliert. Dafür mussten wir nicht auf Deep Fakes warten. Das einzige, was passiert, ist, dass es komfortabler und günstiger wird, manipulierte Videos herzustellen.“

Alexander Sängerlaub, hier bei 1E9 als @constructivealex, leitet bei der Stiftung Neue Verantwortung, einem Berliner Think Tank, das Projekt „Stärkung digitaler Öffentlichkeit“ und untersucht seit Jahren, wie sich Fake News über soziale Medien verbreiten und welchen Einfluss sie auf Wahlen haben können. Sein Hauptargument dafür, dass Deepfakes keine neue Bedrohungskategorie darstellen: Sie seien ziemlich überflüssig.

„Ich brauche kaum technische Mittel, um Fakes herzustellen, die sich rasend schnell in sozialen Netzwerken verbreiten“, sagt er. „Beim Video der angeblich betrunkenen Nancy Pelosi wurde einfach die Geschwindigkeit verringert. Oft reicht es auch, Bilder, Videos oder Zitate in einen neuen Kontext zu setzen.“ Statt Deepfakes reichen bisher Cheap Fakes , also: billige Fakes.

Recht gelassen sieht auch Matthias Nießner das politische Risiko, das Deepfakes und andere gefälschte Videos darstellen. „Ob von einem potenziellen Putin-Trump-Hybrid so viel Gefahr ausgeht, wage ich zu bezweifeln“, sagt er zu 1E9. Er ist Professor an der Technischen Universität München, war zuvor in Stanford und gehört zu den Pionieren der synthetischen Videos. 2016 präsentierte er die von ihm mitentwickelte Software Face2Face, die in Echtzeit die Mimik einer Person auf eine andere Person übertragen kann. Im amerikanischen Fernsehen transformierte er damit sogar den Showmaster Jimmy Kimmel ins Gesicht von Mike Tyson.

„Ich sehe eher Dinge wie Rache-Pornos oder High-School-Mobbing als Gefahr“, führt Nießner weiter aus. „Hier ist es teilweise völlig egal, ob man erkennt, dass eine Sequenz gefälscht ist. Der Schaden für die betroffene Person ist so oder so da.“

Das musste auch die indische Investigativ-Journalistin Rana Ayyub erleben. Nachdem sie in TV-Interviews kritisiert hatte, dass Kinderschänder in Indien geschützt würden, zirkulierten zunächst gefälschte Zitate von ihr auf Twitter. Anschließend verbreitete sich ein Deepfake-Pornovideo, in dem sie zu sehen war, über WhatsApp und andere soziale Medien – zunächst in Kreisen nationalistischer Politiker, dann wurde es über 40.000-mal geteilt wurde.

Eine gigantische Welle an Hass, Drohungen und Beschimpfungen schwappte digital über sie herein. „Ich war einem Lynchmob in Indien ausgesetzt. Die Leute dachten jetzt, sie könnten mit mir machen, was sie wollen“, schrieb sie in ihrem persönlichen Bericht, der auf Deutsch bei Focus Online erschienen ist.

Software, die Fake-Videos erkennt

Unabhängig davon, welche Befürchtungen sich als begründet darstellen und welche nicht: Wir werden technische Lösungen brauchen, wie wir Deepfakes erkennen können. Sowohl Matthias Nießner als auch Giorgio Patrini und einige andere Teams weltweit arbeiten genau daran. Zusätzlich wird es auch weiterhin Menschen brauchen, die mithilfe von Recherche, Wissen und Technologie Informationen und Desinformationen unterscheiden können. Da sind sich die meisten Experten einig.

Matthias Nießner und sein Team von der TU München haben mit FaceForensics (++) bereits eine Software veröffentlicht, die manipulierte Videos von Gesichtern erkennen kann – selbst wenn die Bilddateien stark komprimiert wurden. Insgesamt wünscht sich der Münchner Forscher einen sensibleren Umgang mit digitalen Informationen. „Daher wäre es sehr wünschenswert, wenn man dem Nutzer eines Browsers eine Analyse der Bilder oder Videos, die angezeigt werden, bereit stellen kann“, sagt er. Genau das soll durch FaceForensics (++) möglich werden.

Einzuschätzen, ob Informationen wahr oder falsch sind – dafür gibt es Journalismus.

Deeptrace von Giorgio Patrini entwickelt eine Deep-Learning-Software, die beispielsweise von Journalisten eingesetzt werden kann. Sie erkennt Manipulationen an Videos, die für das menschliche Auge nicht zu bemerken sind. Außerdem berücksichtigt sie die Metadaten der Clips, in denen sich Spuren der verwendeten Algorithmen finden können, und sie sucht nach ähnlichen Videos, die möglicherweise zeitlich früher erschienen und die Originale sein könnten.

„Wir arbeiten mit Machine Learning “, sagt Giorgio Patrini, „also wird die Software keine Schwarz-Weiß-Antworten liefern, sondern den Grad angeben, zu dem das Video vertrauenswürdig ist.“ Am Ende könnte dann der Journalist entscheiden, wie er die Informationen einordnet, die ihm das Programm liefert. „Einzuschätzen, ob Informationen wahr oder falsch sind – dafür gibt es Journalismus“, sagt auch Alexander Sängerlaub. „Der ist eigentlich noch viel notwendiger als früher, weil wir heute viel mehr Informationen und Desinformationen haben.“

Insgesamt sind die drei Experten, mit denen 1E9 gesprochen hat, optimistisch, dass wir Deepfakes in den Griff kriegen – zumindest, was die Gefahren für unsere Demokratie angeht. Gefälschte Pornos könnten am Ende also das größere Problem darstellen.

Teaser-Bild: Screenshot von einem YouTube-Video des Channels The Fakening

Achtung: 1E9 soll die neue Community für Zukunftsoptimisten werden. Wir sind derzeit noch in der Closed Beta, aber du kannst dich hier auf die Warteliste setzen lassen. Dann melden wir uns schon bald!