Können Deepfakes wirklich Menschen täuschen? Australische Forscher fanden nun heraus, dass das Gehirn unterbewusst Fehler in KI-geschaffenen Gesichtern ausmachen kann. Das könnte helfen, Software zu entwickeln, die die Fälschungen entlarvt.

Von Michael Förtsch

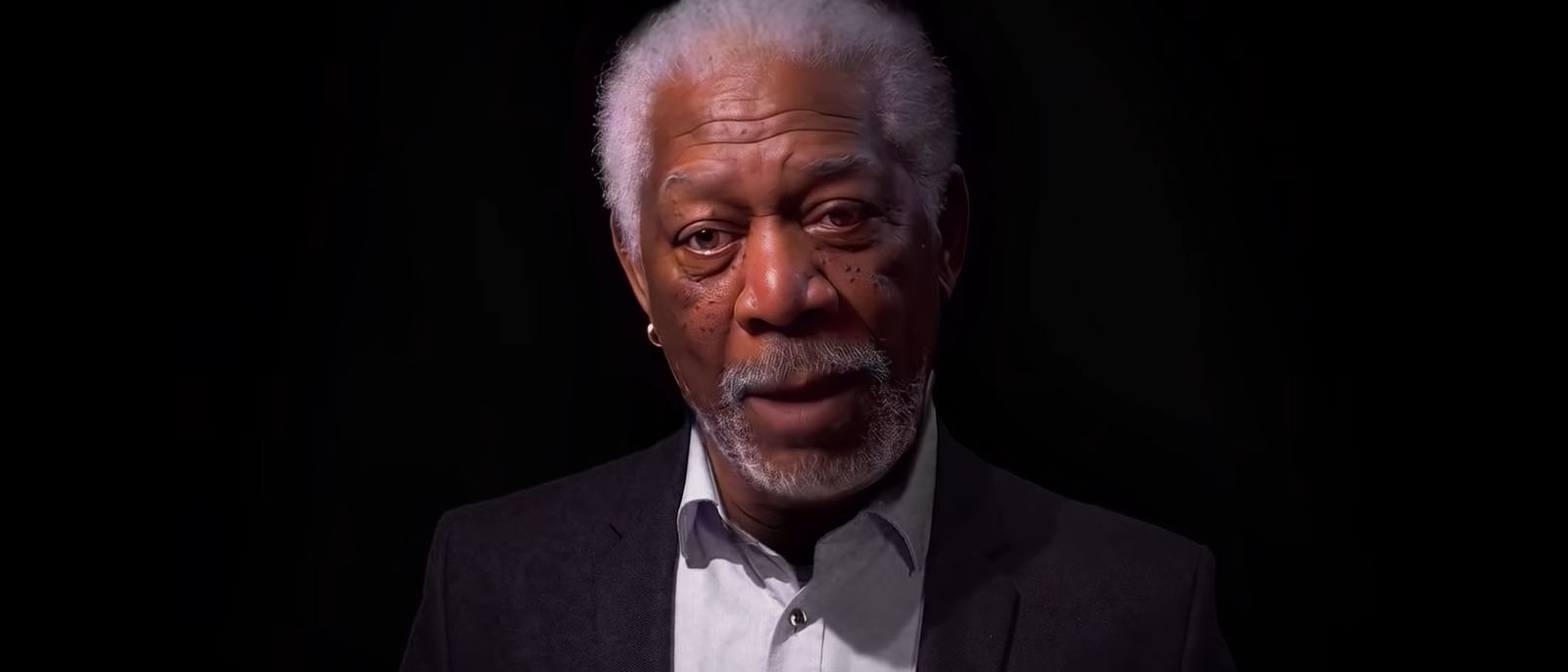

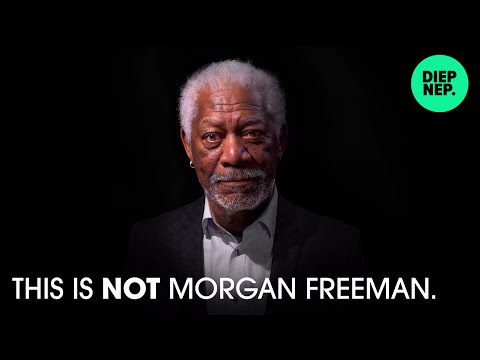

Vor fünf Jahren sorgten Deepfakes erstmals für ein mediales und gesellschaftliches Echo. Ein Nutzer auf der Social-Media-Plattform Reddit experimentierte mit Künstlicher Intelligenz, um die Gesichter von Personen in Videos gegen die von Prominenten auszutauschen – insbesondere in Pornovideos. Das erregte Aufsehen, Staunen und auch Entsetzen. Nach einigen Wochen war es schon eine ganze Gruppe, die mit der bald schon Deepfake genannten Technologie arbeitete. Ebenso für Aufsehen sorgte die Website thispersondoesnotexist.com, die aufs immer Neue oft sehr realistisch erscheinende Bilder von Personen erzeugt, die es so nicht gibt. Nicht wenige Journalisten, Politiker und IT-Experten sahen in diesen KI-Kreationen eine disruptive Mechanik und sogar eine Gefahr. Denn diese könnten genutzt werden, um Statements von Politikern zu fälschen und das Internet mit Bots zu überfluten, die sich als echte Menschen tarnen.

Mittlerweile werden Deepfakes aber vor allem von YouTubern genutzt, um Schauspieler in Filme zu bringen, in denen sie nie mitgespielt haben. Sie werden von Satirikern eingesetzt, um sich über Politiker lustig zu machen. Sie bringen Prominente in Werbevideos, ohne, dass diese auch nur einmal vor die Kamera treten müssen. Sie lassen Schauspieler erneut als ihr junges Ebenbild in Serien und Filmen auftauchen. Aber ebenso werden via KI erzeugte Gesichter auch tatsächlich genutzt, um etwa Twitter-Bots mit einem menschlichen Antlitz zu versehen. Aber lassen sich Menschen wirklich so einfach von diesen KI-Tricksereien täuschen? Laut einer Studie der University of Sydney ist das nicht so. Wie eine Gruppe australischer Forscher herausfand, nehmen Personen demnach beim Anblick eines Deepfake zumindest unterbewusst wahr, dass „etwas nicht stimmt“.

In ihrer Versuchsreihe haben die Wissenschaftler mehrere Probanden mit Deepfakes und von einer KI erzeugten Gesichtern konfrontiert, während ihr Gehirn mit einem Elektroenzephalogramm überwacht wurde. In 54 Prozent aller Fälle wären Aktivitäten im Gehirn registriert worden, die daraufhin deuten, dass die digitale Person als eine Fälschung erkannt wurde. Wie die Forscher aber auch feststellten, wird die unterbewusste Erkenntnis nicht unbedingt auch bewusst. Denn in nur 37 Prozent der Fälle benannten die Testteilnehmer die Deepfakes verbal als Fälschung.

Werde Mitglied von 1E9!

Hier geht’s um Technologien und Ideen, mit denen wir die Welt besser machen können. Du unterstützt konstruktiven Journalismus statt Streit und Probleme! Als 1E9-Mitglied bekommst du frühen Zugriff auf unsere Inhalte, exklusive Newsletter, Workshops und Events. Vor allem aber wirst du Teil einer Community von Zukunftsoptimisten, die viel voneinander lernen.

Jetzt Mitglied werden!

Vorbild für Deepfake-Software?

Laut Thomas Carlson, dem leitenden Forscher der Studie, sei die „Trefferquote des Gehirns in dieser Studie niedrig“, aber „statistisch zuverlässig“. Das Gehirn könne also mit einer gewissen Akkurates echte von gefälschten Gesichtern unterscheiden. Wie genau es das tut, da sind sich die Forscher unsicher. Hier brauche es mehr Untersuchungen. Allerdings gehen die Wissenschaftler davon aus, dass bestimmte Areale des Gehirns unterbewusst auf Details achten und Fehler erkennen, die beim bewussten Betrachten nicht unbedingt wahrgenommen werden. Ein Beispiel seien sogenannte catch lights, Reflexionen in den Augen, die in nahezu allen Deepfakes nicht zur Umgebung und Lichtsituation passen, die im Video oder Bild vorherrscht.

„Wenn wir lernen können, wie das Gehirn Fälschungen erkennt, könnten wir diese Informationen nutzen, um Algorithmen zu entwickeln, die potenzielle Fälschungen auf digitalen Plattformen wie Facebook und Twitter erkennen“, sagt Carlson. Eine definitive Methode um Deepfakes und KI-generierte Portraits zu entlarven, werde dadurch zwar nicht möglich, aber diese Erkenntnisse könnten Software-Werkzeuge zur Detektion deutlich verbessern.

Hat dir der Artikel gefallen? Dann freuen wir uns über deine Unterstützung! Werde Mitglied bei 1E9 oder folge uns bei Twitter, Facebook, Instagram oder LinkedIn und verbreite unsere Inhalte weiter. Danke!

Sprich mit Job, dem Bot!

War der Artikel hilfreich für dich? Hast du noch Fragen oder Anmerkungen? Ich freue mich, wenn du mir Feedback gibst!

![Tom Selleck is Indiana Jones [Deep Fake]](https://1e9.community/uploads/db1440/original/2X/7/7b5ab1a3292a8e4c52f77c01a5938cddc31e126e.jpeg)