In nur wenigen Jahren sind Deepfakes von der Internetkuriosität zu echten Werkzeugen für Künstler und Medienmacher geworden. Vor allem YouTuber zeigen immer wieder, was damit schon geht. Tatsächlich hat die Technologie das Zeug dazu, Film und Fernsehen zu revolutionieren und Schauspieler unsterblich zu machen.

Von Michael Förtsch

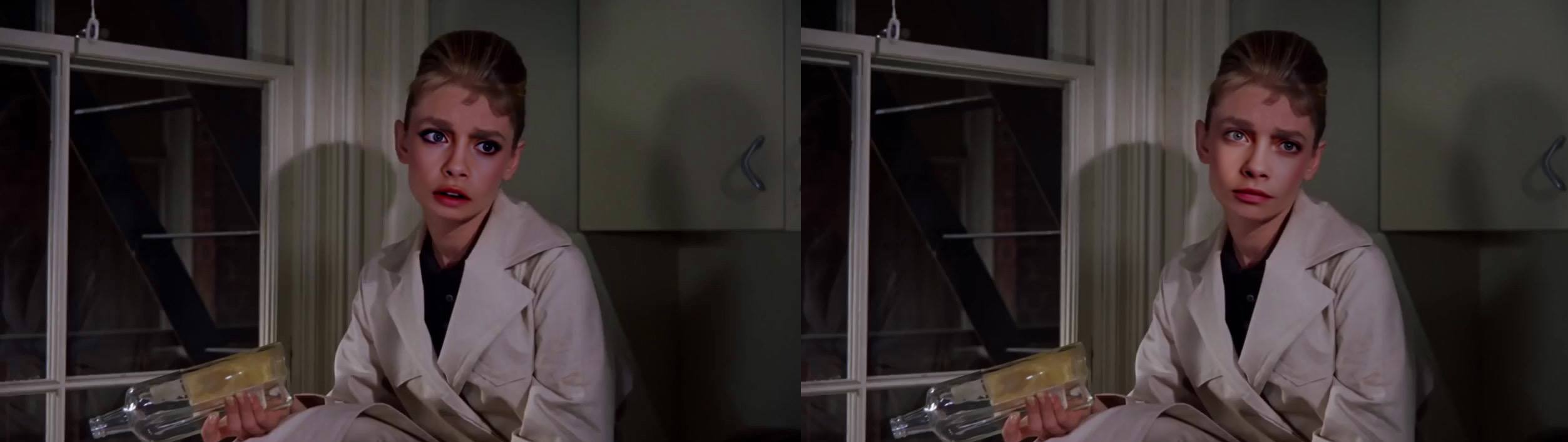

Es ist eine Szene, die es eigentlich nicht geben dürfte. Denn der Regisseur Robert Zemeckis höchstselbst hat festgelegt, dass es nie ein Remake der kultigen Zurück-in-die-Zukunft -Filme geben soll. Zumindest nicht, solange er das verhindern könne. Trotzdem sind hier nun der Spider-Man-Darsteller Tom Holland als Marty McFly und der Iron-Man-Schauspieler Robert Downey Jr. als Dr. Brown zu sehen – in Rollen also, die in der Zurück-in-die-Zukunft -Trilogie eigentlich Michael J. Fox und Christopher Lloyd verkörpern. Dieser Rollentausch ist jedoch nicht das Werk eines Hollywood-Studios oder eines raffinierten Produzenten, der den Willen von Robert Zemeckis überging, sondern das eines Filmfans. Der YouTuber EZRyderX47 hat die beiden Stars der Marvel-Superhelden-Filme mittels Deepfake-Technologie in den Kultstreifen aus dem Jahr 1985 gebracht. Oder zumindest deren von einer Künstlichen Intelligenz nachgebildeten Gesichter.

Das ist dem Deepfake-Künstler so überzeugend gelungen, dass es selbst den Schauspieler Tom Holland ziemlich beeindruckt und amüsiert hat – der in der Realität keineswegs in einem echten Remake der Filmreihe mitwirken wolle, wie er sagt. Dass ein solcher Blick auf eine alternative Filmrealität möglich ist, macht allerdings offenbar, wie rasant sich Deepfakes entwickelt haben. Vor drei Jahren zog die auf Künstlicher Intelligenz basierende Technik erstmals mediale Aufmerksamkeit auf sich, als ein Nutzer namens Deepfakes auf Reddit begann, damit Gesichter von Schauspielerinnen wie Gal Gadot auf die Körper von Pornodarstellerinnen zu montieren. Abgesehen davon, dass das ethisch und moralisch mehr als verwerflich ist, waren auch die Ergebnisse da noch eher schlecht als recht. Die Gesichter flackerten sichtlich, wirkten platt und irgendwie stumpf.

Dass sich das so schnell änderte, liegt an der großen und sehr aktiven Community, die sich um die Technik gebildet hat. Denn die besteht aus äußerst passionierten Enthusiasten aber auch Software-Entwicklern, Künstlern und Grafik-Spezialisten. Die nahmen sich der zu Beginn noch sehr rudimentären und umständlich zu nutzenden Technologie an – und trieben die Entwicklung voran. Und sie setzten sie für Video- und Fake-Experimente jenseits der Pornographie ein. Nicht zuletzt für Satire- und Kunstvideos, die Hollywood-Produktionen mit anderen Stars besetzen, Schauspieler digitale Zeitreisen unternehmen lassen, tote Ikonen wiederbeleben oder Donald Trump und Vladimir Putin hochnehmen. Das alles gibt einen Vorgeschmack darauf, wie diese Technologien in wenigen Jahren sowohl Film, Fernsehen als auch den ganzen Kulturbetrieb verändern könnten.

Werde Mitglied von 1E9 – schon ab 3 Euro im Monat!

Als Mitglied unterstützt Du unabhängigen, zukunftsgerichteten Tech-Journalismus, der für und mit einer Community aus Idealisten, Gründerinnen, Nerds, Wissenschaftlerinnen und Kreativen entsteht. Außerdem erhältst Du vollen Zugang zur 1E9-Community, exklusive Newsletter und kannst bei 1E9-Events dabei sein.

Jetzt Mitglied werden!

Die Zukunft ist schon zu sehen

Natürlich sind schon jetzt viele Szenen in Filmen rein im Computer entstanden. Ganze Kulissen, Monster, Raumschlachten und Armeen werden von Special-Effects-Studios geschaffen. Und natürlich sind seit mehreren Jahren auch digitale Darsteller auf den Leinwänden. Für Rogue One: A Star Wars Story ließ Gareth Edwards den bereits 1994 verstorbenen Peter Cushing in seiner Rolle des Grand Moff Tarkin wiederbeleben. Ebenso wurde das Gesicht der jungen Carrie Fisher für einen Auftritt der ebenso junge Leia Organa digital rekonstruiert – und dann auf den Kopf einer anderen Schauspielerin gesetzt. Das gleiche geschah mit Sean Young, die als altersloser Bioroboter Rachael in Blade Runner 2049 zu sehen ist, ohne jemals selbst das Set betreten zu haben. Ihr jeweils eigenes Antlitz um einige Jahrzehnte verjüngt trugen wiederum Robert De Niro und Al Pacino im Gangster-Epos The Irishman. Grafiker und 3D-Künstler hatten ihre Gesichter anhand von alten Filmaufnahmen und Fotografien nachmodelliert.

Die Ergebnisse waren interessant anzusehen, aber für viele Filmfans nicht überzeugend – jedenfalls nicht überzeugend genug. Teilweise wurden sie sogar belächelt, weil sie trotz der Millionen, die in ihre Produktion geflossen waren, allzu maskenhaft und artifiziell wirkten. Umso imposanter war es, als einige Deepfake-Künstler daraufhin von ihnen mit Deepfake-Software überarbeitete Szenen zeigten. In denen erschienen die The-Irishman -Gangster und Prinzessin Leia um ein Vielfaches lebendiger und authentischer. Anstatt die Gesichter von Grund auf neu zu modellieren, hatten die Deepfaker ihre KI-Software mit tausenden Bildern der Schauspieler aus ihren jungen Jahren gefüttert. Die Künstliche Intelligenz lernte das Gesicht so gut wie möglich und bildete es nach.

Warum tun das Hollywood-Studios dann nicht ebenfalls? Nun, das tun sie – aber sehr zögerlich. In Detective Pikachu verjüngte das Effektstudio Framestore den Schauspieler Bill Nighy mittels Deepfake. Allerdings nur um wenige Jahre und nur für einige Sekunden – weshalb dieser Effekt für die Zuschauer vollkommen unbemerkt blieb. Dafür lohnte es sich nicht, eigens in Handarbeit ein digitales Gesicht zu modellieren. „Wir konnten einfach ein jüngeres Antlitz des Schauspielers nehmen und das Deepfake-Model darauf trainieren“, sagte Tim Webber von Framestore. Aber für längere und aufwendigere Szenen mögen Studios noch nicht auf Deepfakes vertrauen – und das hat durchaus seinen Grund.

Eine KI-Blackbox?

Die Technologie hinter Deepfakes, das Machine Learning, wird als Ausgangsmaterial mit Bildern von Gesichtern gefüttert. Je mehr, umso besser. Jedoch lässt sich nie genau sagen, was die Software letztlich daraus macht. Ein Training für ein und dasselbe Gesicht, das bis auf wenige Ausnahmen mit denselben Bildern stattfindet, kann zu unterschiedlichen Ergebnissen führen. Zwar steht am Ende das gleiche und auf den ersten Blick identische Gesicht. Aber die Ausprägung von Wangen, Lippen oder auch „mit gelerntem“ Make-up wie Lidschatten kann unterschiedlich ausfallen. Wie genau das zustande kommt, bleibt oft ein Geheimnis, da die Künstliche Intelligenz ihre Resultate und Entscheidungen nicht erklären kann. Das macht Deepfakes für die breite Anwendung im Filmgeschäft derzeit zu wenig berechen- und kontrollierbar.

„Mit Deepfakes kann man in manchen Fällen ein überzeugendes Ergebnis erzielen“, sagt etwa Stuart Adcock vom Special-Effects-Studio WETA Digital. Aber für Film- und Fernsehproduktionen müssten die Special-Effects-Macher die Kontrolle haben. „Sie müssen Augen- und Lippenbewegungen steuern können“, so Adock. Das geht bei Deepfakes nicht. Zumindest noch nicht zuverlässig. Deepfake-Künstler arbeiten aber durchaus daran, die KI-Technologie nach und nach mit klassischen 3D- und Digital-Special-Effects zu verheiraten. Beispielsweise um mittels weiterer Tools wie Adobe After Effects oder Blender nachträglich die Bewegungen von Augen und Mund nachsteuern zu können, Glanz, Schweiß, Tränen oder detailreichere Hauttexturen auf das Gesicht zu bringen. Oder auch um unsaubere Übergänge vom neuen Gesicht zum Originalkopf zu kaschieren. Wie das ausschaut, das wollen bald erste Deepfaker zeigen.

Und auch einige Special-Effect-Unternehmen nehmen sich der Technik durchaus an. Nur wollen sie damit noch nicht groß hausieren gehen, wie The Hollywood Reporter erfuhr. Digital Domain, das Effekt-Studio hinter Avatar, soll bereits an einer eigenen Fassung der Deepfake-Technologie arbeiten, die Ähnliches möglich machen soll wie die Fake-Tools DeepFaceLab, FaceSwap und FakeApp. Nur eben in einer Weise, die eine deutlich professionellere, kontrolliertere und skalierbare Nutzung erlaubt. Und auch beim Star-Wars - und Marvel -Effekt-Studio ILM werde, wie ein Manager sagte, zumindest viel über die Technik gesprochen und ob sie es nicht wert wäre, dass man sie mal „formal evaluiert“. Schließlich sei die aufwendige 3D-Technik, die man gerade verwendet „nicht gerade billig zu haben“.

Die Fake-KI könnte da eine günstigere und auf Dauer vielleicht sogar mächtigere Alternative darstellen. Und damit auch vollkommen neue Dinge ermöglichen. Daher sind diese Studios auch in Kontakt mit einigen der Deepfake-Künstlern, deren Werke in den letzten Monaten für Aufsehen sorgten. „Ja, klar, da sind schon Leute auf uns zugekommen, haben sich in Discord-Kanälen gemeldet und haben gefragt, ob man mal mit uns sprechen könnte“, verrät ein Deepfake-Künstler gegenüber 1E9. „Sie sehen das Potential, das die Deepfakes haben, wollen herausfinden, was geht und wie man das das auch nutzen kann.“ Ein Special-Effects-Studio aus Großbritannien soll, nach einer Beratung mit Hobby-Deepfake-Künstlern, beispielsweise erproben, ob sich bei einem kommenden Hollywood-Action-Film in schnellen Szenen mittels Deepfake das Gesicht des Stuntmans durch das des Hauptdarstellers ersetzen lässt.

Nicht nur das Gesicht ersetzen, sondern den ganzen Körper?

Die Arbeiten von Deepfake-Künstlern beschränken sich momentan noch auf Clips, die teils nur Sekunden und höchstens wenige Minuten lang sind. Das ist dem Aufwand und vor allem den begrenzten Ressourcen geschuldet. Aufwendige Deepfakes verlangen nach schnellen Grafikprozessoren und teils tagelanger Rechenzeit. Wer gute Ergebnisse will, der nutzt daher Cloud-Dienste. Das macht gute Deepfakes teuer. Special-Effects-Unternehmen verfügen da über andere Ressourcen und Möglichkeiten. Sie könnten es Menschen damit ermöglichen, in ihren eigenen biografischen Filmen „mitzuspielen“. Statt einen Schauspieler zu finden, der der Originalperson möglichst ähnlich sieht, spielt das Gesicht in wenigen Jahren möglicherweise keine Rolle mehr.

Der Schauspieler kann dank Deepfake-Technologie letztlich genauso aussehen wie die Person, die er mimt. Er trüge das Gesicht der Person nicht nur wie eine Maske, sondern wie eine zweite Haut. Wie das aussehen könnte, das haben Deepfake-Künstler wie iFake tatsächlich schon in Ausschnitten demonstriert. Der YouTuber ersetze in The Disaster Artist, eine biografische Tragi-Komödie über den Kult-Filmemacher Tommy Wiseau, den Schauspieler James Franco durch Tommy Wiseau selbst. Und das in einer Weise, bei der die Manipulation zumindest auf den ersten Blick kaum zu erspähen ist. Aber letztlich könnte fast jeder Schauspieler mit fast jedem Gesicht ausgestattet werden – so lange es zum Körper und zur Gesichtsform passt.

Vielleicht könnte derartiges sogar ein weiteres (Bezahl-)Feature von Streaming-Diensten wie Netflix, Amazon Prime oder Disney+ werden. Filme und Serien so drehen und mit Bildebenen ausstatten, die die Gesichter der Darsteller austauschen lassen? Aufwendig, aber machbar. Der Zuschauer könnte dann wählen, mit welchem Cast er einen Film genießen möchte – ob er lieber Scarlett Johansson und Chris Hemsworth oder vielleicht doch lieber Ryan Gosling und Margot Robbie in einem Action-Thriller sehen möchte. Tatsächlich wäre es aber auch machbar, dass sich der Zuschauer selbst in einen der Hauptcharaktere eines Filmes verwandelt. Während derzeit noch Tausende bis Zehntausende Fotos nötig sind, um einer KI ein Gesicht beizubringen, könnten in wenigen Jahren eine Handvoll von Fotos genügen, die mit dem Smartphone geschossen werden.

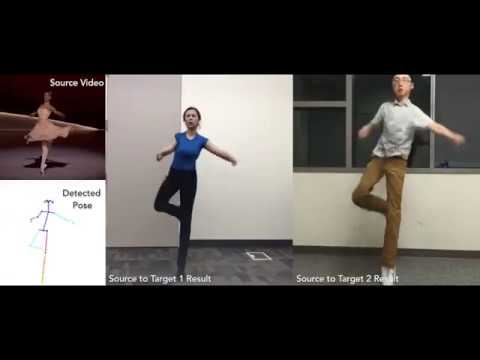

Ist die Technik soweit, wäre es aber vielleicht sogar einfacher den ganzen Körper eines Darstellers gegen einen fremden Körper – oder eben den eigenen – auszutauschen. Ein Ganzkörper-Deepfake? Noch erscheint das ziemlich futuristisch. Aber tatsächlich ist auch das bereits umsetzbar. Schon 2018 veröffentlichte die University of California Berkeley eine Studie namens Everybody Dance Now , in der sie eine Technik zeigt, mit der sich die Bewegungen eines professionellen Tänzers auf einen fremden Körper transferieren lassen – in Echtzeit! Gleiches gelang ein Jahr darauf auch der italienischen Universität Trento.

Die Ergebnisse der Uni-Forscher wirken in den präsentierten Videos noch sehr artifiziell. Sie zeigen grafische Schlieren und Fehler und erscheinen dadurch noch nicht sonderlich überzeugend. Aber diese Ganzkörper-Deepfakes könnten sich ebenso rapide entwickeln wie die Face-Swap-Deepfakes. Zwar wird die Technik noch nicht von einer aktiven Community vorangetrieben, aber von mehreren Start-ups. Die sehen darin nämlich schon unmittelbares Potential. Beispielsweise, um virtuellen Avataren in Videokonferenzen Leben einzuhauchen und holographische Abbilder von Musikern auf echte Bühnen zu holen.

Ebenso ließen sich dadurch Werbevideos mit Hollywood-Stars in Mimik, aber auch Gestik ohne Nachdrehs für verschiedene Länder oder weitere Produkte anpassen. Auch könnte ein und dasselbe Anleitungs-, Fitness- oder Produkterklärvideo für unterschiedliche Sprachen verwendet werden. Einfach in dem durch Deepfake-Technik die Lippen- und Körperbewegungen an die landestypischen Anforderungen angepasst werden. Auch ließe sich dadurch Kleidung, die in einem Werbefilm von einem Supermodel getragen wird, in der nächsten Sekunde auf dem eigenen Körper bewundern. An derartigem arbeiten etwa die Start-ups Synthesia, Canny AI und Superpersonal. Der Schritt zum voll digitalen Deepfake-Star in einem Kinofilm erscheint da nicht mehr weit.

Wenn Tote wieder schauspielern

Wenn Menschen erst in Gänze digital erschaffen und gelenkt werden können, wird das enormen Einfluss haben und die Filmindustrie massiv prägen. Vor allem mit Blick auf die Schauspieler. Diese werden jedoch nicht überflüssig. Sie dürften eher wichtiger werden denn je. „Jemand muss dahinterstehen“, sagt etwa Darren Hendler von Digital Domain dazu. Jemand müsse schließlich die „digitale Körperprothese“ tragen und lenken, den dargestellten Schauspieler mit seinen für ihn typischen Bewegungen, seiner Mimik, seinen „Ticks“ und Eigenheiten glaubhaft verkörpern, die ihn abseits seines Aussehens überhaupt erst so wahrnehmbar und beliebt machten. Und jemand muss ihm auch seine Stimme leihen – zumindest so lange nicht auch die zuverlässig von einer KI generiert werden kann.

Auch bekannte, beliebte und originelle Gesichter wird es dennoch immer wieder geben. Alleine schon, weil Zuschauer auch neue Gesichter und Vertreter aus ihrer Generation auf der Leinwand oder den Bildschirmen sehen wollen. Aber diese bekommen durch ihre digitalen Hinterlassenschaften eben nun auch die Möglichkeit, quasi unsterblich zu werden – indem sie sich durch ihre Schauspielerei, ihre Auftritte oder auch durch explizit für diese Möglichkeit angefertigten Scans, Gesichts- und Vollkörperaufnahmen verewigen. Sollte ein Regisseur beschließen, dass Scarlett Johansson für eine Rolle in seinem Film perfekt wäre, sie jedoch mittlerweile zu alt für genau diese Figur sein, wäre das kein Problem. Er könnte einfach ihr digitales Abbild im richtigen Alter dafür lizenzieren – und auf Basis von Bilddaten nachstellen lassen.

Das ist – mit klassischer Software – abseits von einzelnen Szenen wie in Blade Runner 2049, Star Wars: Rogue One oder The Irishman auch schon in Vollfilmlänge geschehen. Für den Science-Fiction-Thriller Gemini Man ließ Regisseur Ang Lee eine Kopie von Will Smith anfertigen. Erstellt wurde das optisch 25 Jahre junge Abbild mit 3D-Renderprogrammen und Bildmaterial aus der Zeit als der heute 51 Jahre alte Will Smith gerade Der Prinz von Bel-Air drehte. Smith selbst scherzte auf einer Pressekonferenz: „Nun gibt’s eine 23 Jahre alte Version von mir, mit der ich Filme drehen kann.“ Er selbst könne nun „fett und übergewichtig werden“, denn schließlich könnte man einfach sein junges Abbild in kommende Filme einbauen.

Der Scherz von Smith ist aber nicht einmal weit ab von dem was machbar ist und geplant wird. Im Vietnam-Kriegs-Drama Finding Jack soll voraussichtlich im kommenden Jahr der bereits vor über 60 Jahren verstorbene James Dean für „seinen vierten Film, einen Film, den er nie machen konnte“ auf die Leinwand zurückkehren. Die beiden Regisseure Anton Ernst und Tati Golykh haben ihn mit dem Einvernehmen der Angehörigen für eine der Hauptrollen gecastet. Er soll mittels eines Mix aus verschiedenen Technologien wie 3D-Modellen wie in Gemini Man, Überblendungen mit historischen Aufnahmen und möglicherweise auch Deepfake-Rekonstruktionen gemeinsam mit zeitgenössischen Schauspielern auftreten.

Das ist etwas, das vielleicht nicht in den nächsten Jahren, aber definitiv in den nächsten Jahrzehnten von der Ausnahme zur Regel werden könnte. Zumindest wenn Schauspieler damit einverstanden sind. Robin Williams hat beispielsweise verfügt, dass sein Aussehen frühstens 25 Jahre nach seinem Tod wieder kommerziell verwertet werden darf. Warum sollten Filmemacher auch auf derartige Möglichkeiten verzichten? Alfred Hitchcock sagte einst: „Alle Kunst ist Emotion und die Aufgabe des Filmemachers besteht darin, die Werkzeuge seines Mediums zu nutzen, um das emotionale Erleben des Publikums zu manipulieren.“ Einen Schauspieler, selbst wenn er schon eigentlich tot ist, in einer Rolle, die er perfekt ausfüllt, auf den Bildschirm oder die Leinwand zu holen, das wäre so ein Werkzeug, oder?

Allerdings würden Schauspieler wohl nicht nur im Sinne von Hitchcocks Ideal eingesetzt, sondern weil dieser oder jener Schauspieler in der optischen Blüte seiner Jahre viele Zuschauer lockt und damit Geld verspricht. Oder weil dieser oder jener digitale Schauspieler einfach besonders günstig zu lizenzieren war. Das ist natürlich eine Gefahr. Die kennen wir von digitalen Spezial-Effekten und Kulissen. Sie werden von vielen Filmemachern eingesetzt, weil sie günstig und ohne großen Aufwand zu produzieren sind. Geschieht dies nur aus diesem Grund, fällt das allerdings oft negativ auf. Dann sehen CGI-Effekte nach CGI-Effekten aus. Werden solche digitalen Effekte aber mit Bedacht eingesetzt, genutzt, um ein stimmiges Gesamtbild zu zeichnen, dann werden sie fast schon übersehen, weil sie so natürlich wirken. Genauso könnte es auch mit den digitalen Deepfake-Schauspielern sein.

Teaser-Bild: EZRyderX47

![Robert Downey Jr and Tom Holland in Back to the future - This is heavy! [ deepfake ]](https://original.1e9.community/uploads/db1440/original/2X/1/10c8568539fa54d596e206f1da20bad395ddfb15.jpeg)