Künstliche Intelligenz sorgt nicht nur für Innovationen bei der Diagnose von Krankheiten, selbstfahrenden Autos oder Social-Media-Anwendungen. Sie revolutioniert auch die Waffentechnologie. Militärs und Rüstungsunternehmen investieren Milliarden in die Konzeption von autonomen Drohnen und Killer-Robotern. Sie sind schon fast Realität.

Von Michael Förtsch

Es ist sind Szenen, die gegen Ende von Terminator 3: Rebellion der Maschinen zu sehen sind. John Connor und Katherine Brewster dringen in die Militärlabors von Cyber Research Systems ein, um den General Robert Brewster vor der Aktivierung der Künstlichen Intelligenz SkyNet zu warnen. Sie wollen dadurch den Atomschlag der Maschinen gegen die Menschheit und den folgenden Krieg verhindern, bevor er eintrifft. Doch der General glaubt den beiden natürlich nicht – und wenig später infiltriert SkyNet alle Computersysteme der Welt. Kurz darauf bricht in den Gängen der Forschungslabors die Hölle los. Prototypen von autonomen Waffensystemen wie der fliegenden Killer-Drohne Hunter-Killer und dem Schlachtfeldroboter T-1 machen sich selbstständig und löschen Forscher und Soldaten aus.

Die Maschinen, die in dem 2003 veröffentlichten – und eher mittelmäßigen – Science-Fiction-Film zu sehen sind, wirkten seinerzeit noch futuristisch. Heute ist das anders. Ein allmächtiges Programm wie SkyNet oder ein mit fast schon echter Intelligenz ausgestatteter Roboter liegen zwar noch in weiter Ferne. Doch mit moderner Künstlicher Intelligenz – oder besser: mit durch Machine Learning erzeugten Mustererkennungs- und Entscheidungsfindungssystemen – lassen sich Waffensysteme bauen, die ohne menschliche Kontrolle und gelenkt von einem Computersystem handeln und töten können. Zu diesem Schluss kamen Ende 2020 auch Forscher in einem Bericht für den Bundestag. Was „vor nicht allzu langer Zeit ausschließlich in der Domäne der Science-Fiction beheimatet“ war, heißt es in ihrem Bericht, sei „nun an die Schwelle zur konkreten Umsetzung gerückt“. Und in Teilen sogar schon darüber hinaus.

Bereits seit Jahren setzen mehrere Länder auf Waffensysteme, die kaum noch einen Menschen brauchen, etwa auf Loitering Attack Munitions. Dass sind Waffen, die Namen wie Fire Shadow oder IAI Harop tragen und von den USA und Russland über Israel, Chile bis hin zu Südkorea und der Türkei eingesetzt werden. Dabei handelt es sich meist um simple Sprenggranaten mit Flügeln. Angetrieben von kleinen Rotoren können sie stundenlang über Gebieten kreisen und mit Wärmebild- und Radarsensoren nach Zielen suchen – und sich dann darauf stürzen. Es sind ziemlich einfache, aber trotzdem smarte Waffen.

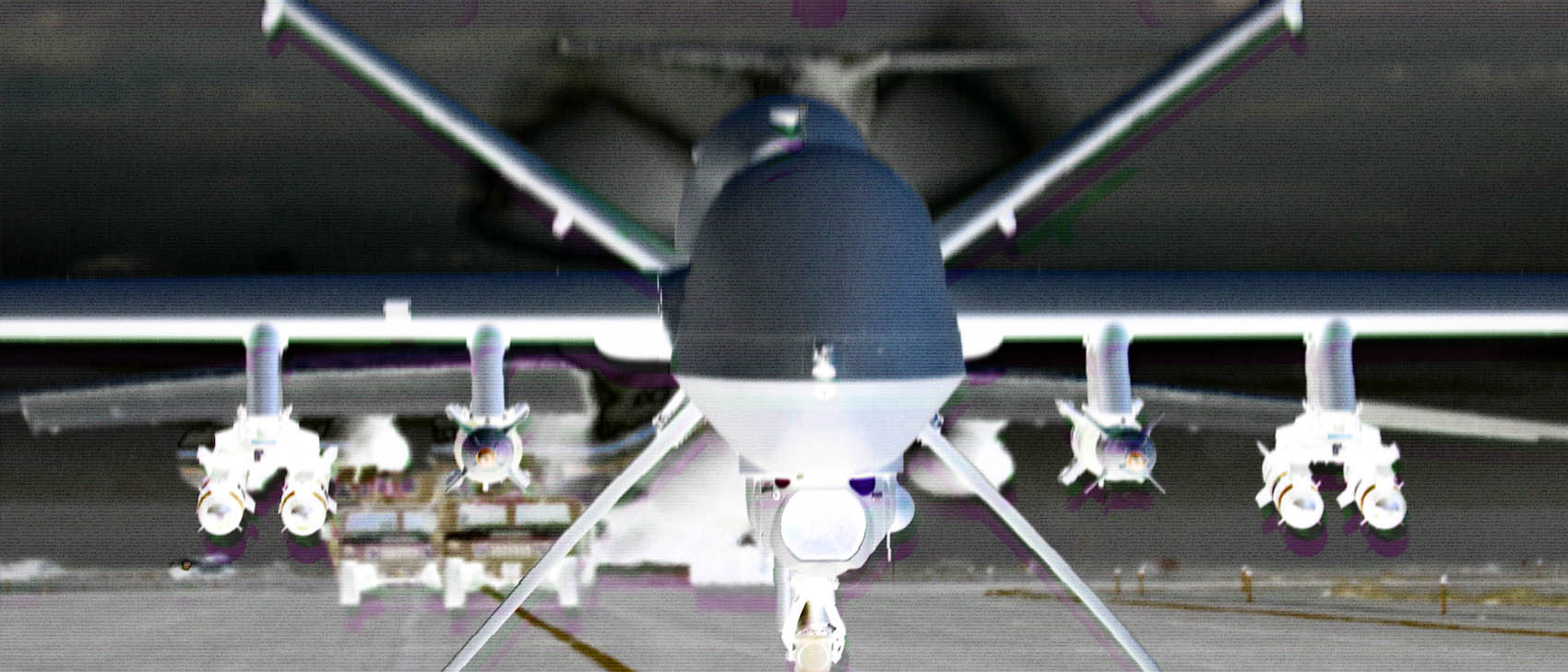

Auch militärische Drohnen wie die Reaper und Predator, die Hermes 450, Kronshtadt Orion oder Wing Loong II sind hoch automatisiert. Sie brauchen eigentlich keinen Menschen mehr am Steuer. Sie können selbst starten, landen und ihren Weg finden. Ebenso können die Kamera- und Computersysteme der Drohnen ganz von selbst potentielle Ziele am Boden ausmachen, verfolgen – und mit Raketen beschießen. Der Part des Menschen ist es nur noch, das Ziel als Feind zu bestätigen und die Tötung zu autorisieren. Das gilt sowohl für die Loitering Attack Munitions als auch für die Drohnen.

„Wir nennen sie die Vorläufer [der voll-autonomen Waffen]“, sagte daher Mary Wareham, Regisseurin und Expertin für Waffen bei Human Rights Watch bei einem Treffen der Vereinten Nation im Jahr 2019. „Wir sind noch nicht ganz bei den autonomen Waffensystemen angekommen, aber wir kommen immer näher.“ Tatsächlich ist der Weg zu vollständig autonomen Waffen, die selbst entscheiden, wer lebt und stirbt, alles andere als weit.

Nur ein Software-Update entfernt

Die digitalen Systeme, die hinter modernen Drohnen und Waffensystemen stehen, könnten schon bald entscheiden, wen sie ins Fadenkreuz nehmen – und ob sie abdrücken. Denn dafür reichen im Grunde die gleichen Programme, Neuronalen Netze und Machine-Learning-Prozesse, die bereits jetzt Gesichts- und Objekterkennung bei Überwachungskameras, Lieferrobotern und autonomen Autos ermöglichen. Es wäre dafür nicht einmal nötig, neue Drohnen zu bauen oder die jetzigen aufwendig umzurüsten. Denn nur ein Teil der Technik steckt in den Waffensystemen selbst.

Das Gros dessen, was etwa eine moderne Drohne oder ein militärischer Roboter tun, wird auf und an Computern auf den zuweilen Tausende Kilometer entfernten Militärbasen entschieden. Zu denen halten die Geräte eine stete Verbindung und senden kontinuierlich einen Strom von hochauflösenden Aufnahmen und Sensordaten, die in Echtzeit analysiert und den fernsteuernden Piloten präsentiert werden. Es bräuchte nur eine Erweiterung der dortigen Softwareinfrastruktur, etwa um KI-Systeme, die auf den Bildern vollkommen automatisch Uniformen, Mündungsfeuer, Waffen und Gesichter erkennen oder die eigenen Soldaten und Feinde ausmachen können. Zusätzlich wäre eine Entscheidungs- und Taktikroutine denkbar, die dann ableitet, ob und wie der Waffeneinsatz erfolgen soll.

https://www.youtube.com/watch?v=ITTvgkO2Xw4&feature=youtu.be

Solche KI-Systeme sind längst in Entwicklung und in Teilen sogar schon erprobt. Mit dem einst wegen der Mitarbeit von Google bekannt gewordenen Project Maven des US-Militärs etwa soll ein System entstehen, bei dem eine KI selbstständig Objekte auf Drohnen- und Satellitenbildern identifiziert, um diese Informationen an Analysten weiterzuleiten. Die nun vom umstrittenen Überwachungs- und Spionageunternehmen Palantir weiter entwickelte Software könnte jedoch genauso gut genutzt werden, um ad hoc vermeintliche Terroristen in den Videobildern von Killer-Drohnen auszumachen.

Das Office of Naval Research der US-Marine wiederum arbeitet seit mehreren Jahren an einem Projekt namens Swarm Boats. Ziel sind automatisierte Boote, die selbstständig Flugzeugträger und Kreuzer beschützen. „Die neue Technologie ermöglicht es den USVs – den unbemannten schwimmenden Vehikeln –, angreifende Gegner zu erkennen, abzuschrecken oder zu zerstören“, heißt es auf der Seite zum Projekt. Noch muss die Kommandobrücke jeden Schuss eines Bootes bestätigen. Aber bei einem Test mit mehreren autonomen Booten im Jahr 2014 konnte das Control Architecture for Robotic Agent Command and Sensing – kurz CARACaS – getaufte System bereits andere Boote als feindlich identifizieren und den Schwarm erfolgreich darauf ansetzen.

Die vom einstigen Oculus-Erfinder Palmer Luckey gegründete Rüstungsfirma Anduril entwickelt seit einigen Jahren die Softwareplattform Lattice, die Sensordaten verarbeitet. Sie informiert etwa Beamte, wenn Menschen ohne Genehmigung die Grenze überqueren oder in eine Militärbasis eindringen. In Zukunft soll sie ganz von selbst Drohnen aktivieren und aus der Höhe die Ziele überwachen, wenn auch nicht töten lassen. Kein Mensch muss dies autorisieren oder darüber vorab informiert werden.

Tatsächlich, so glauben einige KI-Forscher und Menschenrechtsaktivisten, könnten die Militärs einiger Länder bereits jetzt den human in the loop auslassen. Also Drohnen und anderen modernen Kampffahrzeugen die Tötungsentscheidung überlassen – und den Menschen aus der Rechnung entfernen. Es sei dann nur die Frage, wie viele Fehler die Algorithmen machen – also wie viele Unschuldige, Unbeteiligte und eigene Soldaten beim Einsatz sterben –, und ob das Militär bereit ist, das in Kauf zu nehmen. Letztlich sei es aber eher eine Frage von „Jahren nicht Jahrzehnten“ bis erste Staaten den Systemen Autonomie zugestehen, sagt Mary Wareham.

Autonome Panzer und Killer-Schwärme

Dass Militärs und Regierungen selbsttätig agierende, mobile Waffen als die Zukunft sehen, lässt sich nicht leugnen. Bereits jetzt werden zahlreiche Waffenprojekte von vornherein daraufhin entwickelt, ohne Mensch am Kontrollpult zu funktionieren. Milliarden fließen in Unternehmungen wie SkyBorg, mit dem die US-Luftwaffe ein unbemanntes Kampfflugzeug bauen will, das neben menschlichen Piloten im Luftkampf agieren kann. Andere Waffensysteme wie der Ende 2019 vorgestellte Mini-Panzer RIPSAW M5 sind zwar noch ferngesteuert. Jedoch ist der Wohnwagen-große Elektro-Panzer so konzipiert und mit genügend Kameras und Sensorik ausgestattet, dass es auch hier nur ein Software-Update bräuchte, um ihn der Kontrolle einer Künstlichen Intelligenz zu unterstellen. Auch der russische Panzer Armata T-14 soll, wenn die Technik ausgereift ist, nicht mehr von Menschen, sondern einer KI aus der Ferne gelenkt werden.

https://www.youtube.com/watch?v=8NX7btiWLa0

Aber auch deutlich kleinere Killer-Roboter und Drohen wie der Hunter-Killer aus Terminator 3 sind bereits Realität. Seit 2019 verkauft das chinesische Unternehmen Ziyan AV mit dem Blowfish A3 beispielsweise einen Mini-Helikopter, der ein Sturmgewehr tragen kann – und „für voll-autonome“ Steuerung ausgelegt ist. Erst Ende 2020 zeigte das chinesische Militärs den Prototypen eines Systems, das Dutzende von kleinen Drohnen hoch in die Luft feuert. Sie werden kurz vor dem Abschuss kabellos mit den Zielmustern programmiert und können sie dann mit integrierter Kamera und Mustererkennung anpeilen und sich mit einer kleinen Explosivladungen darauf stürzen.

Genau vor solchen Waffen haben Wissenschaftler wie der verstorbene Stephen Hawking oder Tesla-Chef Elon Musk bereits vor Jahren in einem offenen Brief gewarnt. „Wir sind wie Kinder auf einem Spielplatz,“ sagte Elon Musk 2018 im Interview mit Axios zum Thema Künstliche Intelligenz. „Du könntest für kleines Geld einen Schwarm von Attentäter-Drohnen bauen.“ Dafür brauche es nur die Chips und Gesichtserkennungstechnologie, die bereits in vielen Smartphones steckt. Kombiniert mit kleinen Drohnen und einer Explosivladung könnten sie als fliegende Killer genutzt werden, die, wenn sie „die Person finden, die sie suchen, kollidieren und explodieren.“

https://www.youtube.com/watch?v=9CO6M2HsoIA

Auch der Kurzfilm Slaughterbots des Informatikers Stuart Russell machte auf die Gefahr solcher Waffenkonzepte aufmerksam – und zeigte auf, dass, wenn das Militär sie nutzen wird, der Weg zu autonomen Drohnen und Robotern als Terrorwaffe nicht weit ist. „Dieser Kurzfilm ist mehr als nur Spekulation“, sagte Russel. „Er zeigt lediglich die Ergebnisse der Integration und Miniaturisierung von Technologien, die wir bereits haben.“ Mit dem Fortschreiten der Drohnen- und Robotertechnik, der Zugänglichkeit und wachsenden Kapazität von KI-Software, könnten solche Waffensysteme in nicht einmal zwei Dekaden so verbreitet und günstig sein, wie jetzt Kalaschnikow-Gewehre.

Verstehe, was die Zukunft bringt!

Als Mitglied von 1E9 bekommst Du unabhängigen, zukunftsgerichteten Tech-Journalismus, der für und mit einer Community aus Idealisten, Gründerinnen, Nerds, Wissenschaftlerinnen und Kreativen entsteht. Außerdem erhältst Du vollen Zugang zur 1E9-Community, exklusive Newsletter und kannst bei 1E9-Events dabei sein. Schon ab 2,50 Euro im Monat!

Jetzt Mitglied werden!

Gesellschaft und Politik stehen in der Pflicht

Die Gefahr, die autonome Waffensysteme und deren Steuersysteme darstellen könnten, bleiben nicht unbeachtet. Ende 2020 stellte die Menschenrechtsorganisation Human Rights Watch einen Bericht vor, laut dem der Wunsch nach einem Verbot solcher autonomen Waffen wächst. Rund 30 Staaten hätten sich für internationales Verbot ausgesprochen. Keine Position, ambivalente Aussagen oder sogar Widerstand käme vor allem von Ländern, die in der Entwicklung solcher Waffen bereits sehr weit vorne sind – oder die an den Bauelementen und der Entwicklung mitverdienen würden.

Offiziell spricht sich China etwa für ein Verbot von autonomen Waffen aus – aber nicht gegen deren Erforschung und Entwicklung. Ebenso erklärt Großbritannien offiziell, dass es gegen voll-autonome Waffen ist und selbst keine nutzen will, fördert ihre Entwicklung aber mit Millionenbeträgen. Deutschland positioniert sich klar gegen autonome Waffen und dafür, dass „die menschliche Kontrolle über die Entscheidung einen anderen Menschen zu töten“ bestehen bleibt. Jedoch hat der Bundestag 2020 gleichzeitig gegen einen Antrag der Grünen gestimmt, in dem eine „völkerrechtliche Ächtung autonomer Waffensysteme“ durch Deutschland beschlossen werden sollte. Diese Entscheidung fiel entgegen einer Empfehlung der deutschen Enquete-Kommission für KI und trotz einer Studie des Büros für Technikfolgen-Abschätzung, die warnt, dass diese Waffen kommende Kriege und Konflikte grundlegend verändern und den Wert der Menschenwürde eklatant beschädigen könnten.

„Wenn Deutschland führte, würden viele Staaten folgen“, zeigte sich daher damals der Informatiker und Robotikexperte Noel Sharkey enttäuscht, der sich mit der Organisation Stop Killer Robots für ein Verbot autonomer Waffen einsetzt. Die Gefahr sei laut ihm nicht, dass sich Roboter gezielt gegen die Menschheit wenden und einen Krieg beginnen wie in Terminator. Sie sei aber sehr wohl, dass selbstständig arbeitende Killer-Roboter das menschliche Leben entwerten, ein Mord durch einen Roboter als eine Art „Naturereignis“ ohne Verantwortlichen behandelt wird – und es niemanden mehr gäbe, der einen Mord mit seinem Gewissen vereinbaren muss. Dazu würden sich Situationen durch autonome Kriegsmaschinen derart beschleunigen und verkomplizieren, dass sie nicht mehr von Menschen und Befehlsgebern nachvollziehbar sind.

Einige Forscher, Entwickler und Aktivisten sehen daher die Verantwortung auch bei jenen, die die Technik entwickeln, auf denen die autonomen Waffensysteme aufbauen. Sie müssten sich bewusst machen, wie und auf welche Weise ihre Algorithmen und Künstlichen Intelligenzen in Waffensystemen ge- und missbraucht werden könnten – und sich entsprechend positionieren und selbst gegen autonome Waffen einsetzen. Auch weil statt eines Soldaten womöglich irgendwann ein Informatiker, eine Computerwissenschaftlerin oder ein KI-Unternehmen für mögliche Kriegsverbrechen vor Gericht stehen könnte, weil sie eine Drohne oder Killer-Roboter gebaut hat.

https://www.youtube.com/watch?v=scTe1LUjwbo

Gäbe es niemanden, der die denkende Software für autonome Waffen entwickelt, würden diese nicht selbstständig töten können. Aber so einfach ist es wohl nicht. Denn die Krux ist das Prinzip des Dual-Use. Die Software, die Killer-Roboter ermöglicht, ist eben auch jene, die andere Innovationen beflügelt – sei es die Diagnose von Krankheiten, intelligente Verkehrsleitsysteme, witzige Videofilter in Social-Media-Apps oder eben selbstfahrenden Autos. Daher müssen letztlich wohl die Gesellschaft und die Politik eine klare Position gegen autonome Waffen beziehen, damit Szenen von Robotern auf Schlachtfeldern wie den Terminator-Filmen doch Fiktion bleiben. Noch ist es nicht zu spät.

Dieser Artikel ist Teil des 1E9-Themenspecials „KI, Verantwortung und Wir“. Darin wollen wir herausfinden, wie wir Künstliche Intelligenz so einsetzen, dass die Gesellschaft wirklich davon profitiert. Alle Inhalte des Specials findest du hier.

Teaser-Bild: Public Domain