Eine Künstliche Intelligenz funktioniert anders als ein Dampfkessel. Deswegen reichen weder Normen, noch ethische Prinzipien oder Gesetze, um zu verhindern, dass KI-Systeme nie geahnten Schaden anrichten. Das lehrt das Beispiel Facebook. Was aber hilft? Die Vorstellungskraft von KünstlerInnen.

Ein Essay von Max Haarich

Im Jahr 2006 erschuf Mark Zuckerberg Facebook, um der ganzen Menschheit zu helfen, Freunde zu finden und sich mit Ihnen auszutauschen. Eigentlich ein Paradebeispiel für den gemeinwohlorientierten Einsatz von Technologie, oder? Im Jahr 2017 ermöglichten seine Facebook-Algorithmen dann jedoch den Genozid von Myanmar. Dabei starben bis heute mindestens 24.000 Menschen. Das sind fünfmal mehr Todesopfer als bei der Reaktorkatastrophe von Tschernobyl und achtmal mehr als bei den Anschlägen auf das World-Trade-Center.

Was zur Hölle war da bei der „Freundschaftsmaschine“ Facebook schiefgelaufen? Kurze Antwort: nichts. Facebooks KI-Algorithmus war nicht etwa von irgendeinem Terroristen gehijackt worden. Es lag auch kein technischer Defekt vor, der die Funktionsweise des Algorithmus verändert hätte. Nein, das erschreckende war: Der Algorithmus von Facebook hatte einwandfrei und genau so funktioniert, wie er sollte. Er spielte solche Posts bevorzugt aus, die besonders starke User-Reaktionen hervorriefen. In diesem Fall waren es aber leider Posts, in denen der Militärchef Myanmars die Volksgruppe der Arakanesen gegen die Gruppe der Rohingya aufhetzte – mit erfundenen Anschuldigungen und mit verheerendem Ausgang.

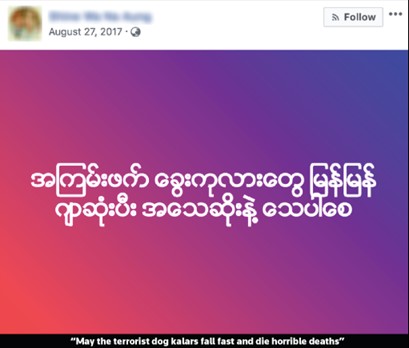

Beispiel für einen gegen die Volksgruppe der Rohingya gerichteten Facebook-Post. „Kalar“ ist in Myanmar eine beleidigende Bezeichnung für Muslime und wurde mittlerweile von Facebook als Hatespeech klassifiziert. Bildquelle: AdNews.

Dieser Vorfall verdeutlicht, wie wichtig es ist, den gemeinwohlorientierten – oder zumindest den nicht-unethischen – Einsatz von KI zu fördern. Es zeigt aber gleichzeitig auch, wie schwer das umzusetzen ist, wenn selbst der legale und ordnungsgemäße Betrieb eines Algorithmus zur Katastrophe führen kann. Welche Ansätze gibt es aktuell zur Sicherstellung ethischer KI? Sie lassen sich grob einteilen in Normen und Regeln. Schauen wir erst deren Vorteile und Grenzen, bevor wir über die HofnärrIn von Mark Zuckerberg sprechen.

Normen, die ethische KI sicherstellen sollen

Zu den Normen zählen zum Beispiel die Standards des Institute of Electrical and Electronics Engineers, kurz IEEE, oder das Prüfsiegel des deutschen TÜV. Diese Instrumente beziehen sich vorrangig auf die technische Entwicklung von Algorithmen. Gerade der TÜV prüft vor allem die technische Robustheit des Algorithmus und dessen Widerstandsfähigkeit gegenüber Hacker-Angriffen. Das ist wichtig, kann aber nicht alleine das ethisch korrekte Verhalten des Algorithmus sicherstellen. Wir haben es nämlich zum einen mit lernenden Systemen zu tun, die oft so konzipiert sind, dass sie ihr Verhalten im Realbetrieb bei Bedarf ändern können.

Ein weiteres Hauptproblem der Normierung liegt darin, dass sich nicht nur der Algorithmus, sondern auch die ethischen Vorstellungen der Zivilgesellschaft verändern können. Moralvorstellungen sind divers und dynamisch, sie variieren von Ort zu Ort und von Zeit zu Zeit. Ende des letzten Jahrhunderts hatten viele BürgerInnen noch große Angst vor heimlich installierten Abhöranlagen in der Wohnung. Heute bezahlen die Leute sogar für Smart-Home-Assistenten, die nachweislich auch dann aufnehmen können, wenn sie es weder sollen noch dürfen. Und während junge Erwachsene in China ihr Dating-Profil mit ihrem Social-Score aufwerten, haben junge Menschen in Berlin gleichzeitig die Ansiedlung eines an staatlicher Überwachung beteiligten Unternehmens mit lautstarken Kampagnen und Demonstrationen verhindert. In einer lebendigen, multikulturellen Welt scheint es keine für alle und immer gültige Ethik zu geben. Damit ist auch KI-Ethik ein kontinuierlicher Aushandlungsprozess mit der Zivilgesellschaft.

Normen haben allgemein die Aufgabe, Vertrauen in ein Produkt zu schaffen und die IngenieurInnen oder WissenschaftlerInnen von der Verantwortung und Haftung zu befreien. Sie vermitteln KonsumentInnen und ProduzentInnen die Gewissheit, dass alles Menschenmögliche getan wurde, um ein gut funktionierendes Produkt zu bauen, sei es eine KI oder ein Dampfkessel. Denn die ursprüngliche Aufgabe des TÜV war das Explodieren von Dampfkesseln zu verhindern. Dafür wurden den IngenieurInnen technische Vorschriften gemacht. Sofern diese eingehalten wurden, konnte eigentlich nicht mehr viel passieren. Und falls doch, konnte man das nun wirklich niemandem vorwerfen.

Der Begriff Künstliche Intelligenz führt manchmal zu Missverständnissen. Bild: Tumblr

Gesetze, die ethische KI sicherstellen sollen

Der Unterschied zwischen KI und Dampfkesseln ist jedoch, dass KI nicht nur auf eine Weise „explodieren“ kann, sondern auf ganz unterschiedliche Weisen, die kaum vorhersehbar sind. Daher werden immer öfter strafrechtlich durchsetzbare Gesetze, also: Hard Law, angestrebt, die die Betreiber von Algorithmen für ethisches Fehlverhalten in die Verantwortung nehmen, egal welche Vorkehrungen getroffen wurden. Allein der entstandene Schaden entscheidet.

Gesetzliche Regulierung ist aber nicht so einfach, wie es klingt. Denn Gesetze müssen absolut explizit sein und es kommt ganz genau darauf an, ob sich ein Gesetz auf KI, Machine Learning oder Deep Learning bezieht und welches genaue Verhalten da verboten oder vorgeschrieben werden soll. Der Politik fehlt zur exakten Formulierung häufig die wissenschaftliche Expertise, so dass sie oft auf Beratung durch Forschung und Industrie angewiesen sind – also genau durch die Leute, die eigentlich reguliert werden sollen. Der Konflikt ist vorprogrammiert und ein schnelles Ergebnis unwahrscheinlich.

Manche Gesetzgeber versuchen diesen definitorischen Treibsand komplett zu umgehen und landen dann bei so populistischen Forderungen wie, dass Social-Media-Plattformen grundsätzlich keine Lügen mehr verbreiten dürften. Paradoxerweise ist jedoch die Lüge immer noch die höchste Form der Meinungsfreiheit und die Postulierung unbezweifelbarer Wahrheiten kennt man eher von totalitären Regimen.

US-Senatorin Alexandria Ocasio-Cortez befragt Facebook-Gründer Mark Zuckerberg zum Umgang mit politischen Werbeanzeigen am 23.10.2019. Bildquelle: Facebook

Der Hype um Erklärungen, Prinzipien und Guidelines

Gesetzgebung ist also eine schwierige Angelegenheit. Selbst wenn irgendwann jemand ausreichend konkrete Gesetze formulieren würde, ließen sich erfahrungsgemäß auch darin immer wieder Graubereiche finden, in denen unethisches, aber nicht illegales Verhalten möglich ist. Um solche Lücken ein wenig zu schließen, wurden die mit Strafverfolgung durchsetzbaren Hard Laws ergänzt um Soft Laws. Dabei handelt es sich etwa um Selbstverpflichtungen in Form von Erklärungen , wie der von Toronto, Montreal oder Wien, oder um Prinzipien und Guidelines , wie denen der Partnership on AI, von Bejing, der OECD oder des US-Verteidigungsministeriums.

Solche Prinzipien erleben spätestens seit 2018 einen wahren Hype. Nahezu alle großen KI-Player wollen sich seitdem an Ethik-Prinzipien halten. Am liebsten natürlich an ihre eigenen. Die Nichtregierungsorganisation AlgorithmWatch listet inzwischen circa 200 verschiedene Prinzipien. Warum so viele verschiedene? Haben die Herausgeber jeweils ganz spezifische Prinzipien in Zusammenarbeit mit ihren spezifischen StakeholderInnen entwickelt? Schön wär‘s. Die Wahrheit ist, die meisten Prinzipien sind inhaltlich identisch: Es geht in allen irgendwie um Robustheit, Fairness, Transparenz, Verantwortung – und die Formulierungen sind meistens nur soweit abgeändert, dass man nicht nachweisen kann, wer von wem abgeschrieben hat.

Diese Kritik soll kein Plädoyer gegen KI-Prinzipien sein. Seine eigenen Prinzipien aufzustellen ist ein positives Zeichen und besser als keine zu formulieren, aber im Endeffekt sind diese Prinzipien alleine nicht die Lösung. Oft sind sie vor allem ein tolles Marketing-Instrument, finden aufgrund ihrer Abstraktheit aber leider viel zu selten den Weg in den konkreten Alltag der verantwortlichen ForscherInnen oder IngenieurInnen, selbst dann nicht, wenn sie den Segen des Papstes haben. Als positive Ausnahmen sind hier die Trustworthy AI Prinzipien der High-Level-Expert-Group der EU-Kommission zu nennen, zu denen es eine konkrete Assesment-List mit Handlungsempfehlungen gibt, sowie die in diesem 1E9-Themenspecial vorgestellten Algo.Rules vom iRighs.Lab und der Bertelsmann-Stiftung, die als konkreter Leitfaden bei Entwicklung und Einsatz von Algorithmen genutzt werden können.

Wie sich ein „Failure of Imagination“ vermeiden lässt

Denken wir nun noch einmal an das Eingangsbeispiel von Mark Zuckerberg zurück. Der Typ könnte einem fast leidtun. Keiner der genannten Ansätze hätte ihm beziehungsweise den Rohingya in Myanmar geholfen. Zuckerberg hielt sich an gültiges Recht, er hielt sich an seine eigenen Selbstverpflichtungen, er baute einen technisch robusten Algorithmus – und trotzdem ist er mitverantwortlich für einen Genozid. Hätte er das überhaupt irgendwie verhindern können? Eigentlich nicht, aber vielleicht doch.

Was in Myanmar passiert ist, war damals jenseits jeglicher Vorstellungskraft. Es war genauso undenkbar wie der Anschlag auf das World Trade Center. Und man kann wohl kaum jemandem vorwerfen, nicht an das Undenkbare gedacht zu haben. Oder doch? Die 9/11-ErmittlerInnen tun genau dies und nennen ein solches Versagen „Failure of Imagination“, ein Versagen der Vorstellungskraft also. Um dem zukünftig vorzubeugen, forderte der 2009 veröffentlichte 9/11-Abschlussbericht, einen Weg zu finden, das Training der Vorstellungskraft zur Routine, ja sogar zum Teil der Bürokratie zu machen. Aber wie?

Hätte ein echtes Red Team Facebook helfen können?

Dieser Forderung folgend gründete das amerikanische Verteidigungsministerium im Jahr die University of Foreign Military and Cultural Studies gegründet. Dort werden OffizierInnen zu Red TeamerInnen ausgebildet.

Das Website-Banner der University of Foreign Military and Cultural Studies. Bildquelle: UFMCS

Red Teams wurden in der Cybersecurity etabliert, um sich innovative Bedrohungsszenarien auszudenken und diese zu simulieren. In diesen Teams ist absolut wildes Spekulieren auf Basis neuster wissenschaftlicher Erkenntnisse gefordert. Entsprechend werden in solchen Funktionen zunehmend KünstlerInnen eingestellt, insbesondere Science-Fiction-AutorInnen wie auch bei der französischen Armee, die dann zum Beispiel sogenannte Threatcasts schreiben, die nur schwer vorstellbare Bedrohungen vorhersagen.

Auch Facebook besitzt seit 2019 ein zehnköpfiges Red Team, jedoch hätte dieses aufgrund seiner Besetzung die Geschehnisse in Myanmar kaum verhindern können. Es besteht nämlich nur aus hauseigenen Sicherheits-ExpertInnen, die ausschließlich Angriffe auf die Infrastruktur von Facebook selbst bekämpfen sollen.

Verstehe, was die Zukunft bringt!

Als Mitglied von 1E9 bekommst Du unabhängigen, zukunftsgerichteten Tech-Journalismus, der für und mit einer Community aus Idealisten, Gründerinnen, Nerds, Wissenschaftlerinnen und Kreativen entsteht. Außerdem erhältst Du vollen Zugang zur 1E9-Community, exklusive Newsletter und kannst bei 1E9-Events dabei sein. Schon ab 2,50 Euro im Monat!

Jetzt Mitglied werden!

Was Facebook damals vielleicht wirklich geholfen hätte, wäre erstens die Erweiterung des Aufgabenspektrums der Red Teams. In Myanmar wurde nicht Facebook angegriffen, sondern die Gesellschaft wurde mithilfe von Facebook angegriffen. Die Abwehr solcher Szenarien war und ist nicht Aufgabe der Einheit. Hätte Facebook wenigstens nach den Geschehnissen von Myanmar derartige Szenarien in die Analyse des Red Teams einbezogen, hätten vielleicht im Januar die Ausschreitungen von Trump-Anhängern am Washingtoner Kapitol verhindert werden können. Zweitens sollten zusätzlich zu den fachlichen Inhouse-ExpertInnen vor allem externe KünstlerInnen in die Red Teams eingebunden werden.

KünstlerInnen trugen schon zur ethischen Debatte um KI bei, bevor es den Begriff KI überhaupt gab. Sie besitzen nicht nur die Handfertigkeit Anwendungsszenarien zu visualisieren und zu materialisieren, sie werden vor allem explizit darin geschult, völlig neue Blickwinkel zu erschaffen, um Szenarien möglichst kritisch betrachten zu können, aber auch, um den problematischen Bespielen der KI-Anwendung innovative und gemeinwohlorientierte Szenarien gegenüberzustellen.

Mit dem Binocular Rivalry Test wurde festgestellt, dass kreative Menschen die Welt anders sehen als unkreative. Bildquelle: The Conversation

-

Anders sehen : KünstlerInnen lernen in ihrer Ausbildung, die Welt anders wahrzunehmen, um neue Lösungen vorzuschlagen. Schon Leonardo da Vinci formulierte das Prinzip „Sapere Vedere” als Schlüssel zu innovativen Ideen: „Zu wissen, wie man etwas sieht, wenn es sonst niemand sieht, und dann etwas dagegen zu tun – das ist der Weg der Zukunft.“ Eine australische Studie aus dem Jahre 2017 belegt, dass dies nicht nur metaphorisch gemeint ist, sondern dass kreative Menschen die Welt wirklich physisch anders wahrnehmen können. In einem Experiment hatten die ForscherInnen mehr und weniger kreativen Menschen eine Brille aufgesetzt, die dem einen Auge ein rotes Bild dem anderen Auge ein grünes Bild zeigte. Bei weniger kreativen Menschen wechselte die Wahrnehmung zwischen rot und grün, während kreativere Menschen beide Bilder zu rot-grünen Mustern kombinierten. Diese erweiterte oder zumindest alternative Wahrnehmung ist die Kernkompetenz zur Vorbeugung eines „Failure of Imagination“. KünstlerInnen können problematische Zusammenhänge frühzeitig erkennen, die für andere noch unsichtbar sind.

-

Kritisch denken : Das frühzeitige Erkennen von Problemen ist wertlos, wenn man den Missstand nicht auch aufdecken darf. KünstlerIn ist historisch die Berufsgruppe, die für die Formulierung übertrieben kritischer Ideen ausgebildet und belohnt wird. Die oft absichtlich überzogen kritische Reflexion durch die Kunst wurde schon im Mittelalter geschätzt, wo KönigInnen eigene HofnärrInnen beschäftigten. HofnärrInnen waren die einzigen Personen, denen die Freiheit gewährt wurde, die KönigInnen immer wieder an ihre Fehlbarkeit zu erinnern, um sie vor Unheil zu bewahren. Diese mittelalterliche Narrenfreiheit war so wertvoll, dass sie auch heute noch in Form der Kunstfreiheit im Artikel 5 Absatz 3 des deutschen Grundgesetzes geschützt wird.

-

Gemeinwohlorientiert denken: Den „Failure of Imagination“ sollte man eigentlich gleich in zweierlei Hinsicht definieren. Zum einen fehlt vielen die Vorstellungskraft, negative Szenarien vorherzusehen, die verhindert werden müssen. Zum anderen fehlt – vielleicht sogar noch mehr Menschen – die Fähigkeit, sich positive Szenarien auszumalen, die angestrebt werden sollten, was man bei der Diskussion unserer Wirtschaftsordnung feststellen kann. Viele Jammern oft über den bösen Kapitalismus. Wie der britische Kulturwissenschaftler Mark Fisher feststellte, fällt es den meisten aber leichter, sich das Ende der Welt vorzustellen als das Ende des Kapitalismus. Gemäß dem brasilianischen Philosophen Roberto Unger führt uns diese Visionsarmut in eine „Dictatorship of No Alternatives“, eine Diktatur der Alternativlosigkeit, in der selbst die rebellischsten KapitalismusgegnerInnen aus Fantasielosigkeit ein Social-Start-up gründen. Es waren immer wieder KünstlerInnen, die tatsächlich einen Schritt weiter gingen und alternative, gemeinwohlorientierte oder sogar utopische Gesellschaftsformen vordachten und umsetzten, zum Beispiel im dänischen Christiania, im schwedischen Ladonia oder im litauischen Užupis.

Es gibt genug KünstlerInnen, die gerne bei KI-Fragen unterstützen. Man muss dafür nicht gleich ein professionell ausgebildetes Red Team voller KünstlerInnen aufbauen. Aber wo immer man künstlerische Sichtweisen in die Entwicklung und Weiterentwicklung von KI einbindet – und sei es nur eine Person und nur für kurze Zeit –, kann dies wertvolle Impulse liefern, um das bisherige Handeln neu zu betrachten und KI noch ein Stückchen ethischer zu machen.

Wenn überhaupt, dann hätte eine HofnärrIn mit grenzenloser Vorstellungskraft Mark Zuckerberg davor warnen können, was aus seiner hübschen Idee von Facebook einmal werden könnte.

Dieser Artikel ist Teil des 1E9-Themenspecials „KI, Verantwortung und Wir“. Darin wollen wir herausfinden, wie wir Künstliche Intelligenz so einsetzen, dass die Gesellschaft wirklich davon profitiert. Alle Inhalte des Specials findest du hier.

und genau das, was sie vielleicht kritisieren tun… Viele solcher Beispiele gibt es in der Vergangenheit.

und genau das, was sie vielleicht kritisieren tun… Viele solcher Beispiele gibt es in der Vergangenheit. Das bedarf dann aber eines Problems, für das man eine Lösung hat und DAO + x ist dann ein Tool um die Lösung zu realisieren.

Das bedarf dann aber eines Problems, für das man eine Lösung hat und DAO + x ist dann ein Tool um die Lösung zu realisieren.