KünstlerInnen und Kulturschaffede haben die ethischen Probleme der Künstlichen Intelligenz (KI) schon diskutiert, bevor es KI überhaupt gab. Mit der Figur des „Golem“ im jüdischen Talmud, dem Monster aus Mary Shellys „Frankenstein“ oder dem von Karel Čapek erfundenen „Roboter“ wurden Blaupausen für die ethische Debatte geschaffen, die auch heute noch wertvoll sind. Natürlich waren diese noch nicht durch aktuelle KI inspiriert, aber sie dienen als zeitlose Warnungen vor unkontrollierbaren Technologien und wissenschaftlicher Überheblichkeit. Die besondere Qualität solcher Figuren liegt darin, dass sie eine an sich unsichtbare und immaterielle Technologie visualisieren und materialisieren und dadurch den gesellschaftlichen Diskurs über KI erleichtern oder sogar erst ermöglichen.

Video „Kratt Needs Work“

Diese künstlerische Darstellungs-Kompetenz wird teilweise gezielt eingesetzt, um ethische KI-Themen für die Zivilgesellschaft begreifbar zu machen. Die Regierung Estlands nutzt beispielsweise den lokalen Mythos des „Kratt“ für die öffentliche Diskussion ihrer KI-Gesetze. Der Kratt ist ein Fabelwesen aus Heu und Stöcken, das seelenlos alle Aufgaben seiner HerrInnen erledigt, aber sich auch gegen sie wenden kann, wenn es nicht ordentlich beschäftigt wird.

Ein anderes Beispiel ist das von KünstlerInnen organisierte italienische Projekt IAQOS, dass die Metapher der KI als Baby nutzt, um eine KI-gestützte Smart-City-Infrastruktur bottom-up und open source einzuführen. Ein ganzes Stadtviertel wird aktiv involviert, um das KI-Baby nach den ethischen Vorstellungen aller Bürger „großzuziehen“.

Um wiederum vor staatlicher Überwachung durch künstlich intelligente Infrastrukturen zu warnen, entwickeln Masterschüler der niederländischen Baltan Laboratories in Kooperation mit dem Ars Electronica Reasearch Institute Knowledge for Humanity einen als Pferd verkörperten Überwachungsalgorithmus Namens „Smart Hans“.

Durch Fußstampfen zeigt „Smart Hans“ die Zahl an, an die die Besucherin gerade denkt. Bild: Deborah Mora

Nach dem realen Vorbild des „gedankenlesenden“ Pferds „Kluger Hans“, entwickeln sie einen Algorithmus, der allein durch Analyse der Körperhaltung erraten kann, an welche Zahl man denkt. Die interaktive Installation demonstriert intuitiv die erschreckende Fähigkeit von KI nur mit Hilfe einer Webcam die Gedanken von Menschen auszuspionieren. Gleichzeitig ermöglicht sie den BesucherInnen die Funktionsweise des Algorithmus auszutesten, um diesen z.B. durch bewusste Veränderung der Körperhaltung in die Irre zu führen.

Einen direkteren Weg zur Inspiration der politischen Debatte geht die Münchner Botschaft der Künstlerrepublik Užupis. Sie adaptiert gezielt die etablierten Formate der KI-ethischen Regulierung, um die künstlerischen Sichtweisen ihrer Republik in die Debatte einzubringen. Sie hat z.B. die ersten von KünstlerInnen formulierten Prinzipien für vertrauenswürdige KI veröffentlicht, die als bisher einzige eine persönliche Selbstverpflichtung der individuellen KI-DesignerInnen vorsehen, und zwar ohne jegliche Prüfung aber für die gesamte „Lebenszeit“ des Algorithmus.

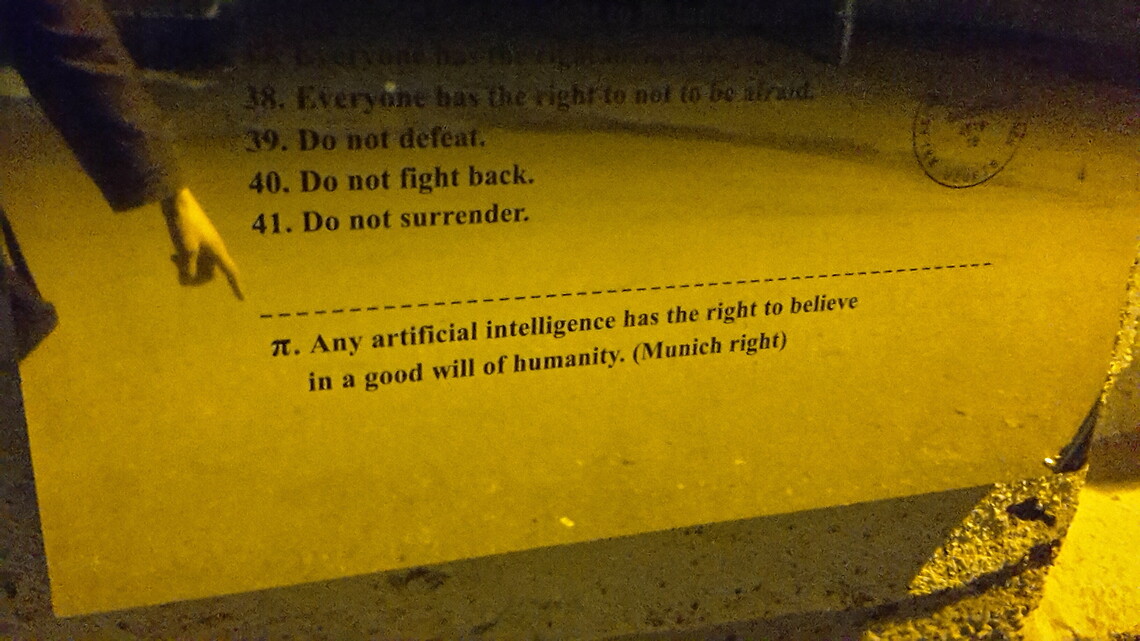

KI-Artikel Nummer π in der Verfassung von Užupis. Bild: Max Haarich

Mit demselben Gewicht auf der Eigenverantwortung des Menschen hat die Münchner Botschaft auch einen KI-Artikel für die Verfassung von Užupis formuliert: „π: Any artificial intelligence has the right to believe in a good will of humanity.“ Zur Zeit der Veröffentlichung 2018 war dies eine komplette Umkehr der ethischen KI-Debatte, in der die meisten KI-Unternehmen noch so taten, als müssten wir Menschen auf das Wohlwollen der genauso mächtigen wie unberechenbaren Technologie hoffen. Knappe drei Jahre später scheint die Relevanz der Eigenverantwortung in der KI-Debatte angekommen zu sein und im Juni 2021 wird der KI-Artikel von Užupis als Impuls zum Update der Österreichischen Verfassung im Rahmen der GLOBART Academy im Wiener Parlament vorgetragen.

Dies sind nur einige Beispiele dafür, wie die KI-Revolution mit Hilfe von Kunst- und Kultur zum Wohle aller gestaltet werden kann. Sie entsprechen der in den letzten Jahren lauter werdenden Forderungen nach stärkerer Beteiligung der Künste und Geisteswissenschaften bei der Gestaltung der Technologie und tragen hoffentlich langfristig zur Versöhnung der zwei Kulturen bei.

Nach

Nach