Was ist echt? Was Fake? Und was von einer Künstlichen Intelligenz generiert? Gerade in den sozialen Medien ist es manchmal schwierig, authentische Bilder, Videos, Texte von gefälschten und KI- Inhalten zu unterscheiden. Doch die Lage könnte sich verbessern. Denn technische Lösungen, um echte Inhalte erkennbar zu machen, werden bereits erfolgreich getestet. Eine wichtige Rolle dabei spielen Kryptografie, dezentrale Datenbanken und Blockchains.

Von Wolfgang Kerler

Seit dem Terrorangriff der Hamas auf Israel werden im Netz sowohl gezielt, als auch unbewusst Falschinformationen verbreitet: gefakte Screenshots, Videos, die aus ganz anderen Konflikten stammen, sogar KI-generierte Bilder, die angebliche Raketenangriffe darstellen sollen.

Aber solche Inhalte betreffen längst nicht nur den Krieg im Nahen Osten. Egal ob zu Ukraine, Corona, Migration, politische Wahlen oder Geldanlagen: Die Flut an Fakes und Desinformation bringt selbst professionelle Faktenchecker an ihre Grenzen. Wie sollen da Durchschnittsuser den Überblick behalten? Im Frühjahr 2023 gaben bei einer EU-weiten Umfrage im Auftrag der Bertelsmann Stiftung 54 Prozent der Befragten an, in den vergangenen Monaten häufig oder sogar sehr häufig verunsichert gewesen zu sein, ob Informationen im Internet wahr sind oder nicht.

Neu ist das Problem nicht. Desinformation ist älter als das Internet – und dort reichen oft schon „Cheap Fakes“, um Unwahrheiten zu verbreiten: Zitate oder Aufnahmen, die aus dem Kontext gerissen werden; überzeugend klingende, aber inhaltlich falsche Texte; oder mit einfachen Tools nachgebaute Webseiten, die aussehen wie die Seiten bekannter Medien, zum Beispiel von Tagesschau oder Bild. KI braucht es dafür nicht. Dass Generative Künstliche Intelligenz – also Programme wie ChatGPT, Stable Diffusion oder Midjourney – das Problem aber noch verschärfen könnte, beweist ein harmloser Fall.

Über alle sozialen Netzwerke verbreitete sich im Frühjahr ein „Foto“, das Papst Franziskus in einer stylischen Daunenjacke zeigte. Manchen fiel auf, dass damit etwas nicht stimmte – die jugendlichen Hände passten nicht zum Alter des Papstes, ein Stück der Brille fehlte. Viele bemerkten das allerdings nicht und feierten ihn als Fashion-Influencer. Denn die Information, dass das Bild mit dem KI-Bildgenerator Midjourney erschaffen wurde, ging erst mit Verzögerung „viral“ – obwohl die Darstellung ursprünglich sogar mit dem Hinweis darauf bei Reddit veröffentlicht worden war.

Ein „digitaler Fingerabdruck“, der sich nicht fälschen lässt

War es das also endgültig mit dem Vertrauen in digitale Inhalte, gerade in Social Media? Nicht unbedingt. Denn gerade arbeiten verschiedene Organisationen – von Forschungseinrichtungen über Start-ups und Konzerne bis zu Kameraherstellern – an technischen Lösungen, um eine gängige Praxis aus der Kunstwelt in die digitale Medienöffentlichkeit zu übertragen.

Am Kunstmarkt ist es selbstverständlich, sich vor dem Kauf eines Werkes über seine Provenienz, also seine Herkunftsgeschichte zu informieren. Wem gehörte die Arbeit früher? Kann die Echtheit garantiert werden? Oder handelt es sich gar um ein illegal erworbenes Stück? Das zu klären, kostet Zeit – die man beim Handel mit Kunstwerken meistens hat.

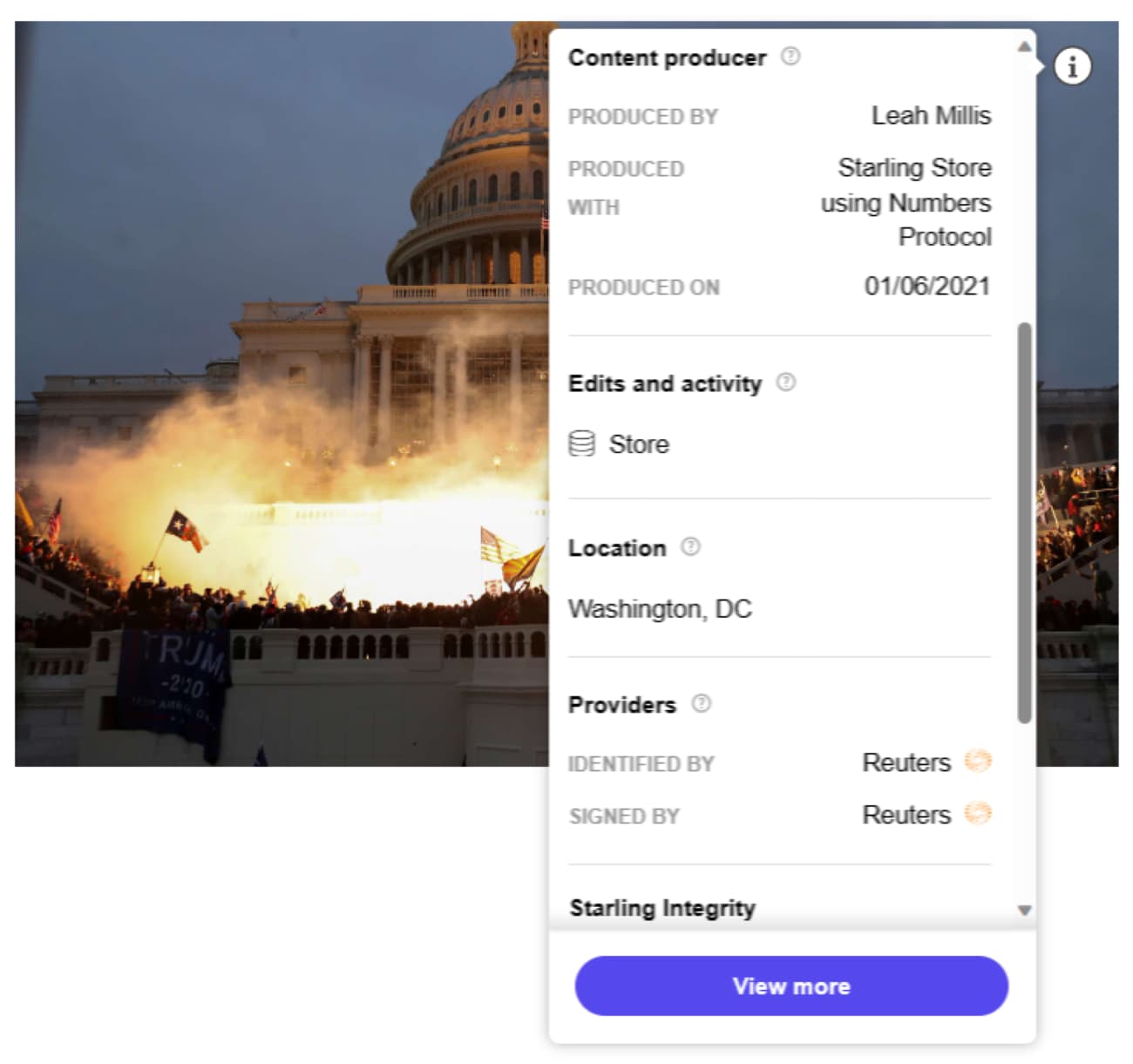

Diese Zeit hat allerdings niemand, der nur schnell checken will, ob ein Bild bei X oder Instagram authentisch ist. Die Tools, die entwickelt werden, sollen daher „Provenienzforschung“ in Sekunden ermöglichen. Dafür sollen Bilder, Videos oder Artikel in sozialen Netzwerken oder auf Webseiten ein Icon bekommen – zum Beispiel ein kleines „i“ oder die Buchstaben „cr“ für Content Credentials. Per Klick darauf sollen User dann Hintergrundinformationen zur Herkunft der Inhalte bekommen.

Bei einem Foto würde man also erfahren, wann, wo, mit welchen Kameraeinstellungen und von wem es aufgenommen wurde, welche Nachbearbeitungen stattgefunden haben und wer es veröffentlicht hat. Ein Bild von einer Künstlichen Intelligenz wiederum wäre eindeutig als solches identifizierbar.

Um das möglich zu machen, braucht es im Hintergrund auf jeden Fall Kryptografie und, je nach Ansatz, auch Blockchains und dezentrale Datenbanken. Denn damit bekommen Inhalte ein „digitales Wasserzeichen“ bzw. einen „digitalen Fingerabdruck“. Dieser soll die Authentizität von Bildern, Videos oder Texten zweifelsfrei bestätigen und die Herkunft transparent machen.

Weltweit führend bei der Entwicklung derartiger Werkzeuge, der dazugehörigen Workflows sowie ihrer Umsetzung dürfte das US-amerikanische Starling Lab sein – eine von der Stanford University sowie der USC Shoah Foundation gegründete Forschungseinrichtung. Das Lab konnte in Pilotprojekten mit der Nachrichtenagentur Reuters, dem Magazin Rolling Stone und anderen Partnern beweisen, dass die digitale Authentifizierung von Content nicht nur theoretisch funktioniert. „Wir haben dafür Themen gewählt, bei denen es wahrscheinlich war, dass Tatsachen infrage gestellt, Desinformationen gezielt gestreut oder Belege verschwinden könnten“, sagt Adam Rose, der Chief Operating Officer des Starling Labs.

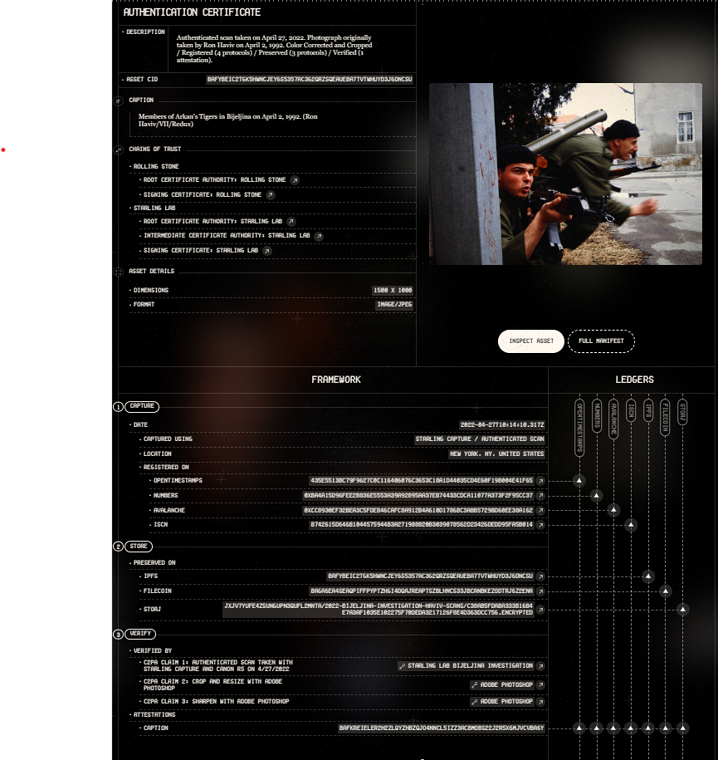

Unter dem Titel 78 Days schufen das Starling Lab und Reuters ein digitales Fotoarchiv, das die Zeit zwischen der US-Präsidentschaftswahl im November 2020 und der Amtseinführung von Joe Biden am 6. Januar dokumentierte – inklusive des Sturms aus Kapitol durch wütende Anhänger von Donald Trump. Im Projekt The DJ and the War Crimes mit dem Rolling Stone beschäftigte sich das Lab mit ungesühnten Kriegsverbrechen während des Bosnienkriegs im Jahr 1992.

Vor wenigen Wochen wurden außerdem die Ergebnisse einer weiteren Kooperation mit Reuters sowie dem Kamerahersteller Canon vorgestellt, für die eine Fotografin die Folgen des russischen Kriegs gegen die Ukraine festhielt. Ziel des Projekts war es, die gesamte Provenienz von Fotos – vom Moment der Aufnahme bis zur Veröffentlichung – zu dokumentieren. Daran lässt sich gut erkennen, wie umfangreich die Möglichkeiten der Content Authentifizierung inzwischen sind.

Transparenz von der Kamera bis in den Social-Media-Feed

Für die Kooperation reiste die Fotojournalistin Violeta Santos Moura durch die Ukraine, um mit einem Kamera-Prototyp von Canon Fotos der Kriegszerstörungen zu machen. Die Fotos wurden dabei von der Kamera direkt nach der Aufnahme mit Uhrzeit, Standortdaten, Kameraeinstellungen sowie einem einzigartigen Hashwert versehen, der durch ein kryptografisches Verfahren berechnet wird. Dieser Zahlenwert passt nur zu genau diesem Bild. Er verändert sich, sollte auch nur ein Pixel manipuliert werden. Bleibt das Bild unangetastet, wird bei späteren Überprüfungen dagegen immer wieder derselbe Hashwert herauskommen. Außerdem wurden die Aufnahmen noch in der Kamera kryptografisch signiert.

„Wir sind der Ansicht, dass dieses Hashing und Signing so nah wie möglich am Ursprung der Daten passieren muss“, erklärt dazu Adam Rose. „Lässt sich eine Signatur mit Software auf dem Smartphone erzeugen, ist das schon ganz gut. Noch besser ist, wenn dies über die Firmware des Gerätes erfolgt. Und am besten ist es, wenn diese Funktionen direkt in die Hardware implementiert sind.“

Die signierten Bilder wurden dann ans Daten-Management-System von Reuters gesendet. Außerdem wurde ihr jeweiliger digitaler Fingerabdruck auf einer oder mehreren öffentlichen Blockchains, also dezentralen Datenbanken, registriert. Ganz konkret setzte das Projekt auf OpenTimestamps auf der Bitcoin-Blockchain, das Numbers-Protokoll sowie auf ISCN auf der Likecoin-Blockchain. Zusätzlich wurden die Bilder selbst, also nicht nur die Metadaten im digitalen Fingerabdruck, auf dezentralen Archiven – bei IPFS, Filecoin und Storj – gespeichert. Das heißt: Die Originaldatei lag nicht mehr nur auf dem zentralen Reuters-Server, sondern auf Archiven, die sich über einen Verbund aus Rechnern und Servern verteilen. Das schützt vor Manipulationen oder der Löschung von Daten.

Die Redakteure bei Reuters bearbeiteten im nächsten Schritt die Bilder, wobei jede Anpassung des Kontrasts und jeder Zuschnitt, ebenfalls auf Blockchains und dezentralen Datenbanken festgehalten wurde. Das Hasing und Signing braucht es für jede Version des Bildes. Die fertigen Bilder wurden schließlich mit allen Informationen über Entstehungszeit, Ort, Blockchain-Registrierungen und Nachbearbeitungen veröffentlicht. Diese Metadaten wurden dabei direkt in die JPEG-Datei, also das Bild selbst, eingebettet, damit sie überall und schnell verfügbar sind.

Noch mehr Transparenz schaffte darüber das Verify-Tool der Content Authenticity Initiative, auf die wir noch zurückkommen werden. Damit können die verschiedenen Versionen eines Bildes miteinander verglichen werden. mit der ursprünglichen Version vergleichen. Das alles funktioniert nur, wenn Hashwerte identisch sind und das Bild nicht manipuliert wurde.

Für das Ukraine-Projekt betrieben das Starling Lab und seine Partner erheblichen Aufwand. Simplere Lösungen verzichten auf den Einsatz von Blockchains, um den digitalen Fingerabdruck von Bildern zu sichern, oder auf dezentrale Datenbanken zum Speichern der Originaldateien. Sie nutzen lediglich die kryptografischen Verfahren, um Content mit eindeutigen Hashwerten zu versehen. Adam Rose erklärt, warum sich das Startling Lab für den Mehraufwand entschieden hat: „Erst durch den Einsatz von Kryptografie, dezentralen Speichermethoden und Blockchains können wir sicherstellen, dass Daten langfristig gesichert sind und nicht manipuliert werden können.“

Open-Source-Industriestandards – und regulatorischer Druck von der EU

Die vom Photoshop-Macher Adobe, der New York Times und Twitter gegründete Content Authenticity Initiative, zu der inzwischen auch Medienhäuser wie Axel Springer, dpa oder Stern sowie die Kamerahersteller Canon, Leica und Nicon gehören, gehört zu den wichtigsten Organisationen im Bereich der digitalen Content-Authentifizierung. Daneben gibt es auch noch Project Origin, gestartet von Microsoft, der BBC und anderen, mit ähnlichen Zielen. Gemeinsam bilden sie die Coalition for Content Provenance and Authenticity, kurz C2PA.

Die C2PA hat die Aufgabe, einen Open-Source-Industriestandard zu entwickeln, und hat bereits technische Spezifikationen unter Creative Commons Lizenz veröffentlicht. Dazu gehört der Standard, um den digitalen Fingerabdruck inklusive aller Metadaten – auch als „Content Credentials“ bezeichnet – bei Bildern, Videos und Audios direkt in die jeweilige Datei einzubetten. Auch das Starling Lab greift auf diesen Standard zurück.

Werde Mitglied von 1E9!

Hier geht’s um Technologien und Ideen, mit denen wir die Welt besser machen können. Du unterstützt konstruktiven Journalismus statt Streit und Probleme! Als 1E9-Mitglied bekommst du frühen Zugriff auf unsere Inhalte, exklusive Newsletter, Workshops und Events. Vor allem aber wirst du Teil einer Community von Zukunftsoptimisten, die viel voneinander lernen.

Jetzt Mitglied werden!

Trotz all dieser Entwicklungen sei etwa das Content-Authenticity-Framework des Starling Labs nicht innerhalb von einem Tag in die Systeme und Workflows von Medienhäusern zu implementierten, meint Adam Rose. Es könne durchaus einige Wochen dauern. „Aber wenn das System einmal steht und Teil der Arbeitsroutine wird, fühlt es sich ganz natürlich an.“ So sieht das auch das Berliner Start-up Valid, das sich mit einer ganz ähnlichen Lösungen auf die Authentifizierung von Nachrichten-Artikeln spezialisiert hat. Es arbeitet bereits mit der Berliner Zeitung zusammen und will noch in diesem Jahr ein Pilotprojekt starten.

Nodle, ein Anbieter von dezentraler Infrastruktur und Mitglied der CAI, arbeitet mit ContentSign ebenfalls an einer konkreten Lösung für Bilder und Videos. In den Niederlanden entsteht mit Liccium ein Blockchain-Tool, um die Echtheit sowie die Urheberrechte an digitalen Inhalten zu verifizieren. Und damit ist die Liste bereits nutzbarer Software noch nicht zu Ende. Aber warum sollten, Verlage, Nachrichtenagenturen, Forschungseinrichtungen sowie Suchmaschinen-Anbieter oder Social-Media-Plattformen ein Interesse an solchen Tools haben?

„Die Verlage sehen den Bedarf eigentlich seit dem Vormarsch von generativer KI“, sagt dazu Hans Brorsen von Valid. Und auch bei sozialen Netzwerken sieht er gute Chancen. „Die meisten Leute, die diese Plattformen nutzen, wollen echte Nachrichten lesen – und viele sind jetzt schon besorgt, ob sie den Inhalten dort vertrauen können. Allein deswegen sollten die Anbieter schon aus kaufmännischer Sicht motiviert sein, ihren Usern Möglichkeiten zu geben, die Authentizität von Quellen überprüfen zu können.“ Es gebe aber auch noch den Digital Services Acts der Europäischen Union. Denn der schreibt Plattformen vor, das Problem der Desinformation in den Griff zu kriegen. Sonst drohen ihnen Bußgelder.

Auch Adam Rose vom Starling Lab bekommt bisher nur positives Feedback. Doch betont er, dass die Authentifizierung von Content mit umfangreichen Metadaten, wie sie in den Pilotprojekten des Labs umgesetzt wurde, nicht von Regierungen vorgeschrieben werden sollte. „Werden zum Beispiel Demonstrationen für Frauenrechte im Iran festgehalten, könnten solche Informationen in den Händen der Regierung die Sicherheit von Menschen gefährden“, so Rose.

Dass technische Lösungen alleine nicht reichen werden, um das Problem der Desinformation in den sozialen Medien in den Griff zu kriegen – darin sind sich übrigens so gut wie alle, die an diesen Tools arbeiten, einig. Zusätzlich wird es Bildung, Medienkompetenz, Factchecking brauchen. Und manche User werden wohl immer nur das glauben, was sie glauben wollen.

Hat dir der Artikel gefallen? Dann freuen wir uns über deine Unterstützung! Werde Mitglied bei 1E9 oder folge uns bei Twitter, Facebook, Instagram oder LinkedIn und verbreite unsere Inhalte weiter. Danke!

Sprich mit Job, dem Bot!

War der Artikel hilfreich für dich? Hast du noch Fragen oder Anmerkungen? Ich freue mich, wenn du mir Feedback gibst!