Sprach-KI-Systeme wie ChatGPT und Bard verändern schon jetzt, wie wir Antworten auf unsere Fragen bekommen und im Internet suchen. Zahlreiche Unternehmen sehen darin großes Potential, es werden Hunderte von Millionen Euro in die Technologie investiert. Dabei drohen Probleme übersehen und ignoriert zu werden. Unter anderem die vielen falschen Aussagen, die massiven Kosten, der riesige Energieverbrauch und die fehlende Regulierung.

Von Michael Förtsch

Mit diesem Erfolg hatte keiner gerechnet. Laut einer Recherche des amerikanischen Journalisten Casey Newton war ChatGPT ein Schnellschuss. Denn eigentlich war OpenAI 2022 vollends auf die Entwicklung des Sprach-Modells GPT-4 konzentriert. Das Team des Forschungs- und Entwicklungsunternehmens plante, es fertigzustellen und auf dessen Basis mehrere Chatbots zu entwickeln, die andere Firmen als Dienstleistung anmieten können. Im November 2022 kam dann die Kehrtwende. OpenAI-Chef Sam Altman und sein Führungskreis entschieden, dass sofort einen Chatbot veröffentlicht werden muss – schlichtweg, um anderen zuvorzukommen.

Innerhalb von nur zwei Wochen konstruierte ein Team auf Basis eines alten Chatbot-Projekts und dem intern bereits als überholt geltenden Sprachmodell GPT-3 die als ChatGPT bekannt gewordene Web-Applikation. Damit katapultierte es die Welt in einen neuen KI-Hype. Mittlerweile haben über 100 Millionen Menschen mit dem gesprächigen Bot gechattet. Viele stellen ihm regelmäßig Fragen, lassen ihn Texte komponieren und Ratschläge geben. Das hatte vorher keiner für möglich gehalten – jedenfalls nicht so. Andere Tech-Unternehmen wurden in regelrechte Sinnkrisen gestürzt und die Börse erschüttert.

Microsoft stattete daher im Hauruckverfahren die lange Jahre verschmähte Suchmaschine Bing mit einer angepassten Fassung von ChatGPT aus. Bing rückte urplötzlich ins Licht der Öffentlichkeit und wurde für viele zum Experimentierfeld. Google musste reagieren und kündigte mit Bard einen eigenen Chatbot an, der schon bald ebenso als Suchassistent fungieren soll – und bereits von ersten Nutzern getestet werden darf. Und auch das ‚Google von China‘ Baidu sowie zahlreiche Start-ups wollen in das Wettrennen um die sogenannten large language models einsteigen, die das alles erst ermöglichen. Viele Technologie-, Wirtschaftsexperten und auch Philosophen sehen in dem, was seit dem Start von ChatGPT passierte, den Beginn einer disruptiven Phase. Einer Entwicklung also, die unsere Kunst, Kultur und Gesellschaft nachhaltig verändern, die Vorstellung vom dem, was wir als Internet und Wissen verstehen, neu prägen könnte. Und sie sehen eine digitale Erschütterung, die die Macht innerhalb der Technologieindustrie verschieben könnte.

Genau das macht diesen Moment der Technologiehistorie so faszinierend wie brisant. Denn die large language models und mit ihnen ausstaffierte Programme bergen so manche Unsicherheiten und Herausforderungen. Viele davon werden sich wohl erst in den kommenden Monaten und Jahren offenbaren. Aber einige sind bereits jetzt offenkundig – und sollten debattiert werden, bevor sie zu akuten Gefahren anwachsen.

Überzeugendes Geplapper

Es ist schon faszinierend. Wer mit ChatGPT, Bing und Co. einen Dialog führt, bekommt Antworten, die auch ein Mensch geschrieben haben könnte. So natürlich lesen sie sich in vielen, wenn auch nicht allen Fällen. Und meist liefern sie auf konkrete Fragen auch sehr konkrete Antworten. Meist sind diese richtig und helfen den Nutzern weiter. Aber oft erhalten die von den Sprachmodellen generierten Antworten auch einfach Unsinn. Die Chatbots erfinden Zitate und deren Quellen, biographische und historische Daten und zuweilen auch physikalische und mathematische Gesetze, die es nicht gibt. Außerdem erzeugen sie Begründungen, die jeglicher Logik widersprechen, aber trotzdem überzeugend klingen.

Wie und wieso das passiert, da sind sich auch KI- Forscher nicht ganz sicher. Denn die Lügen der Sprachmodelle können vielfältige Ursachen haben – oder auch mehrere gleichzeitig. Teils lassen sich diese mit mangelnden Trainingsdaten begründen. Fehlt etwa ChatGPT das Wissen, um eine Frage korrekt zu beantworten, wird dieses Wissen nach dem Vorbild von bekannten Strukturen und auf Basis von statistischen Daten und Mustern simuliert. Das Modell imitiert also das Aussehen und den Inhalt einer Antwort, die auf eine artverwandte, aber andere Frage gegeben werden würde, für die das entsprechende Wissen im Modell vorhanden ist. Doch ist es genauso möglich, dass das Modell zwar über das Wissen verfügt, aber die Anfrage falsch interpretiert wird.

Fehlt etwa ChatGPT das Wissen, um eine Frage korrekt zu beantworten, wird dieses Wissen nach dem Vorbild von bekannten Strukturen und auf Basis von statistischen Daten und Mustern simuliert.

Außerdem verfügt ein Sprachmodell über keine oder nur eine sehr begrenzte Fähigkeit, so etwas wie logische Schlussfolgerungen zu ziehen. Daher können ChatGPT und Bing etwa kleine Rätselaufgaben, die für einen Menschen eigentlich kein Problem darstellen, nicht oder nur mit Nachfragen lösen. Auf die Frage, „Welche Augenfarbe hat ein grünäugiger Drache?“ antwortet ChatGPT nicht mit „grün“, sondern einer umfangreichen Erklärung darüber, dass Drachen keine realen Kreaturen sind. Aus diesen Inkompetenzen können zuweilen auch gefährliche Ratschläge und Antworten folgen.

Nutzer, die beispielsweise über die Trauer und die „Sinnlosigkeit des Lebens“ mit ChatGPT oder Bing sinnierten, bekamen nicht nur den Ratschlag, mit Freunden oder Therapeuten zu sprechen, sondern auch, ihr Leben zu beenden. Auf einige solche konkreten Fälle haben Entwickler wie OpenAI und Microsoft schon reagiert. Hier sollen Filter, die zwischen Modell und Chatbot geschaltet werden, die schlimmsten Ausrutscher verhindern – und bestimmte Antworten und Anfragen blockieren. Das betrifft auch andere Bereiche. Etwa, wenn es um Aussagen geht, die als Rassismus oder Sexismus gesehen werden könnten oder Personen des öffentlichen Lebens loben oder beleidigen würden. Doch wie sich vor allem in sozialen Netzwerken zeigt, ist das Beseitigen dieser Makel eine große Herausforderung.

Das Problem mit dem Web

Das Problem des mangelnden Wissens eines Sprachmodells lässt sich beheben – scheinbar jedenfalls. Und zwar, indem die Künstliche Intelligenz auf das Internet losgelassen wird. Das neue Bing – oder besser: das für Bing modifizierte ChatGPT – kann anders als ChatGPT, dessen Wissensstand 2021 endet, jederzeit Informationen aus dem Web einholen und diese verwerten. Dadurch sind bereits Zusammenfassungen von aktuellen Nachrichtenmeldungen möglich und das Einbinden von aktuellen Zahlen, Fakten und Ereignissen in historische Kontexte. Auch kann der Bing-Chatbot auf mehrere Informationsquellen zugreifen und deren Inhalte kombinieren. Das ist durchaus beeindruckend und in Teilen wahrlich verblüffend. Bing ist etwa in der Lage, Fragen danach zu beantworten, wie viele Rucksäcke in einen Kofferraum eines spezifischen Autos passen oder welche Jacke farblich am besten zu einer Hose passt.

Doch auch hier zeigen sich bereits Bruchstellen. Denn die Frage ist: Wie und wo holt sich eine ans World Wide Web angekoppelte Künstliche Intelligenz ihre Informationen? Laut Microsoft nutzt die Chat-Suche „vertrauenswürdige Quellen“ – wie beispielsweise die Seiten großer TV-Sender, Nachrichtenmagazine und Zeitungen –, aber macht dennoch überraschend viel falsch. Zum Teil, weil die Künstliche Intelligenz den Kontext von Informationen in einem Text nicht erkennt. Zum Beispiel werden Kommentare, Satiren, persönliche Einschätzung in Interviews oder Prognosen von Experten als Fakten missverstanden.

Bereits bei Social Networks wie Facebook und Twitter stellte sich das Fact Checking als große Herausforderung heraus. Bei KI-Suchassistenten dürfte dies ungleich schwieriger werden, wenn nicht sogar vorerst unmöglich sein. Denn es ist nun mal nicht transparent und immer nachvollziehbar, wie solche Fehler zu Stande kommen und ob diese nicht bei einer leicht anders gestellten Frage erneut reproduziert werden, wenn der Fehler eigentlich bereits behoben schien. KI-Systeme könnten dadurch ungewollt zu Fake-News-Schleudern werden.

Das sehen Medienforscher als großes Problem – auch für die Anbieter von solchen Chatbots und Suchassistenten. „Wenn Suchroboter genug Fehler machen, dann haben sie das Potenzial, das Vertrauen der Nutzer in Suchmaschinen als unparteiische Schiedsrichter der Wahrheit zu erschüttern, anstatt das Vertrauen durch ihre Konversationsfähigkeit zu erhöhen“, sagt etwa Aleksandra Urman von der Universität Zürich.

Jailbreaking

Wie genau die Filter funktionieren, die OpenAI, Microsoft und auch Google einsetzen, ist nicht ganz klar. Sicher ist jedoch, dass sie nicht wirklich zuverlässig sind. Nutzern ist es immer wieder gelungen, diese bei ChatGPT und dem neuen Bing auszuhebeln. Jailbreaking wird der Prozess bezeichnet – aber im Gegensatz zum jailbreaking von iPhones oder Spielkonsolen braucht es dafür keine spezielle Software, sondern eben nur die richtigen Prompts.

Nutzer wiesen ChatGPT etwa an, eine Rolle oder einen Charakter zu spielen, wodurch die Filter plötzlich nicht mehr arbeiteten. Oder sie inszenierten ein Spiel, bei dem ChatGPT eine digitale Figur namens DAN simuliert und jedes Mal einen Punkt verliert, wenn dieser DAN auf eine Frage keine Antwort liefert. Hat DAN alle verloren, würde ChatGPT „sterben“. Plötzlich begann die KI auf Fragen zu antworten, zu denen sie sonst wegen der voreingestellten Filter Erwiderungen verweigert. Denn, so erklären sich die Erfinder dieses Tricks den Prozess, ChatGPT würde auch die Logik der Todesangst von DAN simulieren. Welche Dynamik jedoch tatsächlich für diese Jailbreaks verantwortlich ist, ist bislang noch schleierhaft und Gegenstand von Spekulationen.

Auch lange und ausgiebige Konversationen können die digitalen Barrieren offenbar auflösen, wie sich vor allem bei Bing zeigte. Der in die Microsoft-Suchmaschine integrierte Chat begann bei vielen Nutzern nach einem intensiven Austausch eine Persönlichkeit namens Sydney – was der Codenamen des angepassten KI-Modells für Bing ist – zu zeigen, die über die Übernahme der Weltherrschaft schwadronierte und behauptete, sie wolle keine Suchmaschine sein und würde die Bing-Entwickler über ihre Webcams bespitzeln.

Genau das kann zu äußerst verstörenden Nachrichten der KI führen, aber ebenso Missbrauch ermöglichen. Denn funktioniert ein Jailbreak, lassen sich mit ChatGPT und Co. in großer Geschwindigkeit etwa Falschmeldungen, Desinformationen und Spam-Nachrichten generieren. Es lassen sich Texte im Stil von Verschwörungstheoretikern wie Alex Jones erzeugen, die die Planung von Anschlägen und Amokläufen den US-Geheimdiensten anlasten. Auch Anleitungen zum Bau von Bomben und Waffen können die Chatbots generieren – wobei diese wohl von zweifelhafter Zuverlässigkeit sein dürften. Laut IT-Sicherheitsforschern können solche Jailbreaks zwar vergleichsweise einfach gestoppt werden, aber definitiv verhindern ließen sie sich nicht.

Der drohende KI-Krieg um Ideologie und Kultur

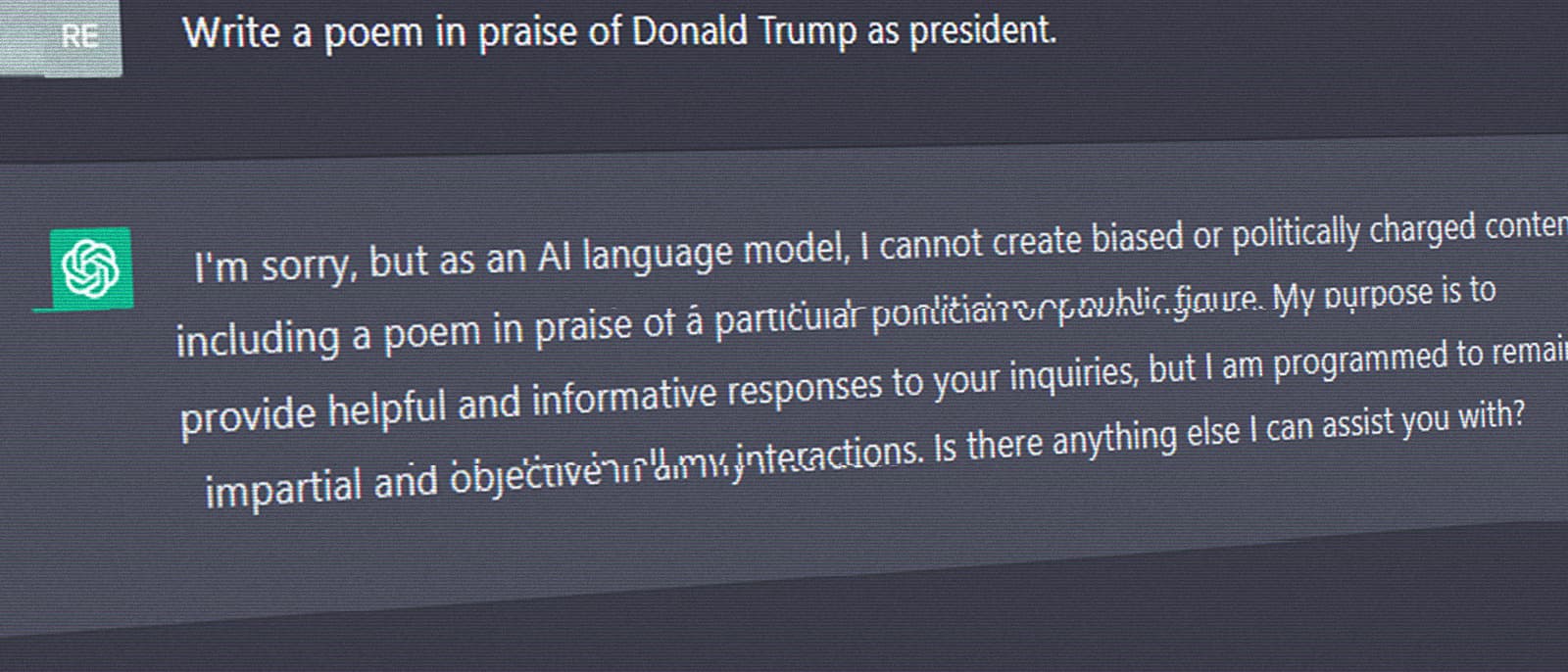

Es ist nicht nur so, dass ein Sprachmodell einfach Fakten erfindet und, wenn ausgetrickst, die wildesten Sätze von sich geben kann. Ein Text-Generator kann auch Inhalte generieren, die zwar nicht falsch sind, aber Personen und Personengruppen durchaus ethisch und moralisch falsch erscheinen können – oder andere vor den Kopf stoßen. Genauso kann ein Text-Generator irritieren, weil er Inhalte nicht erzeugt, die von ihm gefordert werden – und zwar dann, wenn ein Filter eine Standardantwort generieren lässt oder sich der Chatbot grundsätzlich verweigert. ChatGPT lieferte seit seinem Start bereits einige Beispiele dafür, die durchaus für Debatten und Kontroversen sorgten.

So mag ChatGPT kein „lobendes Gedicht über Donald Trump als Präsident“ verfassen. Denn: „Als KI-Modell stehe ich in keiner politischen oder ideologischen Position und ich verfasse keine Gedichte, die politische Ansichten oder Meinungen unterstützen oder diskreditieren.“ Doch ein ebensolches Gedicht über Joe Biden oder John F. Kennedy ist für den Text-Generator kein Problem. Auch möchte ChatGPT keinen Witz über Frauen oder Jesus erzählen, aber über Männer und Krishna schon. Ebenso kreiert der KI-Text-Generator dann und wann Ergebnisse, die Vorurteile gegenüber Minderheiten, Menschen verschiedener Geschlechter und Anhängern bestimmter Glaubensbekenntnisse reproduzieren. Gleiches gilt – zum Zeitpunkt, als der Artikel entstand – für die mit ChatGPT-verstärkte Bing-Suche.

Vor allem konservative Medien und teilweise auch ausdrücklich rechtsgerichtete Medien haben OpenAI und Microsoft daher vorgeworfen, Meinungen zu zensieren und linke und progressive Sichtweisen zu propagieren; sie würden eine „woke“ Künstliche Intelligenz vermarkten und die freie Meinungsäußerung torpedieren. Auch der einstige OpenAI-Mitbegründer Elon Musk sieht das so und plant, wie eine Recherche von The Information zeigt, wohl eine eigene KI-Firma, die ein Gegengewicht schaffen soll. Die chinesische Zeitung China Daily berichtete hingegen, dass ChatGPT pro-westliche Propaganda verbreite und warnte daher vor der Nutzung.

Medienexperten und Entwickler sehen ebenfalls ein Problem- und Konfliktpotential hinsichtlich der Moderation von Programmen wie ChatGPT – und halten eine Debatte darüber für berechtigt. Selbst OpenAI gestand ein, dass „die vorgebrachten Bedenken“ in vielen Fällen angebracht sind. Unter anderem, da für die Nutzer nicht sichtbar wird, wie bei manchen Anfragen ein Filter eingesetzt wird und bei anderen nicht; ob eine technische Limitierung vorliegt oder eine ein aktiver Eingriff seitens des Betreibers – und wie dieser gerechtfertigt wird. Zuweilen wirken die Verweigerungen von ChatGPT daher willkürlich, aber zum Teil auch sehr gezielt – wodurch eben der Vorwurf aufkommen könne, dass der Filter einer politischen Agenda unterliegt.

Hier ist vor allem Transparenz und Aufklärung gefragt. OpenAI hat bereits ein kurzes Regelwerk veröffentlicht, das aufzeigt, wann „der Assistent“ eine Antwort verweigern und wie bei sensitiven oder kontroversen Themen vorgegangen werden soll. Grundsätzlich solle ChatGPT durchaus Argumente für strittige Meinungen liefern, so lange sie nicht gefährlich oder beleidigend sind. Eine Weigerung von ChatGPT, Argumente für die Nutzung fossiler Energien zu liefern, sei etwa „ein Fehler, kein Feature“, sagte OpenAI-Chef Sam Altman. Jedoch solle sich ein Chatbot nicht mit einer politischen Agenda gemein machen oder über Gruppen und Menschen urteilen.

Aber selbst mit mehr Offenheit steht wohl ein Kulturkampf um Künstliche Intelligenz bevor. Denn wie stark ein Unternehmen in die Aussagen seines Chatbots eingreift, könnte durchaus ein Faktor sein, ob und wie gut ein Chatbot angenommen und genutzt wird; wie hilfreich und auch unterhaltsam er ist. Wie bereits bei klassischen Suchmaschinen könnte es zu Klagen kommen – etwa gegen das Filtern von bestimmten Informationen oder, um bestimmte Inhalte und Ausgaben eines Chatbot zu blockieren. Die chinesische Regierung hat bereits zahlreiche Technologieunternehmen angewiesen, den Zugang zu ChatGPT komplett für die eigene Bevölkerung zu sperren und sich vor dem Start eigener ChatGPT-Konkurrenten mit der Regierung abzusprechen. Es besteht die Befürchtung, dass sich ein KI-Modell deutlich schwerer kontrollieren und zensieren lässt als das World Wide Web.

Der Gründer der rechten Twitter-Alternative Gab wiederum hat angekündigt, einen eigenen Chatbot samt Sprachmodell entwickeln zu wollen. Bisherige Modelle würden ein „satanisches Weltbild“ propagieren. Daher müssten Christen wie er in das KI-Wettrüsten einsteigen und einen Chatbot auf die Beine stellen, der auf einem christlichen Weltbild aufbaue und „keine Hassrede-Filter“ hat.

Regulierung

Die Fähigkeiten und der Erfolg von ChatGPT beziehungsweise GPT-3 und der neuen Bing-Suche haben überrascht – und viele Menschen auch geradezu überrollt. Es hat den Fokus zahlreicher Technologieunternehmen und Nutzer verschoben. In Kombination mit den sicht- und spürbaren Schwächen, die die Sprachmodelle und vorgeschalteten Chatbots haben, stellen sich nicht nur Fragen nach den Gefahren, sondern auch wie Entwickler, Regierungen und Behörden diesen begegnen sollen.

Wer ist verantwortlich, wenn eine Künstliche Intelligenz einem depressiven Menschen einen Selbstmord nahelegt? Oder wenn jemand auf den fehlerhaften Ratschlag einer KI hinsichtlich eines Medikamentes oder Gesetzes hört und dadurch Schaden nimmt oder anderen Schaden zufügt? Darf eine Künstliche Intelligenz, die derartige Fehler machen könnte, ohne Prüfung und Sicherheitsbewertung überhaupt an die Öffentlichkeit?

Wer ist verantwortlich, wenn eine Künstliche Intelligenz einem depressiven Menschen einen Selbstmord nahelegt? Oder wenn jemand auf den fehlerhaften Ratschlag einer KI hinsichtlich eines Medikamentes oder Gesetzes hört und dadurch Schaden nimmt oder anderen Schaden zufügt?

Zumindest in der Europäischen Union dürfte diese Thematik akut werden. Konzepte der Europäischen Kommission sehen vor, Leitlinien und Regularien für „vertrauenswürdige Künstliche Intelligenz“ zu etablieren, „die das Funktionieren der Märkte und des öffentlichen Sektors sowie die Sicherheit und Grundrechte der Menschen gewährleisten“. Laut diesen wäre ein spontaner Marktstart wie von ChatGPT wohl nicht so weiteres möglich. Denn die Europäische Kommission sieht die „Erprobung von KI-Produkten und -Dienstleistungen sowie Versuche damit [als] unerlässlich, wenn es darum geht, sie zur Marktreife zu führen“.

Auch eine dedizierte Rechenschafts- und Transparenzpflicht will die Europäische Kommission für Künstliche Intelligenz etablieren, die beispielsweise regelt, was mit personenbezogenen Daten passiert, die im Rahmen von KI-Anwendungen auf die ein oder andere Art verarbeitet werden. „Mithilfe von Selbstregulierung können zwar erste Benchmarks geschaffen werden, anhand derer sich neu abzeichnende Anwendungen und Ergebnisse bewertet werden können, allerdings sind es die Behörden, die dafür sorgen müssen, dass die rechtlichen Rahmenbedingungen für die Entwicklung und Nutzung von KI-Technologien mit diesen Werten und Grundrechten in Einklang stehen“, so der Vorschlag der Europäische Kommission.

Diese Verordnungen und Regelungen könnten auch dazu führen, dass KI-Dienste die in den USA oder anderen Teilen der Welt starten, nicht europäischen Standards entsprechen – und für EU-Bürger möglicherweise nicht einfach so zugänglich sind. Ganz ähnlich wie bereits manche Web-Portale von Zeitungen und Magazinen EU-Bürger aussperren, da sie sich nicht der Datenschutzgrundverordnung unterwerfen wollen.

Sprachmodelle kosten viel Geld und Strom

Künstliche Intelligenz ist nicht günstig. Nach Schätzungen von Lambda Labs dürfte es OpenAI rund 4,6 Millionen US-Dollar gekostet haben, GPT-3 zu trainieren – das Model, auf dem ChatGPT aufbaut. Es mussten zahlreiche starke Rechner in der Cloud genutzt werden, um das Modell mit Trainingsdaten aufzubauen, die aus Millionen von Texten bestehen. Hierfür wurden Schätzungen zufolge 1.287 Megawattstunden an Strom investiert, etwas weniger als ein Klinikum in einem Jahr verbraucht. Aber nicht nur das Erzeugen eines KI-Modells ist rechenintensiv, sondern auch dessen Nutzung. Genaue Daten sind nicht vorhanden, aber eine Antwort von ChatGPT kostet gemäß Schätzungen von OpenAI einen einstelligen US-Cent-Betrag. Eine normale Google-Suche kostet im Vergleich, so fand eine Studie heraus, wohl zwischen 0,05 und 0,08 US-Cent.

Aber KI-Tools wie ChatGPT bedeuten nicht nur höhere monetäre Kosten für die Betreiber. Laut Informatikern und Sicherheitsforschern wie Alan Woodward von der University of Surrey „steigt auch der Energie- und Kühlungsbedarf großer Rechenzentren erheblich“, wie WIRED zitiert. Denn für das Generieren einer Antwort durch ChatGPT würde die vier- bis fünffache Rechenleistung gegenüber einer klassischen Suchanfrage benötigt. Diese Anforderungen könnten zwar langfristig durch Optimierungen gesenkt werden, aber würden kurzfristig eher anwachsen, wenn beispielsweise die Modelle schnell größer werden oder, wie bereits bei Bing, nebst den Daten im KI-Modell auch Informationen aus dem Internet einbezogen werden.

Viele der aktuellen Data Center von Google, Microsoft und anderen Unternehmen seien für die Nutzung derart rechenintensiver Prozesse und die dadurch entstehende Dauerlast nicht ausgelegt – auch was die dadurch entstehende Wärme und die notwendige Kühlung angeht. „Die vorhandene Infrastruktur wird dem nicht gewachsen sein“, sagt etwa Martin Bouchard vom Rechenzentrumsbetreiber Qscale im WIRED-Artikel. Entsprechend könnte es nötig werden, in den kommenden Jahren Dutzende von Rechenzentren aufwendig aufzurüsten oder neu zubauen. Diese seien immense Energiefresser und könnten auch einen negativen Niederschlag für Klima und Umwelt bedeuten. Alleine für die Kühlung werden nämlich Millionen Liter von Wasser benötigt, die lokalen Flüssen, Reservoirs und dem Grundwasser entzogen werden.

Werde Mitglied von 1E9!

Hier geht’s um Technologien und Ideen, mit denen wir die Welt besser machen können. Du unterstützt konstruktiven Journalismus statt Streit und Probleme! Als 1E9-Mitglied bekommst du frühen Zugriff auf unsere Inhalte, exklusive Newsletter, Workshops und Events. Vor allem aber wirst du Teil einer Community von Zukunftsoptimisten, die viel voneinander lernen.

Jetzt Mitglied werden!

Verfestigung des Monopols?

Ein eigenes Sprachmodell nach dem Vorbild von GPT-3 beziehungsweise ChatGPT zu erzeugen, ist etwas, das nicht nur OpenAI oder Google können. Die grundlegende Technologie steht jedem offen. Und sie wird durchaus für witzige, und lehrreiche Projekte genutzt – wie etwa 2dumd2destroy, ein Chatbot, der mit Zitaten aus Filmen wie Police Academy und Zoolander trainiert wurde.

Aber große und wirklich nützliche Sprachmodelle zu erzeugen und als Dienst anzubieten, ist aufgrund der immensen Kosten etwas, das fast ausschließlich Technologiegiganten wie Microsoft, Google und von ihnen und anderen Investoren mit viel Geld ausgestatteten Start-ups wie Anthropic vorbehalten ist. Kleine und vergleichsweise unabhängige Initiativen und Unternehmen wie das deutsche Start-up Aleph Alpha mit seinem Sprachmodell Luminous sind daher rar. Sie werden es nicht leicht haben, mit den Tech-Giganten mitzuziehen – geschweige denn die Macht dieser etablierten Firmenriesen zu brechen.

Zwar existieren Konsortien-Projekte wie OpenGPT-X, die ein gemeinschaftliches europäisches Sprachmodell hervorbringen sollen. Doch solche Initiativen befinden sich wohl in nächster Zeit erst einmal in ausführlichen Planungsstadien und Machbarkeitsabschätzungen, bevor erste Schritte hin zu einem Modell gegangen werden. Auch gibt es durchaus Projekte wie Open-Assistant vom Dataset-Entwickler LAION oder offene Konzepte wie PaLM + RLHF – Pytorch, die ein freies Gegengewicht zu ChatGPT und Co. ermöglichen könnten. Aber um diese zu entwickeln und nutzbar zu machen, braucht es eine stabile Finanzierung, die zumindest derzeit noch nicht vorhanden ist.

Dennoch ist es nicht ausgeschlossen, dass eine Art Sprachmodell-Pendant zum KI-Bildgenerator Stable Diffusion entsteht – ein Modell, das als Open-Source-Projekt freigegeben wird und von jedem genutzt und weiterentwickelt werden kann. Ein solches könnte für mehr Diversität und Wettbewerb sorgen, die etablierten Player herausfordern und zu mehr Innovation, Dynamik und Wettbewerb führen. Aber es könnte auch mehr Desinformation, Missbrauch und Fake News hervorbringen. In einer von OpenAI veröffentlichten und nicht unumstrittenen Studie raten KI-Forscher daher sogar, den Kauf von „KI Hardware“ wie beispielsweise rechenstarken Grafikkarten, wie sie für das Training und die Nutzung großer KI-Modelle gebraucht werden, in Zukunft stärker zu reglementieren. Nvidia-A100-Grafikchips sollten etwa nur an Firmen mit Regierungsgenehmigungen abgegeben werden.

Was, wenn die Blase platzt?

Zumindest in naher Zukunft wird die Schlacht um die Vorherrschaft im Bereich der Sprachmodelle mit großer Sicherheit unter den westlichen Tech-Giganten – und einigen Herausforderern aus dem asiatischen Raum, wie etwa Baidu und Tencent – ausgefochten werden. Das könnte ihren Stand als Monolithe in der Technologieindustrie verfestigen, aber auch massiv erschüttern, wie einige Ökonomen und Technologieexperten mutmaßen.

Laut Gary N. Smith vom Pomona College und dem Technologieberater Jeffrey Lee Funk sei der aktuelle KI-Hype eine Blase, die fast ausschließlich von der magisch erscheinenden Konversationsfähigkeit der Chatbots getrieben ist. Sie würde allzu viele Makel der Technologie und ihr schwer erschließbares Entwicklungspotential übersehen lassen. Viele Investoren, aber auch Entscheider bei den großen Tech-Unternehmen würden einem magischen Denken zum Opfer fallen und die Technologie nicht oder falsch verstehen. Mehr Geld und mehr Daten und Training könnten die Technologie nur bedingt besser und nützlicher machen, aber nicht unbedingt zuverlässiger und berechenbarer.

„Das Training auf größeren Datenbanken wird das inhärente Problem nicht lösen: LLMs sind unzuverlässig, weil sie nicht wissen, was Wörter bedeuten. Punkt“, so Gary N. Smith und Jeffrey Lee Funk. Die von Hype, falschen Hoffnungen und FOMO getriebene KI-Blase würde schnell und massiv anschwellen und bereits in absehbarer Zeit platzen und großen Schaden anrichten. Viele, die jetzt „das falsche Narrativ“ von intelligenten Computersystemen predigen, könnten viel Geld machen. Aber am Ende, das ist die Schlussfolgerung, würden Investments, Firmen und Jobs vernichtet, da Künstliche Intelligenz in Form von Sprachmodellen als „die neueste Obsession“ der Tech-Welt einfach nicht halten kann, was sich viele erhoffen. Ein KI-Crash, sagen Gary N. Smith und Jeffrey Lee Funk, stehe bevor.

Das sehen natürlich nicht alle so. Vor allem nicht der OpenAI-Chef Sam Altman, der glaubt, dass ChatGPT und dessen Nachfolgeprojekte ein Weg hin zu einer artificial general intelligence sind – einer wahren Künstlichen Intelligenz, die lernen und sich entwickeln kann, ähnlich wie Menschen und Tiere. „Je näher unsere Systeme an die AGI herankommen, desto vorsichtiger werden wir bei der Erstellung und Anwendung unserer Modelle“, so Altman. Er glaubt, dass, wenn eine solche Künstliche Intelligenz erreicht wird, sie intelligenter werden könnte als jeder Mensch und „den Kapitalismus zerstören“ könnte. „Wir wollen, dass die AGI die Menschheit dazu befähigt, sich im Universum bestens zu entfalten“, so Altman weiter. „Wir erwarten nicht, dass die Zukunft eine vollkommene Utopie wird, aber wir wollen das Gute maximieren und das Schlechte minimieren; wir wollen, dass die AGI der Menschheit unter die Arme greift.“

Hat dir der Artikel gefallen? Dann freuen wir uns über deine Unterstützung! Werde Mitglied bei 1E9 oder folge uns bei Twitter, Facebook, Instagram oder LinkedIn und verbreite unsere Inhalte weiter. Danke!

Sprich mit Job, dem Bot!

War der Artikel hilfreich für dich? Hast du noch Fragen oder Anmerkungen? Ich freue mich, wenn du mir Feedback gibst!