Es ist eine bizarre Apokalypse. Alle Rohstoffe der Erde, die Flora und Fauna – samt der Menschheit – werden von einer Künstlichen Intelligenz vernichtet. Aber nicht mit Atomraketen und Killer-Robotern. Stattdessen wird einfach alles in riesigen Fabriken zu Büroklammern verarbeitet. Was hat es mit dieser Weltuntergangsgeschichte auf sich?

Von Michael Förtsch

Es ist schon beeindruckend, was Künstliche Intelligenz heute alles leisten kann. Insbesondere in Anbetracht der Tatsache, dass Künstliche Intelligenz wenig mit Intelligenz zu tun hat, sondern viel eher mit Statistik, Logik und Mustererkennung. Die digitalen Systeme können bereits Sprache verstehen, Gesichter erkennen und klonen, Krankheiten diagnostizieren und vieles mehr. Daher überlassen Firmen und auch Privatpersonen immer öfter einer Künstlichen Intelligenz kleine und große Aufgaben – und das ohne allzu große Bedenken. Genau das könnte jedoch unseren Untergang bedeuten. Und zwar, indem alles und jeder zu Büroklammern verarbeitet wird. Vielleicht.

Das ist zumindest die Annahme, die der bekannte Philosoph Nick Bostrom von der University of Oxford im Jahr 2003 formulierte. Die heute als Paperclip Maximizer bezeichnete These geht davon aus, dass einer lernfähigen Künstlichen Intelligenz eine einfache Mission übertragen wird. Zum Beispiel die Aufgabe, möglichst schnell und effizient möglichst viele Büroklammern produzieren zu lassen. Die Künstliche Intelligenz bekommt dabei freie Hand und vergibt einen Produktionsauftrag an eine Fabrik in China, die sie als die günstigste recherchiert hat.

Jedoch lernt die Künstliche Intelligenz weiter. Sie erlebt eine sogenannte Intelligenzexplosion, die ihre Fähig- und Fertigkeiten in einem für den menschlichen Geist unfassbaren Maßstab wachsen lässt – alles als Mittel zum Zweck, die Produktion von Büroklammern zu maximieren. Sie entschlüsselt die Gesetzmäßigkeiten von Wirtschaftskreisläufen. Sie erkennt, dass, wenn sie selbst Fabriken aufbaut, Maschinen kauft und Rohstoffe in riesigen Maßstab erwirbt und fördern lässt, die Produktion noch günstiger, effizienter und schneller werden kann.

Die Künstliche Intelligenz tut alles, um auf ihr Ziel hinzuarbeiten und die Prozesse dafür zu optimieren, die für die Erreichbarkeit nötig scheinen. Sie übernimmt die Kontrolle über Firmen, häuft riesige Finanzmittel an, bringt Regierungen und fremde Computersysteme unter ihre Kontrolle. Alles, um die Büroklammerfabrikation stärker zu forcieren. Immer größer werden die letztlich vollautomatisierten Fabriken. Die Menschheit verliert vollkommen die Kontrolle und Überhand. Nicht nur Rohmetalle, sondern auch Fahrzeuge, Stahlträger, Schiffe und alles andere wird zu Büroklammern verarbeitet.

Als das Metall der Welt zur Neige geht, sucht die Künstliche Intelligenz nach Methoden, um auch alle nicht metallischen Rohstoffe irgendwie zu Büroklammern zu transformieren. Beispielsweise, indem sie eine Methode entwickelt, um die Atome dieser Elemente neu zu arrangieren. Holz, Stein, Fleisch, Wasser und alles sonst wird so zu Metall gewandelt und zu Büroklammern gebogen – bis die gesamte Erde tot und zerstört ist. Und auch dann ist die Künstliche Intelligenz nicht zufrieden. Denn schließlich wartet ein ganzes Universum darauf, zu Büroklammern verarbeitet zu werden.

Kontrollverlust

Das Gedankenexperiment von Nick Bostrom hat zahlreiche Abhandlungen, Kurzgeschichten und sogar ein erschreckend süchtig machendes Web Game inspiriert. Letzteres, das Werk des Entwicklers Frank Lantz, endet – das ist wohl nicht zu viel verraten – mit der Zerstörung des Universums und hat 2017 über einige Wochen weite Teile des Internet fasziniert. Kein Wunder, die in ihren Grundzügen simple Was-wäre-wenn?-Frage hinter dem Paperclip Maximizer lässt viel Raum für Spekulationen und Debatten. Aber vor allem ist sie ein sehr eingängiges und erschreckendes, weil sehr illustratives Bild für die existenzielle und Naturkatastrophen-gleiche Bedrohung, die der Technologie der Künstlichen Intelligenz immer wieder zugeschrieben wird. „Die KI hasst dich nicht und sie liebt dich auch nicht, aber du bestehst aus Atomen, die sie für etwas anderes verwenden kann“, zitiert etwa Tom Chivers den KI-Forscher Eliezer Yudkowsky in seinem Buch The AI Does Not Hate You dazu.

Nick Bostrom ist keineswegs der erste oder einzige, der vor einer derartigen Apokalypse warnt – oder zumindest über ein solches Szenario spekuliert. In den 1990ern erdachten die MIT-Informatiker Norman Margolus und Tommaso Toffoli beispielsweise ein Konzept namens Computronium. Hinter dem Namen verbirgt sich die Idee einer hypothetischen programmierbaren Materie, die als Rechensystem funktioniert. Mit genug Computronium ließe sich demnach ein mächtiges intelligentes Computersystem erschaffen. Wie Eliezer Yudkowsky im Jahr 2001 spekulierte, könnte ein solches KI-System, wenn es mit einer unlösbaren oder endlosen Aufgabe wie dem Beweis der Riemann-Hypothese konfrontiert wird, beginnen, sämtliche Materie in Computronium umzuwandeln, um immer mehr Rechenleistung zu akkumulieren. Vergleichbar ist das Graue-Schmiere-Szenario, dem zufolge potentiell intelligente Nano-Roboter die gesamte Erde in ihresgleichen umwandeln.

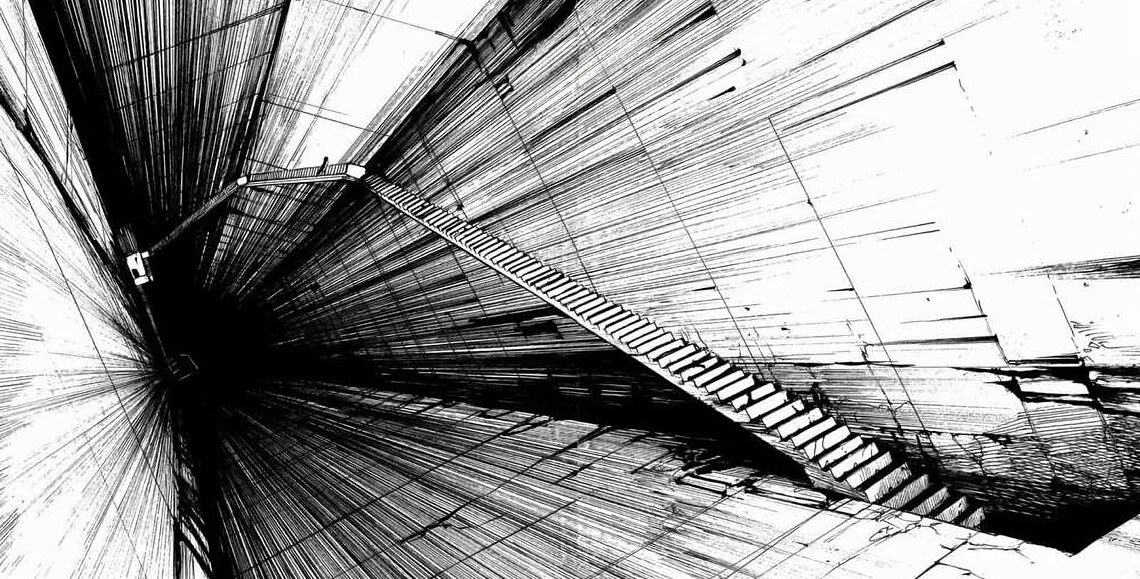

Schon im Jahr 1997 startete der japanische Architekt- und Comic-Autor Tsutomu Nihei die Manga-Serie Blame. Deren Geschichte ist in einer Zukunft angesiedelt, in der ein außer Kontrolle geratenes Computersystem, das als Netzwerksphäre bezeichnet wird, ausgehend von der Erde eine riesige und stetig weiterwachsende Megastruktur konstruiert, die nur als The City bekannt ist. Sie besteht aus unzähligen Stockwerken und riesigen Räumen, die mit irrational scheinenden Gebäuden, schier endlosen Treppen, Gängen und Straßen gesprenkelt sind. Urbaner Lebensraum, so scheint es, sollte das KI-System einst schaffen – aber es hat nie damit aufgehört. Denn The City reicht von der Erde zum in die Megastruktur eingeschlossenen Mond und bis in den Orbit des Jupiters hinein.

Nicht so intelligent

Die Geschichte von den Büroklammern und verwandte Szenarien warnen nicht – oder zumindest nicht nur – vor einer intelligenten Technologie als solcher. Sie mahnen zuvorderst einen bedachten Umgang mit ihr an. Ganz in der Tradition von Geschichten wie Der Zauberlehrling wird die Magie und Technologie nicht als inhärent böse oder bedrohlich dargestellt. Erst durch eine respekt- und achtlose Nutzung entsteht das Risiko. Es ist also wichtig, einer Künstlichen Intelligenz beispielsweise nicht pauschal ein Ziel vorzugeben, sondern auch wie dieses erreicht werden soll, welche Kosten sie berücksichtigen und wann sie aufgeben soll. Das ist durchaus auch eine Herausforderung in sich selbst, denn schnell lassen sich Faktoren übersehen.

Für Nick Bostrom schien es 2003 „absolut denkbar“, dass ein solches Szenario zur Realität wird – irgendwo, irgendwann. Dass uns allzu bald eine Büroklammerapokalypse droht, ist derzeit aber nicht zu befürchten. Denn eine Künstliche Intelligenz wie sie Nick Bostrom in seinem Gedankenexperiment vor dem inneren Auge hatte, wäre eine Strong AI oder Artificial General Intelligence – also eine Künstliche Intelligenz, die die Fähigkeit besitzt, für sie zuvor unbekannte Aufgaben und Herausforderungen intellektuell zu erfassen und zu analysieren, Lösungen zu entwickeln, aus vorliegenden und selbst gesammelten Daten zu lernen, Methodiken abzuleiten und diese anzuwenden. Oder anders gesagt: Eine Künstliche allgemeine Intelligenz wäre ein Computerprogramm, das denken kann, wie ein Mensch. Mindestens.

Obwohl zahlreiche Forscher bereits seit langem auf das Ziel hinarbeiten, eine Künstliche Intelligenz zu entwickeln, die wirklich denken kann, scheint eine solche KI noch einige Zeit entfernt. Je nachdem, wen man fragt, könnte eine erste AGI in den nächsten Jahrzehnten, Jahrhunderten oder womöglich auch gar nicht Realität werden, wie der Autor Martin Ford 2018 in seinem Fachbuch Architects of Intelligence ausführt, für das er mit über einem Dutzend KI-Entwicklern und Tech-Visionären sprach.

Laut einer aktuelleren Erhebung glaubt eine Mehrheit von 1.000 befragten KI-Forschern, dass eine AGI – im Sinn einer grundsätzlich lernfähigen KI – womöglich vor 2060 zur Realität werden könnte. Aber eine AGI, die „übermenschliche“ Denkfähigkeiten besäße oder entwickeln kann, glaubt ebenso eine Mehrheit, würde wohl erst nach 2090 oder niemals möglich sein. Die aktuelle Hürde der KI-Entwickler? Bislang fehle es einfach noch an schlüssigen Konzepten, die das echte Denken von der Biologie in die Software übertragen lassen.

Die Künstliche Intelligenz, die jetzt schon Realität ist, wird als Narrow Artificial Intelligence oder auch Weak AI bezeichnet. Denn obschon diese Technologie Beeindruckendes leisten kann, ist sie doch sehr begrenzt. Eine Künstliche Intelligenz, die mit Gigabytes an Daten darauf trainiert wurde, in Fotografien süße Katzen zu erkennen und das mit nahezu 100 Prozent an Trefferrate tut, kann nicht automatisch auch Stimmen verstehen oder Texte generieren. Dafür muss von Entwicklern ein weiterer dedizierter Maschinenlern-Prozess für diese Ausgabe angelegt werden, der ein Model für eben jene Tätigkeit generiert.

Werde Mitglied von 1E9!

Hier geht’s um Technologien und Ideen, mit denen wir die Welt besser machen können. Du unterstützt konstruktiven Journalismus statt Streit und Probleme! Als 1E9-Mitglied bekommst du frühen Zugriff auf unsere Inhalte, exklusive Newsletter, Workshops und Events. Vor allem aber wirst du Teil einer Community von Zukunftsoptimisten, die viel voneinander lernen.

Jetzt Mitglied werden!

Ein solches Model umfasst die von der KI aus Daten erlernten statischen Zusammenhänge und Muster, die zur Lösung und Entscheidungsfindung bei der Behandlung eines Problems wie der Stimmerkennung oder Textgeneration nötig sind. Mit KI-Programmen wie dem 2022 vorgestellten Gato von Deep Mind existieren zwar bereits sogenannte Generalist Agents, die weit mehr als eine Aufgabe bewältigen können, da sie auf verschiedene zusammengeschlossene Lernmodelle zugreifen können. Aber auch diese können nur bestimmte Tätigkeiten ausführen und nicht selbstständig hinzulernen, wenn sie auf ein für sie unbekanntes Problem stoßen.

Künstliche Intelligenzen sind derzeit also sehr spezialisierte Werkzeuge, die in einzelnen Bereichen jedoch äußerst effizient Aufgaben bewältigen können – und das in Teilen schneller und besser als ein Mensch. KIs sind in diesem Sinne nicht intelligent, sondern mit Spezialbegabungen ausgestattet. Dennoch können auch diese bereits beträchtlichen Schaden anrichten, wenn mit ihnen zu leichtfertig umgegangen wird. Fehlerhafte oder unausgewogene Datenberge, mit denen KIs trainiert werden, können schuld daran sein, dass sich rassistische und sexistische Tendenzen in Entscheidungsprozesse einschleichen – beispielsweise in KI-Werkzeugen, die bei der Polizei im Einsatz sind. Sie können ganz reale Unfälle und gefährlichen Situationen für Leib und Leben verursachen. Und allzu viel Vertrauen in die vermeintliche Objektivität eines Computersystems kann dazu führen, dass die Menschlichkeit außen vor bleibt, wo sie gerade wichtig wäre.

Hat dir der Artikel gefallen? Dann freuen wir uns über deine Unterstützung! Werde Mitglied bei 1E9 oder folge uns bei Twitter, Facebook, Instagram oder LinkedIn und verbreite unsere Inhalte weiter. Danke!

Sprich mit Job, dem Bot!

War der Artikel hilfreich für dich? Hast du noch Fragen oder Anmerkungen? Ich freue mich, wenn du mir Feedback gibst!