Der Energiebedarf von Supercomputern und Künstlicher Intelligenz (KI) wird kritisch gesehen: In Hochzeiten nimmt der Supercomputer des Leibniz-Rechenzentrums (LRZ) rund 3400 Kilowatt Strom auf, mit dieser Menge könnte eine Kleinstadt versorgt werden. Auf KI spezialisierte Systeme sind zwar nicht ganz so energiehungrig, dafür benötigen sie fürs Training Hunderte von Durchläufen, um daraus Systeme zur Erkennung von Mustern oder zur Verarbeitung natürlicher Sprache zu entwickeln. Seit 2006 arbeitet das LRZ daran, den Energiebedarf seiner Systeme zu drosseln. Mit Technologie-Unternehmen hat es eine Warmwasserkühlung entwickelt und optimiert, die weltweit Standards setzte. Mehr Effizienz sollen nun Beschleuniger wie Graphics Processing Units (GPU) oder Quantencomputer ins Supercomputing bringen, zudem rückt die Software-Programmierung ins Visier notwendiger Veränderungen: „Konkret hilft uns zurzeit die Optimierung von Algorithmen und Applikationen, um den Strombedarf zu drosseln“, berichtet Prof. Dieter Kranzlmüller, Leiter des LRZ. „Im Bereich Software und Anwendungen kann er durch den Einsatz von KI und intelligenter Steuerung weiter sinken.“ Ein Gespräch über das Stromsparen und Forschen für neue Lösungen.

In Wissenschaft und Forschung breiten sich die Methoden der KI weiter aus. Das LRZ hat vergangenes Jahr ein Cerebras CS-2-System in den Dienst genommen – wie viel Energie braucht es bei hoher Auslastung? Prof. Dieter Kranzlmüller: Mit seinen 850.000 Rechenknoten ist das Cerebras-System ein Supercomputer, allerdings spezialisiert auf KI-Methoden, das maschinelle Lernen und Anwendungen der Verarbeitung natürlicher Sprache, NLP. Für das Training von neuronalen Netzen können dabei auf einem einzigen Chip bis zu 40 Gigabyte Daten gespeichert und schnell zwischen Prozessoren und Knoten ausgetauscht werden. Das ist ein großer Vorteil, dennoch braucht das System im Standby-Betrieb 15, unter Volllast rund 35 Kilowatt. Im Vergleich mit Supercomputern ist das aber wahrlich nicht viel. SuperMUC-NG besteht aus 6480 Rechenknoten mit 311.040 Rechenkernen, braucht aber bei höchster Auslastung rund 3400 Kilowatt Strom. Dafür sind die daran berechneten Modelle und Simulationen deutlich größer. Trotzdem wird der Energiebedarf von KI gerade zum Thema. Sie dringt erstens immer tiefer in unseren Alltag ein, zweitens wachsen in der Forschung die Modelle und neuronalen Netze und damit ihr Strombedarf rasant. Allein die letzte Trainingsrunde des Textgenerators ChatGPT soll nach Schätzungen der Universität Kopenhagen knapp 190.000 Kilowatt-Stunden Strom gekostet haben. Nun könnten wir uns am LRZ darauf berufen, dass Wissenschaftler:innen ja mit unseren Supercomputern jene Szenarien berechnen und modellieren, die wir benötigen, um Umweltprobleme zu verstehen und Strategien gegen den Klimawandel zu entwickeln. Doch seit 2006 arbeiten wir daran, den Energiebedarf unserer Computer-Anlagen zu reduzieren und zum klimaneutralen Rechenzentrum zu werden. Das neue Cerebras-System ist auch in dieser Hinsicht ein spannendes Test- und Forschungsfeld für uns.

Die Phase 2 von SuperMUC-NG wird mit Graphics Processing Units von Intel, mit Ponte Vecchio-GPU, ausgestattet. Wie werden sie sich auf den Energiebedarf des Supercomputers auswirken? Kranzlmüller: Wir haben noch keine Leistungsdaten des neuen Systems, es befindet sich gerade im Aufbau. Neben den gewohnten Central Processing Units oder CPU arbeiten darin GPU, die sich angeblich besonders für KI-Methoden eignen, Rechenleistung beschleunigen, aber auch mehr Strom benötigen. Mit seinen 240 Rechenknoten wird Phase 2 im Normalbetrieb schätzungsweise 500 Kilowatt Strom brauchen. Andererseits: Wenn Simulationen mit den leistungsfähigeren und vielseitigeren GPU schneller bewältigt werden, hilft uns das, eine Menge Energie einzusparen. Diesen Effekt werden wir aber erst im laufenden Betrieb beziffern können – es wird spannend.

Sie beobachten, dass sich der KI-Rechenbedarf bei Ihren Anwender:innen etwa alle 4 Monate verdoppelt. Die neuronalen Netze oder Trainingsmodelle werden laufend um weitere Parameter ergänzt und wachsen enorm. Um für eine Forschungsfrage ein brauchbares Modell aufzubauen, werden oft hunderte andere verworfen oder angepasst. Auch dadurch wächst der Energiebedarf von KI. Kann man dagegen etwas tun? Kranzlmüller: Wer heute mit KI-Methoden experimentiert und Forschungsdaten verarbeitet, kümmert sich wahrscheinlich nicht so sehr um den Energiebedarf – das war früher auch bei Modellierung und Simulation so. Man probiert neue Methoden aus, verwirft und optimiert sie, macht Erfahrungen – aber damit werden die Verfahren immer besser und effizienter. So entsteht Fortschritt. Auf Dauer ließen sich bei KI-Modellen sicher Redundanzen vermeiden, statt alle zu trainieren könnten einige Aufgaben der KI-Systeme programmiert werden, um Größe zu vermeiden. Aber in dieser ersten Nutzungsphase von KI können wir als wissenschaftliches Rechenzentrum den Energiebedarf vor allem begrenzen, wenn wir an der Kühlung der Systeme und unseren Räumlichkeiten arbeiten. Cerebras wird mit Wasser gekühlt, das ist schon effizienter als die Luftkühlung. Beim Supercomputer sparen wir durch die Heißwasser-Kühlung etwa 20 Prozent Energie und senken außerdem unseren CO2-Fußabdruck dadurch, dass wir die Kühlkreisläufe geschickt aufgebaut haben, die Abwärme nutzen und hoffentlich bald an Nachbarn zum Klimatisieren von Räumen abgeben können. Außerdem setzt das LRZ zu 100 Prozent erneuerbare Energien ein und installiert demnächst Solarmodule auf dem Dach, um selbst Strom zu produzieren. Generell stellt der wachsende Energiebedarf von Computersystemen bei uns Fragen nach den Nutzungsregeln: Heute vergeben wir an Wissenschaft und Forschung Rechenzeit, aus Sicht der Nutzer:innen ist es daher egal, ob Computer viel oder wenig Strom brauchen. Im High-Performance Computing wird daher schon überlegt, stattdessen Energieeinheiten zu vergeben, das könnte mittelfristig vielleicht auch für KI- Systeme eine Alternative sein.

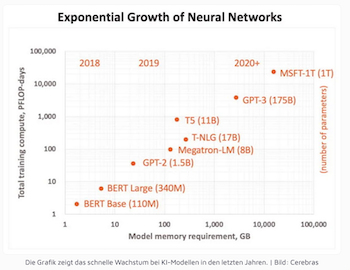

Die Grafik zeigt das Wachstum von neuronalen Netzwerken

fürs Training von KI-Anwendungen

Wie stark beeinflusst die Programmierung beim Supercomputing oder bei KI-Modellen den Energiebedarf? Kranzlmüller: Daran wird in der Informatik gerade intensiv geforscht, zwei Aspekte sind dabei wichtig. Man überlegt einerseits, wie Software energieeffizient entwickelt wird, andererseits, wie die Leistung eines Programms bei der Ausführung zu optimieren ist. Tatsächlich gibt es Programmiersprachen wie Python oder Perl, die energieintensiver sind als zum Beispiel Rust oder C. Wenn ich darüber hinaus die Leistung eines Programms verbessere, so dass es nur halb so lange für die Funktionen braucht, sinkt damit der Energieverbrauch auch dann, wenn die Anwendung etwas mehr Strom benötigt, den aber kürzer. Beim Supercomputing optimieren wir außerdem mit den Wissenschaftler:innen Algorithmen, damit sie flüssiger, schneller und effizienter laufen – eine Aufgabe, die durchaus Wochen oder gar Monate dauern kann.

Die Komplexität von Anwendungen zu reduzieren – das wird bei der KI als eine Strategie für mehr Energieeffizienz gesehen. Könnte das auch beim HPC helfen, den Strombedarf zu senken? Kranzlmüller: Nein, beim HPC setzen wir jetzt auf GPU und andere Beschleuniger, die für einige Funktionen höhere Leistungen bringen und schneller ausführen, folglich weniger Energie benötigen. Mittelfristig ruht die Hoffnung auch auf der Integration von Quantencomputern, die hoffentlich ebenfalls Rechenleistung beschleunigen. Konkret hilft uns zurzeit die Optimierung von Algorithmen und Applikationen. Im SuperMUC-NG sammeln dafür einige Millionen Sensoren unterschiedlichste Betriebsdaten ein, mit deren Hilfe wir Anwendungen verbessern und Laufzeiten verkürzen können. Die Vision ist, generell die Software-Entwicklung mit Betriebsdaten zu verändern und Programme besser auf die Technik abzustimmen.

Gibt’s noch weitere Maßnahmen, um die Energieeffizienz der Supercomputer und AI-Systeme am LRZ zu steigern? Kranzlmüller: Unser Ansatz ist ganzheitlich, für mehr Energieeffizienz arbeiten und forschen wir am LRZ in vier Bereichen: In den Gebäuden sorgen wir unter anderem für eine energieeffiziente Kühlung der Systeme, etwa durch die Warmwasserkühlung und die Nutzung der Abwärme. Durch dynamisch angepasste Taktfrequenzen und durch Beschleuniger können wir den Energiebedarf der Hardware um rund 30 Prozent senken. Intelligente Steuerung sowie Virtualisierung von Hardware helfen ebenfalls beim Stromsparen, ebenso die Optimierung von Betriebssystemen, Bibliotheken und Software. Unter Vollast benötigt SuperMUC-NG daher statt der 3400 nur 2500 Kilowatt Energie. Im Bereich Hardware sind die Möglichkeiten ziemlich ausgereizt, im Bereich Software und Anwendungen kann der Energiebedarf eventuell durch den Einsatz von KI und intelligenter Steuerung weiter sinken. Dafür benötigen wir die Betriebsdaten, fürs Monitoring und für erste Ansätzen einer smarten Auswertung haben wir am LRZ eigene Tools entwickelt.

100 Prozent erneuerbare Energien: Decken Sie damit den gesamten Energiebedarf des LRZ, also auch Ihrer Supercomputer? Kranzlmüller: Für uns kommt der Strom aus der Steckdose, aber wir verlangen vom Lieferanten, dass er uns ausschließlich Strom aus erneuerbaren Quellen liefert – und dies durch Zertifikate nachweist.

Der Run auf erneuerbare Energien wächst: Könnten Versorgungsengpässe das Supercomputing oder die KI ausbremsen? Kranzlmüller: Klar ist, dass die Menge an erneuerbarer Energie noch beschränkt ist. Setzen viele sie ein, könnte es tatsächlich zu Engpässen kommen. Dann wird sich die Frage stellen, ob die Anwendungen aller Rechenzentren gleich wichtig sind. Wie relevant ist eine medizinische Simulation und wie wichtig die Nutzung von Facebook? Wir brauchen HPC und KI allerdings auch dazu, um die Erzeugung von erneuerbaren Energien zu verbessern sowie die Nutzung dieser Energien in den HPC-Systemen zu optimieren. (vs)

Prof. Dieter Kranzlmüller, Leiter des LRZ