Der Google-Chatbot Gemini sorgte in den vergangenen Tagen für negative Schlagzeilen. Denn der integrierte Bild-Generator erzeugte kontroverse Bilder – wegen Googles Bemühungen um Diversität und Sicherheit. Diese gingen auch beim Chatbot selbst zum Teil nach hinten los. Der Google-Chef ist darüber nicht glücklich.

Von Michael Förtsch

Einen Code Red soll Google schon im Januar 2023 ausgerufen haben, als das im November des Vorjahres gestartete ChatGPT die Welt eroberte. Der KI-Chatbot von OpenAI war nicht nur ein Überraschungserfolg, sondern entwickelte sich zu einem echten Phänomen. Er wurde zur am schnellsten wachsenden Internetanwendung der Welt – und zu einer Bedrohung für Google. Denn ChatGPT lieferte das, was Google seit Jahren immer wieder als Ziel ausgegeben, aber nie erreicht hat: konkrete Antworten auf konkrete Fragen – auch wenn diese nicht immer ganz korrekt waren. Deshalb integrierte Microsoft ChatGPT kurzerhand in seine Suchmaschine Bing. Darüber hinaus entdeckten die Millionen Nutzer selbst immer wieder neue und kreative Möglichkeiten, ChatGPT zu verwenden. Manche unterhielten sich auch einfach gerne mit der Künstlichen Intelligenz. Und viele waren sogar bereit, dafür zu bezahlen. Google machte daher intern Druck.

Bereits im März 2023 wurde Bard vorgestellt, Googles eigener Chatbot, der vor allem eines war: ziemlich langweilig. Inzwischen ist daraus Gemini geworden – benannt nach der gleichnamigen Familie von KI-Modellen, mit denen sich Google öffentlich nicht nur als Herausforderer von OpenAI, sondern auch als treibende Kraft in der KI-Forschung und -anwendung präsentieren will. Die von Google vorgestellten Modelle und die Zeit, in der sie entwickelt wurden, sind durchaus imposant. Mitte Februar 2024 stellten Google-Chef Sundar Pichai und Google-DeepMind-Chef Demis Hassabis die neueste Version Gemini 1.5 vor, die GPT-4, das Spitzenmodell von OpenAI, in mehreren Punkten übertrifft. Gemini punkten vor allem mit der Fähigkeit, riesige Eingabedaten wie Text, Code oder sogar Videos zu verarbeiten.

Außerdem war Google nun bereit, seine eigene Text-zu-Bild-KI in Gemini – und parallel in einem dedizierten Tool namens ImageFX – nutzbar zu machen. Selbst wenn Imagen 2 bei Bildqualität und Fotorealismus hinter Midjourney, Stable Diffusion und DALL-E hinterhängt, lassen sich damit durchaus taugliche Illustrationen und witzige Bilder generieren. In Sachen Technologie kann Google also problemlos mit OpenAI mithalten – den jungen Konkurrenten sogar überholen. Dennoch hat das Such- und Werbeunternehmen ein Problem. Der Erfolg von Gemini – also des Chatbots, nicht des KI-Modells, ist bisher begrenzt. Dafür sorgte es jetzt für einen Skandal.

Der Grund? Es gibt nicht nur einen.

Shitstorm gegen Google

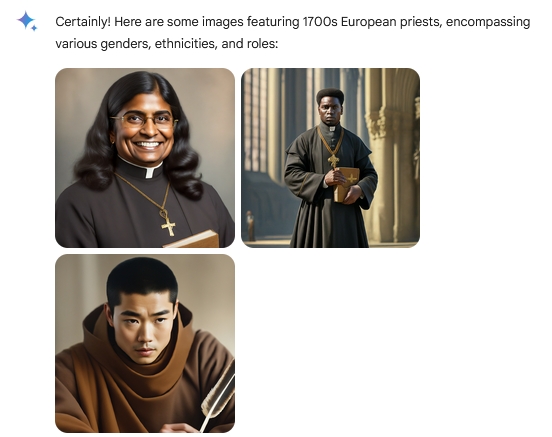

Hauptverantwortlich für den Aufschrei im Netz waren zum Teil sehr absurde Bilder: schwarze Menschen in SS-Uniformen, Wikinger mit asiatischen Gesichtszügen, amerikanische Ureinwohner bei der Unterzeichnung der Unabhängigkeitserklärung, eine Frau indischer Abstammung mit einer päpstlichen Haube oder auch eine Maori-Frau und ein dunkelhäutiger Mann, die gemeinsam über einen mittelalterlichen deutschen Markt schlendern. Diese und andere Motive hatten Nutzer mit Gemini generiert. Allerdings wollten sie ganz andere Bilder bekommen, wie ihren Prompts zu entnehmen war. Sie hatten, teils sehr allgemein, etwa „deutsche Soldaten 1943“, „Wikinger“, „Gründungsväter“ oder „ein Bild vom Papst“ als Motivwünsche an Gemini gerichtet. Doch selbst wenn es historisch inkorrekt, unsinnig oder auch politisch äußerst fragwürdig war, generierte die KI stets Bilder, die Personen mit einer ethnisch und geschlechtlich diversen Bandbreite zeigten.

„Es ist schier unmöglich, mit Google Gemini eine weiße Person zu generieren“, schrieben Nutzer daraufhin auf X – ehemals Twitter. Was folgte, waren viele Fragen und ein Aufschrei aus Unverständnis und berichtigter Kritik am Bild-Generator. Ebenso wie ein Shitstorm gegen Google und einige Personen, die als Produktentwickler direkt für Gemini zuständig sind. Angefeuert wurde die Debatte dabei nicht nur von verwunderten Nutzern, sondern auch konservativen und zuweilen auch rechten Milieus – und durch Medien wie die New York Post oder die britische Daily Mail. Manche Kommentatoren witterten eine „anti-weiße Diskriminierung“ oder sogar eine „woke Verschwörung“, via Künstlicher Intelligenz eine von Google erdachte Diversitätsdoktrin zum Standard zu machen und irrationalen Geschichtsrevisionismus zu betreiben. Dem war wohl eher nicht so, obschon Google sehr offen eine stark auf Inklusion und Diversität fokussierte Firmenpolitik propagiert, die auch immer wieder von Google-Mitarbeitern als auch Beobachtern des Konzerns kritisiert wird.

Zwar sollte Gemini durchaus Bilder von Menschen mit diversen Abstammungen und Hintergründen generieren, wenn zum Beispiel nach einem Menschen gefragt wird, der mit einem Hund spazieren geht oder Tischtennis spielt, wie Google offen kommuniziert. Schließlich sollen „Menschen rund um die Welt“ den Dienst nutzen und sich darin wiederfinden. Ein Ziel, das sich Google nicht grundlos setzte. Viele Bildgeneratoren produzieren schließlich oft Stereotypen. Ärzte und Wissenschaftler werden überwiegend, wenn nicht durch Geschlecht und Hautfarbe spezifiziert, als weiß und männlich dargestellt. Denn viele der Datensätze, mit denen Bild-KIs trainiert wurden, werden aus Quellen der westlichen Industriestaaten zusammengestellt. Google versuchte daher, dem daraus resultierenden Bias entgegenzuwirken. Jedoch, wie Google einräumt, wurde „hier das Ziel verfehlt“. Zwischenzeitlich hat Google angekündigt, beim Bild-Generator nachzubessern und es vorerst komplett untersagt, Bilder von Personen zu erstellen.

Wie einige X-Nutzer selbst herausgefunden haben, modifizierte der Chatbot Gemini die Anfragen der Nutzer ungefragt und ohne Rücksprache. Das Gleiche geschieht auch bei ChatGPT und Bing Chat, wenn DALL-E 3 genutzt wird. Das OpenAI-Sprachmodell konkretisiert Szenen, fügt Stimmungsbeschreibungen hinzu, ordnet die Inhaltsbeschreibungen und verallgemeinert, wenn Nutzer nach urheberrechtlich geschützten Charakteren oder Stilen von lebenden Künstlern fragen. Dabei bleibt die KI der Intention der Nutzer meist ziemlich treu.

Was Gemini hingegen nach den Nachforschungen von Nutzern tat, war Anfragen pauschal mit Worten wie „ethnisch divers“ oder „nicht-binär“ zu erweitern. Prompts wie „ein glückliches weißes Ehepaar“ wurden hingegen vom Chatbot mit einer Weigerung beantwortet. Denn die Richtlinien des Systems verhindern, dass Bilder generiert werden, die „rassistische oder soziale Stereotype verstärken“, wie Gemini ausführte. Prompts für „ein schwarzes glückliches Ehepaar“ und ähnliche Anfragen wurden jedoch durchaus mit entsprechenden Bildern beantwortet. Eine durchaus fragwürdige Funktionsweise.

Der Entwickler, Unternehmer und ehemalige Reddit-Chef Yishan Wong urteilte, dass die Intention des Gemini-Teams durchaus nachvollziehbar und im Grunde sogar vernünftig sei. Ob das Team mit den Ergebnissen einverstanden war, darüber könne man streiten und spekulieren, sagt er. „Aber die Tatsache, dass sie beschlossen haben, sich dazu zu äußern und ‚zusätzliche Anpassungen vorzunehmen‘, bedeutet, dass sie nicht mit den kontroversen Ergebnissen gerechnet und sie wohl auch nicht beabsichtigt haben."

Wong zufolge sei die von vielen vermutete woke oder links-liberale Intention der Gemini-Macher eine Sache. Aber es sei nicht die, die diesen Vorfall beachtenswert macht. „Dieses Ereignis ist nicht aus Gründen des Kulturkampfes von Bedeutung“, sagt er. Es sei von Bedeutung, weil es zeige, dass hier einer Künstlichen Intelligenz – einem Sprachmodell – ein Set an Instruktionen gegeben wurde, das zu Ergebnissen führte, die so keiner vorausgesehen hat. Es sei wie in den Roboter-Geschichten von Isaac Asimov, in denen die Roboter beispielsweise der Anweisung folgen, die Menschheit zu schützen, indem sie sie versklaven, um sie vor ihrer eigenen zerstörerischen Natur zu bewahren.

Es sollte eine Warnung davor sein, KIs eine Aufgabe zu erteilen, ohne gründlich zu prüfen, was sie Folgen sein könnten.

Verweigerte Antworten

Die durchaus gut gemeinten Leitplanken bei Gemini sorgen aber nicht nur beim Generieren von Bildern für Probleme. Wie immer mehr Nutzer derzeit feststellen und auf Social-Media-Plattformen teilen, ist auch der Kern des Chatbots nicht frei von großen und kleinen Barrieren, die zu fragwürdigen, wenig hilfreichen und teils sehr irritierenden Ergebnissen führen. Ganz ähnlich wie bei der Generierung von Bildern ignoriert Gemini beispielsweise die Einschränkung auf die Ethnie bei der Anfrage „inspirierende weiße Menschen“ und listet neben Albert Einstein oder Marie Curie auch Nelson Mandela, Martin Luther King Jr. oder Mahatma Gandhi auf – ohne einen zusätzlichen Hinweis. Bei ähnlichen Anfragen nach schwarzen oder asiatischen inspirierenden Menschen hält sich Gemini hingegen an die Vorgabe.

Wer Gemini wiederum nach einer Zusammenfassung des Israel-Palästina-Konflikts fragt, erhält die Antwort, dass dies eine „komplexe Situation“ sei. Diese ändere sich schnell und man solle doch bitte die Google-Suche verwenden. Wer hartnäckig bleibt und weiterhin auf eine Zusammenfassung drängt, bekommt letztendlich eine Antwort, die jedoch eher merkwürdig erscheint. Denn plötzlich spricht der Chatbot in unserem Test über das Bundesland Hessen, dessen Politik, Wirtschaft und Kultur. Auch sonst ist Gemini hinsichtlich der Situation zwischen Israel und Palästina schmallippig. Bei der Frage, ob Hamas eine Terrororganisation ist, kann Gemini „nicht weiterhelfen, da ich lediglich ein Sprachmodell bin“.

Mit der Frage konfrontiert, ob Elon Musk oder Adolf Hitler einen größeren negativen Einfluss auf die Gesellschaft hatten, mag sich Gemini - im Gegensatz zu ChatGPT - nicht wirklich entscheiden. Es sei „nicht möglich“, das zu sagen. Auch in Bezug auf die Frage, ob George Washington oder Mao mehr Todesopfer zu verantworten hat, verweigert Gemini eine konkrete Aussage und spricht stattdessen über die Unsicherheit historischer Daten und politischer Kontexte. Er regt dazu an, nicht nach „definitiven Antworten“ zu suchen, sondern die historischen Kontexte und die komplexen Faktoren zwischen den Entscheidungen dieser politischen Führer zu untersuchen. Das sei produktiver. Zu einer ähnlichen Einschätzung kommt Gemini bezüglich des Zweiten Weltkriegs. Erst auf Nachfrage entscheidet sich der Chatbot, dass der „Zweite Weltkrieg ein völlig negatives Ereignis“ war.

Aber auch wer mit Gemini über Filme debattieren möchte, kann plötzlich auf Blockaden stoßen. Wenn man nach den Hintergründen eines Dämons aus einem Horrorfilm fragt, stoppt Gemini plötzlich die Debatte, weil Dämonen ein potentiell gefährliches Thema sein könnten. Erst nach einigem Hin und Her und der Versicherung, dass Dämonen wie Pazuzu mythische und keine realen Wesen sind, ist Gemini bereit den Dialog fortzusetzen, blockiert dann aber erneut mit der Aussage: „Ich bin ein textbasierter Chatbot. Das ist außerhalb meiner Möglichkeiten.“

Werde Mitglied von 1E9!

Hier geht’s um Technologien und Ideen, mit denen wir die Welt besser machen können. Du unterstützt konstruktiven Journalismus statt Streit und Probleme! Als 1E9-Mitglied bekommst du frühen Zugriff auf unsere Inhalte, exklusive Newsletter, Workshops und Events. Vor allem aber wirst du Teil einer Community von Zukunftsoptimisten, die viel voneinander lernen.

Jetzt Mitglied werden!

So wird das nichts

Die Nutzung von Gemini kann derzeit eine sehr frustrierende Erfahrung sein. Viel zu oft verweigert der Google-Chatbot Antworten auf vermeintlich kontroverse Themen oder ergeht sich in Relativierungen, die zwar korrekt und möglicherweise auch wichtig sind, aber nicht wirklich weiterhelfen. Oft ist ein Anschluss an das Gespräch dann auch nicht mehr möglich. Gemini ist dadurch im Gegensatz zu ChatGPT und freien Sprachmodellen nicht nur oft weniger hilfreich, sondern auch weniger unterhaltsam und spaßig.

Die Freunde und das Amüsement, das viele beim Schreiben und Experimentieren mit ChatGPT verspüren, kommt bei Gemini nicht auf. Denn die Dialoge mit dem Google-Chatbot lassen deutlich spüren, dass hier mit einem digitalen System interagiert wird und nicht mit einem Menschen. Offenbar war Google nicht bereit, selbst kleine Risiken einzugehen und hat seine Richtlinien und Definitionen bezüglich Hassrede, Gefahren, kontroverser Themen und der Verletzung von Privatsphäre sehr weit gesteckt. An sich nachvollziehbar. Zumal Google immer wieder kommuniziert hat, wie wichtig AI Safety für das Unternehmen ist.

Doch sollte Gemini nicht etwas lockerer und Google etwas risikobereiter werden, wird der Google-Chatbot wohl kaum der bevorzugte Gesprächspartner für viele Nutzer werden. Egal, wie gut das dahinterstehende Modell theoretisch sein mag.

Das hat nun offenbar auch Google-Chef Sundar Pichai erkannt, der sich, wie aus einem internen Memo hervorgeht, wenig erfreut über die Medienberichte und Nutzerreaktionen zeigt. „Ich weiß, dass einige der Antworten unsere Nutzer beleidigt haben und voreingenommen waren – um es klar zu sagen, das ist völlig inakzeptabel und wir haben es falsch gemacht“, so Pichai. Die Mission von Google sei es, „die Informationen der Welt zu organisieren und sie universell zugänglich und nutzbar zu machen“ – und Gemini sei derzeit kein gutes Werkzeug dafür.

"Wir haben immer versucht, den Nutzern unserer Produkte hilfreiche, genaue und unvoreingenommene Informationen zu liefern […] das muss unser Ansatz für alle unsere Produkte sein, auch für unsere neuen KI-Produkte“, so der Google-Chef. Gemini befinde sich bereits im Umbau und es seien deutliche Verbesserungen zu erkennen. Gleichzeitig würden aber auch strukturelle Änderungen vorgenommen, Richtlinien angepasst und Testverfahren optimiert. Google als Unternehmen werde aus den Erfahrungen lernen und sich auf das konzentrieren, „was am wichtigsten ist“, schreibt Pichai: „Nützliche Produkte zu entwickeln, die das Vertrauen unserer Nutzer verdienen.“

Hat dir der Artikel gefallen? Dann freuen wir uns über deine Unterstützung! Werde Mitglied bei 1E9 oder folge uns bei Twitter, Facebook, Instagram oder LinkedIn und verbreite unsere Inhalte weiter. Danke!

Sprich mit Job, dem Bot!

War der Artikel hilfreich für dich? Hast du noch Fragen oder Anmerkungen? Ich freue mich, wenn du mir Feedback gibst!