In sozialen Netzwerke tauchen immer öfter Bilder und Videos auf, die Fragen aufwerfen: Sind sie echt, bearbeitet oder sogar vollkommen künstlich erstellt worden? Habe ich es mit einem Deepfake zu tun? Ein neues Tool der University at Buffalo soll Fälschungen entlarven können – und das mit einer sehr hohen Trefferrate.

Von Adriano D’Adamo

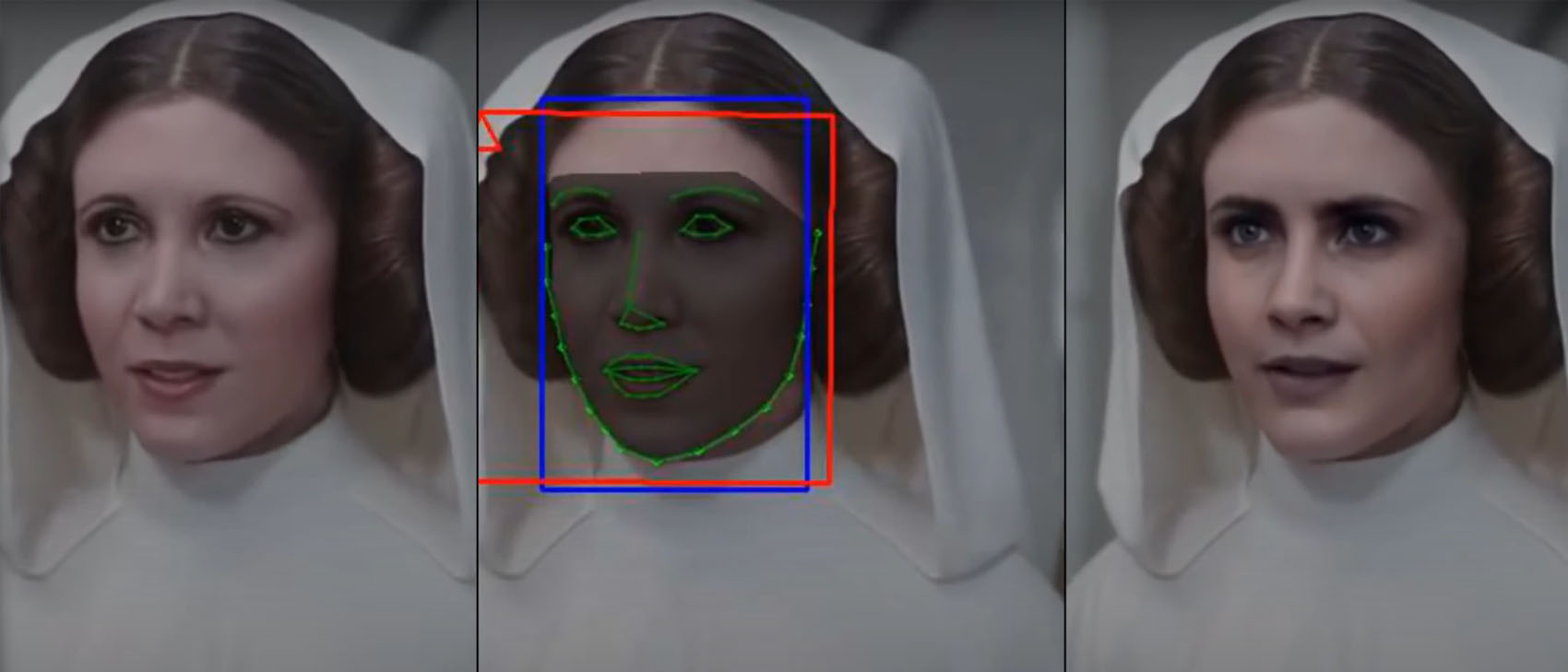

Für das perfekte Selfie einen Filter zu benutzen, ist nicht ungewöhnlich. Und oft auch kaum zu übersehen. Dennoch sind die Bilder weiterhin echt, wenn auch bearbeitet. Wir wissen, dass die Person auf dem Bild mehr oder weniger so aussieht. Doch inzwischen wird die Sache immer komplizierter. Webseiten wie This Person Doesn’t Exist liefern zufällig generierte und realistische Bilder von Menschen, die gar nicht existieren. Ebenso generieren Deepfake-Künstler Videos von Schauspielerin in Rollen für die sie nie besitzt wurden. Erst kürzlich sorgten Videos von einem falschen Tom Cruise für Furore. Solche KI-generierten Medien sind also keine Seltenheit mehr. Um diese zu erkennen, hat die University at Buffalo nun ein Tool entwickelt – was in den meisten Fällen auch funktioniere.

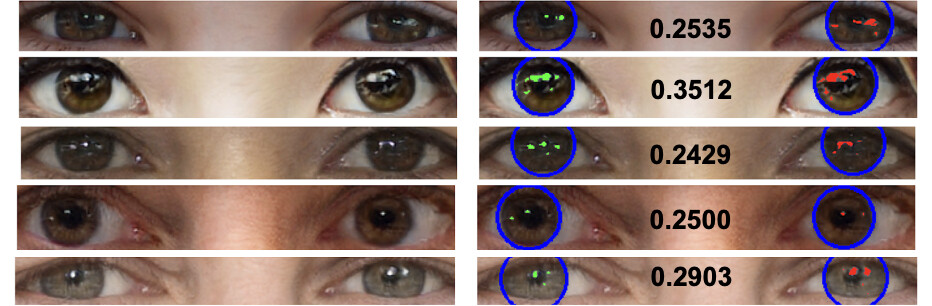

Das neue Tool kann mit einer Wahrscheinlichkeit von 94 Prozent Deepfake-Bilder erkennen – bislang leider nur Bilder und keine Videos. Mit Fotos von echten Personen und Bildern der oben genannten Website sowie mithilfe von Machine Learning trainierten der Computerwissenschaftler Siwei Lyu und sein Team den neuen Algorithmus. Der ausschlaggebende Punkt für die Erkennung, ob das Bild echt oder vom Computer generiert ist, sind die Augen. Laut Lyu ist die Cornea, also die Hornhaut, eine beinahe perfekte Halbkugel und sehr reflektierend. Deswegen spiegelt sie jedes Bild in den Augen wider, das diese zum Zeitpunkt der Aufnahme gesehen haben.

Der Unterschied zwischen echten und synthetisch erschaffenen Augen auf sogenannten Generative-Adversary-Network-Bildern oder GAN-Bildern. Bild: University at Buffalo

Das Tool analysiert die Augen und ob sich das selbe Bild in beiden Augen widerspiegelt. Diesen Aspekt lassen viele synthetische Bilder aus, weswegen sie meistens keine oder nur unregelmäßige Reflektion in den Augen der Personen darstellen. Das nutzt das Tool von Lyu aus und sucht nach Abweichungen in den Augen und den darin enthaltenen Reflektionen. Zuerst separiert es die Augen vom restlichen Bild, findet anschließend den Augapfel und fokussiert sich schlussendlich auf die Reflektion des Lichts in jedem Augapfel einzeln.

Noch nicht perfekt

Dennoch hat das Programm auch Schwächen. Damit es die Echtheit einer Aufnahme untersuchen kann, braucht es im Bild selber eine Lichtquelle – denn ohne Lichtquelle gibt es auch keine Reflektion. Falls die abgebildete Person keine zwei Augen hat oder eines davon verdeckt ist, kann die Analyse ebenfalls fehlschlagen. Beide Augen werden als Vergleichsobjekte genutzt. Für das Ergebnis sind Unterschiede ausschlaggebend, die es aber nicht geben kann, wenn es nur ein Auge gibt.

Verstehe, was die Zukunft bringt!

Als Mitglied von 1E9 bekommst Du unabhängigen, zukunftsgerichteten Tech-Journalismus, der für und mit einer Community aus Idealisten, Gründerinnen, Nerds, Wissenschaftlerinnen und Kreativen entsteht. Außerdem erhältst Du vollen Zugang zur 1E9-Community, exklusive Newsletter und kannst bei 1E9-Events dabei sein. Schon ab 2,50 Euro im Monat!

Jetzt Mitglied werden!

Siwei Lyu hat das Tool zusammen mit seinem Team von der University at Buffalo und der State University of New York entwickelt. In einem Paper, welches vom IEEE (Institute of of Electrical and Electronics Engineers) akzeptiert wurde, fassten sie ihre Ergebnisse zusammen. Lyu und seine Co-Autoren, Shu Hu und Yuezun Li, sollen dazu einen Vortrag auf der IEEE International Conference on Communications im Juni halten.

Hat dir der Artikel gefallen? Dann freuen wir uns über deine Unterstützung! Werde Mitglied bei 1E9 oder folge uns bei Twitter, Facebook oder LinkedIn und verbreite unsere Inhalte weiter. Danke!