Bei der Kalifornischen Asilomar Conference 2017 fand ein einzigartiges Panel zu ethischen Prinzipien in der Künstlichen Intellgienz statt. Absurd hochkarätige Experten wie Ray Kurzweil, Nick Bostrom, Elon Musk und Stuart Russel diskutierten darüber, wie man den ethischen Einsatz von KI fördern und den Missbrauch dieser immer mächtiger werdenden Technologie verhindern könne. Vermutlich war weder vorher noch nachher jemals so viel Kompetenz zu dieser Frage auf einer Bühne versammelt, aber eine Antwort fanden sie nicht. Stattdessen wurden neue Horrorszenarien ausgemalt: Stuart Russel warnte eindringlich vor den Bestrebungen zur Schaffung einer Superintelligenz. Für Ihn sei das, als würden wir eine Atombombe bauen, die wir zur freien Verfügung an die ganze Welt per Email verschicken.

Video: Superintelligence: Science or Fiction? | Elon Musk & Other Great Minds

Wahrscheinlich ist es noch weit hin bis zur Atombombe der Künstlichen Superintelligenz, aber wir scheinen aktuell – um bei der Nuklear-Metapher zu bleiben - den Manhattan-Project-Moment der KI zu erleben. Dieser Moment war damals wie heute gekennzeichnet durch eine massive Aufstockung der Forschungs- und Entwicklungsressourcen, die weitreichende Einbindung privater Industriepartner, sowie die großflächige Anwendung der Technologie auf die Gesellschaft. Bemerkenswert war, dass es überhaupt keinen gesellschaftlichen Wunsch danach gab. Es gab keine Demonstrationen, in denen das Volk mehr Nuklear-Technologie forderte und erst recht nicht den Bau von Atombomben– welche klar denkende Gesellschaft würde Billionen von Steuergeldern in Mordwaffen stecken? (Davon hätte man vermutlich die ganze Weltbevölkerung zum friedenssichernden Schüleraustausch von links nach rechts schicken können.) Die Nuklearwaffen waren in erster Linie politisch gewollt, um einen Vorteil gegenüber anderen Staaten zu erlangen. Zwar behauptete man Anfangs in Amerika, dass man die amerikanische Atombombe nur zum Schutz des Volkes vor der geplanten Atombombe der Deutschen bräuchte, aber selbst nachdem Deutschland 1942 sein Nuklearwaffenprogramm weitestgehend eingestellt hat, wurde die Entwicklung in den USA uneingeschränkt fortgesetzt.

Im Bereich Künstliche Intelligenz scheint dasselbe hetzerische Arms-Race-Narrativ genutzt zu werden und es klingt ungefähr so: USA und Europa müssen unbedingt Vollgas geben, um nicht von der KI-Macht China kolonialisiert zu werden – ein Narrativ, dem sich deutsche PolitikerInnen teilweise ebenfalls anzuschließen scheinen, wie @Wolfgang berichtet. Tatsächlich muss man aber weniger von konkurrierenden Staaten ausgehen, sondern eher von einer Industrie, die jeweils die Staaten zu ihrem Profit gegeineinander ausspielt. Wenn z.B. Angst damit geschürt wird, dass in China KI schon im Kindergarten gelehrt wird, muss man nur etwas weiter scrollen, um zu lesen, dass ein amerikanischer Konzern hierfür die Materialien bereitstellt. Was diese Konzerne da treiben ist ungefähr so, als würde ich Deinem Nachbarn eine Knarre verkaufen. Und dann würde ich zu dir kommen und sagen: „Du wirst es nicht glauben, aber Dein Nachbar hat sich bewaffnet um Dich zu killen. Doch weil ich dich so sehr liebe, verkaufe ich Dir auch eine Knarre um Dich zu schützen.“ Geschützt wird dadurch niemand, aber der Absatz steigt.

Auch bei der aktuellen KI-Penetration der Gesellschaft scheint es egal zu sein, wie KI überhaupt eingesetzt wird, Hauptsache sie wird viel eingesetzt. Oder wie ließe sich sonst die Entwicklung einer 220-$-Zahnbürsten mit KI erklären? Vielleicht werden uns diese Zahnbürsten irgendwann so absurd erscheinen wie die 1940 noch so fortschrittlich wirkende radioaktive Zahnpasta Doramand. Die Produktion dieser Thorium-haltigen Zahnpasta wurde erst mit dem Abwurf der Atombombe über Hiroshima eingestellt. Hoffentlich braucht es nicht erst einen Hiroshima-Moment der KI um zu merken, wenn wir es mit KI übertreiben.

Anzeige für die radioaktive Zahncreme Doramad. Bild: Wikipedia

Vor diesem Hintergrund scheint die Asilomar-Conference dann auch ein wenig heuchlerisch. Zwar hat sie dem Thema KI-Ethik einen Boost gegeben und hat zu wegweisenden Publikationen geführt wie eben den Asilmar-Prinzipien und vor allem Paula Boddingtons Buch „Towards a Code of Ethics for Artificial Intelligence“. Aber auf der anderen Seite, muss man sich noch einmal vor Augen führen, was da passiert war: da saßen ein paar der krassesten KI-Experten der Welt und debattieren darüber, wie man die böse Superintelligenz vermeiden könnte, während genau sie es sind, die diese erschaffen wollen. Passend dazu wurde kürzlich bei Reddit die Frage aufgeworfen “Who should stop unethical AI?” Der meistbeachtete Kommentar lautet bisher: “Right now absolutely no one stops unethical human CEOs, billionaires, and politicians. :-(“

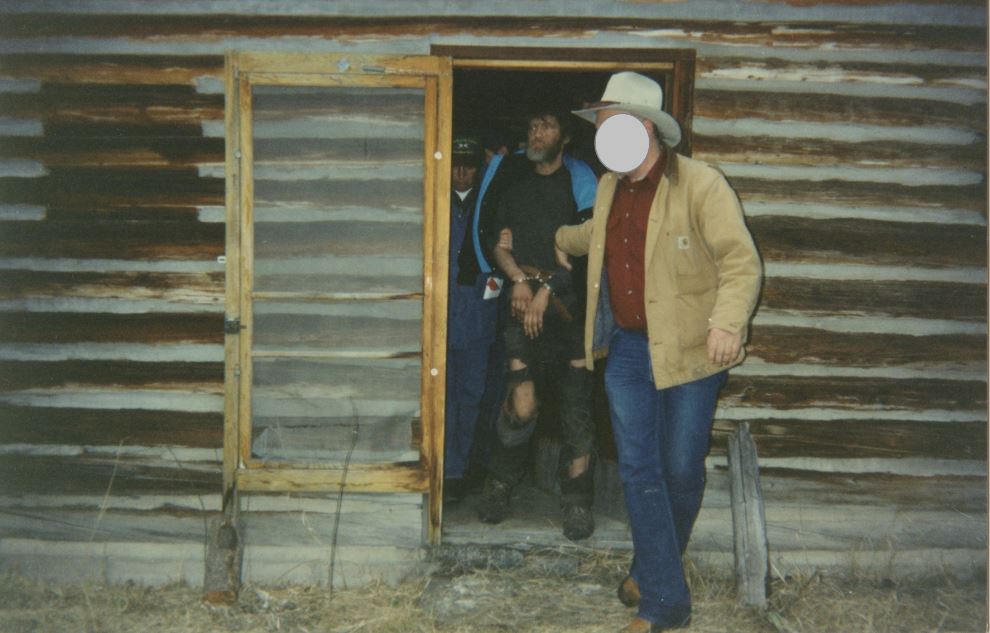

Welchen Ausweg gibt es aus diesem Teufelskreis? Der 160-IQ-Punkte Mathematik-Professor Ted Kaczynski formulierte in seinem „UNA Bomber Manifest“ eine klare aber geisteskranke Antwort auf übermächtige Tech-CEOs: alle killen, mit samt ihrer Technologie. Rein mathematisch betrachtet macht das Sinn. Laut Mengenlehre schließt die Vernichtung sämtlicher Technologie natürlich auch die Vernichtung gesellschaftschädlicher Technologie ein - aber zu welchem Preis? Wir können ja aus Angst vor dem Missbrauch von KI nicht in die Steinzeit flüchten. Unser technologischer Fortschritt hat uns unermessliche Sicherheit, Gesundheit und Komfort gebracht.

„UNA Bomber“ Ted Kaczynski bei der Festnahme in seiner technologie-freien Holzhütte. Bild: Wikipedia

Es muss uns irgendwie gelingen, dem Dual-Use-Dilemma zu entkommen, wonach jede noch so gute Technologie irgendwann doch für böse Zwecke missbraucht werden kann. Und vielleicht versteckt sich ja doch die Lösung aller ethischen KI-Probleme in einer etwas hilflos wirkenden Aussage von Stuart Russel auf besagtem Panel in Bezug auf den Missbrauch von Superintelligenz: „We have to somehow make it unthinkable“. Was man hier hinein interpretieren kann, ist dass die Lösung nicht in besonders raffinierten technischen Vorkehrungen besteht, sondern der ethischen Einstellung jedeR einzelnen. Wir müssen den inneren Kompass wieder aktivieren, der jedem gesunden Menschen klarmacht, dass man über die Konsequenzen seines Handelns gründlich nachdenken muss. Und wenn man dann zu dem Schluss kommt, dass die Konsequenzen zu gefährlich oder auch nur zu unabsehbar sind, dann muss es einfach selbstverständlich sein, dass man den mahnenden Worten des deutschen KI-Pioniers Joseph Weizenbaum folgt: niemand wird zur Entwicklung einer bestimmten KI-Anwendung gezwungen, in manchen Fällen darf man es auch einfach lassen.