Von Wolfgang Kerler

Wer den Mund zu einem Lächeln formt, ist glücklich. Wer die Augen finster zusammenkneift, ist wütend. Und wer Augen und Mund aufreißt, ist überrascht. So einfach ist das, oder? Leider nicht. Vom Gesichtsausdruck eines Menschen auf seine Emotionen zu schließen, kann oft schief gehen. Zu diesem Schluss kam im Juli 2019 ein Team von Wissenschaftlern, nachdem es mehr als 1.000 Studien über den Zusammenhang von Mimik und Gefühlslage begutachtet hatte.

Zwar komme es vor, dass glückliche Menschen lächeln oder wütende Menschen grimmig schauen, heißt es im Bericht der amerikanischen Psychologie-Professorin Lisa Feldman Barrett und ihrer Kollegen. „Doch wie Menschen Wut, Ekel, Angst, Glück, Traurigkeit und Überraschung ausdrücken, variiert stark zwischen den Kulturen, Situationen und sogar zwischen Menschen innerhalb ein und derselben Situation.“

Lisa Feldman Barrett zweifelt deshalb an den Versprechen diverser Technologiefirmen, die behaupten, ihre Software könne per Gesichtserkennung Aussagen über die Emotionen von Menschen machen. „Sie können einen finsteren Blick erkennen“, sagte sie zu The Verge . „Aber das ist nicht dasselbe wie Wut zu erkennen.“ Dennoch bieten Unternehmen von Google bis Amazon ihre Bilderkennungs-Software auch zur Emotion Recognition an – bei Microsoft könnt ihr die Fähigkeiten der KI sogar selbst testen.

Bittet man Probanden, die Mimik auf Fotografien einem Set von Emotionen zuzuordnen, können die Antworten erheblich voneinander abweichen. Bild: Barrett et al.

Bittet man Probanden, die Mimik auf Fotografien einem Set von Emotionen zuzuordnen, können die Antworten erheblich voneinander abweichen. Bild: Barrett et al.

Die Stimme verrät wirklich etwas über die Stimmung

Wer jedoch wirklich etwas über die Gefühlslage eines Menschen erfahren will, sollte die Augen schließen und ihm einfach nur zuhören. Denn unsere Stimme verrät am meisten darüber, wie es uns geht. Das fand Michael Kraus von der Universität Yale durch eine Studie mit fast 1.800 Testpersonen heraus. Daraus folgt: Wer Maschinen beibringen will, die Gefühle von Menschen zu erkennen, sollte sie weniger mit Bildern und mehr mit Tonaufnahmen trainieren.

Genau das macht audEERING, eine 2012 gegründete Firma mit Sitz in Gilching bei München, die inzwischen 61 Mitarbeiter hat. „Wir analysieren das akustische Signal in seiner kompletten Bandbreite“, sagt Dagmar Schuller, die Geschäftsführerin und Mitgründerin, im Gespräch mit 1E9. „Wir analysieren also nicht nur, ob ein Mensch spricht, sondern auch wie er spricht und den gesamten Kontext, den ein Audiosignal liefert.“

Durch maschinelles Lernen hat audEERING eine KI entwickelt, die innerhalb von Sekunden erkennen kann, dass sie gerade einen wütenden Mann in einem vollen Restaurant gehört hat. Oder dass sie es mit einer verschnupften Frau in einem leisen Büro zu tun hat – denn, klar, eine Erkältung zu hören, ist für sie kein Problem. Oder dass sie Zeugin eines hitzigen, fast schon wütenden Meetings mit sieben Teilnehmern wird – und einem wenig empathischen Chef. Die Frage ist: Was bringt das?

Dagmar Schuller und ihr Team entwickeln Lösungen für viele verschiedene Anwendungen. Eine davon: persönliche Sprachassistenten, die durch Emotionserkennung passendere Informationen liefern können. „Wenn Sie das Wetter wissen wollen, ist das die eine Sache“, sagt die Firmenchefin. „Aber wenn Sie zum Beispiel sagen: Assistent XY, schlag mir doch mal ein paar Lieder vor, dann ist es interessant zu wissen, in welcher Stimmung Sie gerade sind.“ Merkt der Assistent, dass sein Nutzer schlecht drauf ist, kann er Musik auswählen, die seine Stimmung verbessert. Ist der Nutzer erkältet, kann ihm der Assistent Empfehlungen geben. Auch Amazon möchte das seinem Assistenten Alexa beibringen – und arbeitet an Emotionserkennung per Stimme.

Die audEERING-Technologie ist bereits im Einsatz, auch in Call Centern. „Da haben Sie Personen sitzen, die täglich damit konfrontiert werden, dass Leute anrufen, die – sagen wir mal – nicht im optimalen Zustand sind“, sagt Dagmar Schuller – und meint: Oft rufen Kunden an, die frustriert sind, weil der Flug gecancelt wurde, eine falsche Bestellung geliefert wurde oder irgendein Produkt nicht funktioniert.

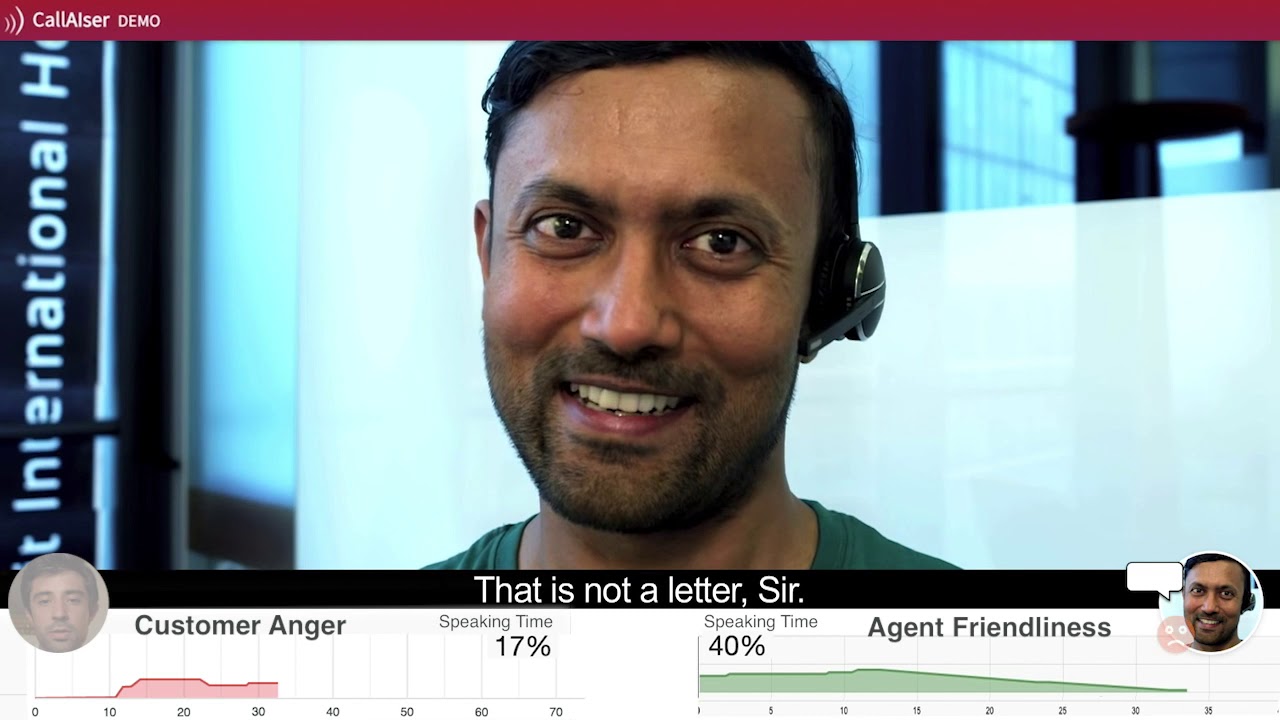

Mit diesem Video erklärt audEERING wie seine Lösung für Call Center funktioniert.

Das audEERING-Tool gibt den Mitarbeitern der Call Center nun eine Hilfestellung: An einer Linie können sie ablesen, wie verärgert der Kunde ist – und es als persönlichen Erfolg verbuchen, wenn sie den Anrufer aus dem roten Bereich in den gelben oder grünen bringen. „Wenn sich ein Gespräch aber extrem kritisch entwickelt, hat der Agent die Möglichkeit, es an den Supervisor abzugeben“, sagt Dagmar Schuller. „Dadurch wird der Agent entlastet.“

Auch Spaß machen kann die Emotionserkennung, zum Beispiel wenn sie in Videospielen zum Einsatz kommt. Plötzlich könnte es eine Rolle spiele, wie man mit virtuellen Charakteren spricht – dominant, freundlich, ängstlich. Oder ob man in einer Kampfsituation nervös klingt. Oder ob man Zaubersprüche energisch genug spricht. Um nach Ideen zu suchen, hat audEERING bereits zu einer Game Challenge aufgerufen.

Fast schon gewöhnlich wirkt dagegen ein anderes Einsatzfeld: das in Kopfhörern mit aktiver Geräuschunterdrückung. Auch in solchen wird die audEERING-Software bereits verwendet – und filtert die Baustelle nebenan oder den Fluglärm heraus.

Die KI soll Krankheiten wie Parkinson oder Alzheimer hören

Die umfassende Audioanalyse erlaubt aber noch weit mehr. Selbst Krankheiten, die über einen Schnupfen hinausgehen, soll sie erkennen. Schon jetzt kann die KI des bayerischen Unternehmens zwischen Menschen mit und ohne Parkinson-Erkrankung sehr gut unterscheiden. „Wir haben dafür eine Anwendung entwickelt, bei der Sie in 15 Sekunden klassische Wörter mit Vokalen, die Ihnen auch ein Neurologe für einen Teil seiner Diagnose vorgeben würde, sagen müssen“, erklärt Dagmar Schuller.

Die nächste Herausforderung sei es, mithilfe der Software eine Parkinson-Erkrankung schon dann zu erkennen, wenn Betroffene oder Mitmenschen noch gar nichts bemerken. „Wenn Sie sich artikulieren, spielen dafür ganz unterschiedliche Muskelgruppen zusammen: Stimmbänder, Kehlkopf, Zunge, Gesichtsmuskulatur oder Brustmuskulatur. Das heißt, an Diskontinuitäten im Audiosignal kann mein einen Befall der Artikulationsmuskulatur schon feststellen, wenn noch keinerlei Zittern erkennbar ist.“ Auch bei der Therapie und Früherkennung von Alzheimer könnte die Technologie helfen – etwa, indem sie scheinbar grundlose Emotionsausbrüche registriert.

Besonders stolz is Dagmar Schuller auf ein Forschungsprojekt mit Partnern wie dem Fraunhofer IS. Das Ziel: Die audEERING-Software soll Kindern mit Autismus helfen, die große Schwierigkeiten damit haben, die Emotionen anderer Menschen zu erkennen und ihre eigenen Emotionen auszudrücken. „Man muss sich das wie das Lernen einer Fremdsprache vorstellen“, sagt die Gründerin. „Das autistische Kind bekommt beigebracht: so klingt Ärger. Und wenn es sich selber ausdrückt, bekommt es als Feedback zurück: Ja, du hast Ärger gut ausgedrückt. Oder: Nein, so würde man das nicht erkennen.“

Kann jedes Smartphone zum Lügendetektor werden?

Bei all den neuen Möglichkeiten, die Künstliche Intelligenz bei der Audioanalyse eröffnet, gibt es natürlich auch neue Risiken. Wie wird mit den persönlichen, teils intimen Daten umgegangen, die von Geräten gesammelt und verarbeitet werden? Wie kann verhindert werden, dass Menschen ohne ihr Wissen „emotional abgehört“ werden? Und könnte in Zukunft jedes Smartphone zum privaten Lügendetektor umgebaut werden, was überall Misstrauen sät?

„Natürlich kann man nie hundertprozentig sagen, dass eine Technologie nicht auch missbräuchlich genutzt wird“, sagt Dagmar Schuller. Doch die Software ihrer Firma sei in Bezug auf komplexere Analysen vor allem darauf ausgerichtet, auf individuelle Nutzer kalibriert zu werden, die sich aktiv dafür entscheiden, damit zu arbeiten – und sie jederzeit ausschalten können. Je länger jemand mit der KI arbeite, umso besser könne sie den Nutzer einschätzen.

„Ist die Maschine nicht auf Sie kalibriert, haben wir bei der Emotionserkennung technisch derzeit das menschliche Level. Das heißt, die Rate, mit der wir Emotionen erkennen, liegt zwischen 70 und 80 Prozent“, erklärt Dagmar Schuller. „Das schaffen Menschen auch selbst.“ Und auch sonst könnten die Algorithmen immer nur mit Wahrscheinlichkeiten arbeiten. „Sie können also nicht sagen, ob Sie lügen oder nicht, sondern nur mit einer bestimmten Wahrscheinlichkeit erkennen, ob Sie die Wahrheit sagen.“ Anders als bei großen Tech-Anbietern werden die Audiodaten bei den audEERING-Produkten in der Regel in Echtzeit auf dem Gerät analysiert. Sie gehen also nicht in eine Cloud und werden auch nicht gespeichert.

Vielleicht könnte gerade dieser letzte Aspekt ein Wettbewerbsvorteil der KI aus Deutschland sein. Denn es ist wohl davon auszugehen, dass Alexa, Siri & Co. – wenn sie denn standardmäßig Emotionen hören kennen – ihre Daten weiterhin an ihre Mutterkonzerne abgeben. Und die können ihre Nutzerprofile dann um einen weiteren Baustein ergänzen…

Titelbild: Tara Moore / Getty Images

, du meinst es aus den verschiedenen Warten/ Denkrichtungen heraus betrachten, oder?

, du meinst es aus den verschiedenen Warten/ Denkrichtungen heraus betrachten, oder?