Von Eric Eitel und Dr. Julia Schneider

KI und Musik: Der Stand der Dinge

Wie auch in anderen Bereichen, vor allem in der industriellen Produktion und den datenbasierten Dienstleistungen, ist der Diskurs um KI-generierte Musik derzeit vor allem von Angst geprägt: Angst davor, dass der Faktor Mensch von der Maschine aus der Musikproduktion verdrängt werden könnte. Aber auch subtilere Ängste, bei denen es nicht vorrangig um mögliche ökonomische Nachteile von Musikschaffenden geht, werden immer häufiger geäußert: Welche Legitimation habe ich als Musikerin oder Musiker eigentlich noch, wenn ein KI-System bessere oder erfolgreichere Songs produziert, als ich es selbst kann?

No Dark Future, sondern vielmehr Realität

Vorab: Einige der ökonomisch begründeten Ängste sind sicherlich nicht von der Hand zu weisen. Insbesondere Funktionsmusik, damit meinen wir nicht nur die oft kolportierte „Fahrstuhlmusik“, sondern Musik für Film, TV und Games (auch Sync-Musik genannt), aber auch generische Unterhaltungs-Musik, könnten zukünftig größtenteils von KI-Systemen produziert werden. Eine Fußnote wäre in diesem Zusammenhang,dass Warner Music kürzlich das KI-Musik-Startup Endel gekauft hat, um von der KI komponierte Produktionen zu veröffentlichen.

Die technischen Vorrausetzungen dafür sind jedenfalls gegeben. Wer beispielsweise auf der Suche nach Hintergrundmusik für ein Video ist, konnte bis vor Kurzem auf Jukedeck eine Stimmung und eine Länge eingeben – beispielsweise „Pop“, „Melancholisch“ und „15 Sekunden“ – und die KI lieferte in wenigen Augenblicken den passenden, selbstkomponierten lizenzfreien Song. Kein Ärger mehr mit dem Urheberrecht - und das für gerade mal für ein paar Cent! Das interessierte auch ByteDance, den chinesischen Entwickler der bei Teenagern hoch angesagten Videoplattform TikTok, der Jukedeck folgerichtig vorigen Monat aufkaufte. Der Dienst ist derzeit offline; Alternativen wie amper oder Amadeus Code bieten nahezu identische Dienste für ähnlich kleines Geld. Daher könnte, im Umkehrschluss, das bestehende Urheberrecht ein wichtiger Promoter für die Entwicklung von künstlich erzeugter Musik werden.

Ein anderes Anwendungsgebiet für KI-Musikmaschinen ist die Produktion von „adaptiver Musik“. Man stelle sich ein Computerspiel vor, mit einem musikalischen Grundthema und vielen Variationen. Mit Systemen von Anbietern wie Melodrive können „immersive“ Soundtracks, beispielsweise auch für VR- oder AR-Anwendungen, mit geringem Aufwand produziert werden. Immersiv meint in diesem Zusammenhang, dass Nutzer einer virtuellen Umgebung direkt mit dieser interagieren können. Um dies auf der Sound-Ebene darstellen zu können, erzeugt die KI kontextuell passende Kompositionen und spielt diese in Echtzeit aus. Auch dieses System ist kostenseitig mindestens konkurrenzfähig gegenüber menschlicher Produktionsarbeit – und wer will überhaupt hunderte oder tausende Variationen „händisch“ komponieren?

Von Sounds zu Songs

Komplexere KI-Systeme, wie beispielsweise Flow Machines von Sony CSL Research Laboratory, können bereits aufwendigere Kompositionen vornehmen – hier würden wir tatsächlich von KI-komponierten Songs sprechen. Dass dies möglich ist, wurde 2017 medienwirksam mit dem vermeintlich ersten KI-komponierten Pop-Song Daddy´s Car, der an die Beatles und Oasis erinnert, erfolgreich unter Beweis gestellt. Im letzten Jahr folgte, basierend auf derselben Technologie-Platform, Hello World von Skygge aka Benoit Carré, das wohl erste KI-produzierte Pop-Album der Musikgeschichte.

Auch Yuval Harari beschreibt in seinem Buch Homo Deus einen Wettkampf zwischen Mensch und KI, den es tatsächlich gegeben hat. Die (menschliche) Jury war in seinem Beispiel nicht in der Lage zu entscheiden, welches Musikstück von einer KI oder einem Menschen stammte. Tatsächlich wurden die KI-generierte Musikstücke von den Zuhörerenden sogar als kreativer bewertet als die menschgemachte Komposition.

An diesem Punkt ist es sinnvoll, einige Begrifflichkeiten genauer zu definieren, deshalb ein paar Worte zu der Technologie, die hinter KI-Systemen wie Flow Machines wirkt.

Machine Learning, Neuronale Netze und KI

Denn was genau ist ein KI-System? Ist das wirklich etwas Neues? KI gibt es schon seit den 1950er Jahren. Wir erinnern uns an das erste Schachspiel, das 1951 bereits von einem Computer gewonnen wurde. Tatsächlich wurde der Begriff „Künstliche Intelligenz“ vor mehr als 60 Jahren erfunden, 1956 von John McCarthy, als zugkräftiger Titel für eine Konferenz zu den Anfängen dieser Technologie. Und wenn wir noch weiter zurückgehen in der menschlichen Geschichte, dann finden wir viele Versuche, intelligente Wesen zu erschaffen, bereits bei Leonardo Da Vinci, der sogar einen Roboterritter bauen wollte, in der jüdischen Mythologie mit der Geschichte des Golems oder in Mary Shelley’s Frankenstein.

Wenn die Geschichte der KI soweit zurückgeht, warum ist sie dann gerade jetzt die störende oder auch heilsbringende Kraft geworden, die in aller Munde ist? Die Konvergenz von drei Kräften löste die KI-Revolution aus und ermöglichte es, KI-Techniken zur Entwicklung von realen Anwendungen auch in der Musikproduktion einzusetzen: mehr Rechenleistung und die Cloud, digitale Daten sowie bessere Algorithmen.

-

Rechenleistung: Wenn man an die Anfänge des Internets zurückdenkt, erinnern sich viele wahrscheinlich noch an die modemgestützte Einwahl und ewige Wartezeiten, bis eine Website geladen war. Erst im letzten Jahrzehnt hat sich die Rechenleistung des Computers zur Unterstützung heutiger KI-Systeme entwickelt; so hat beispielsweise Google TPU (Tensor Processing Units) eingeführt, die weitaus schneller sind als GPU (Graphics Processing Units) und speziell für KI-Anwendungen entwickelt wurden. Auch die Nutzung der Cloud ist für KI-Anwendungen wichtig: Die Cloud ermöglicht es intelligenten Anwendungen und Geräten, miteinander zu kommunizieren und voneinander zu lernen und gleichzeitig große Datenmengen zu speichern. Auch der Aspekt der Kostendegression spielt eine Rolle: Rechenkapazität hat sich enorm verbilligt. Das führt in gewisser Weise zu einer Demokratisierung der KI-Forschung (viele Länder, die nicht als Forschungsnationen bekannt sind, patentieren heute massiv im Bereich KI, z.B. Malaysia, Iran, Türkei).

-

Große Mengen digitaler Daten: Wir generieren heute mehr Daten als je zuvor. Ein einziges modernes Auto verfügt über mehr als 100 Sensoren, die Funktionen wie Kraftstoffstand und Reifendruck überwachen. Jeden Tag erzeugen wir eine riesige Menge an Daten. Und da täglich neue Anwendungen und Prozesse entstehen, wird es immer mehr Sensoren, Systeme und Geräte geben, die noch mehr Daten übertragen.

-

Bessere Algorithmen: Früher gab es grundlegende Algorithmen, die Computern vorgeschrieben haben, was sie Schritt für Schritt tun sollten. Mittlerweile sind die Algorithmen so ausgereift, dass sie Computern ermöglichen, selbständig zu lernen, das so genannte Machine Learning. Maschinelles Lernen bildet die Grundlage für die „künstliche“ Erzeugung von Wissen aus Erfahrung: So lernt ein Computer aus Beispielen und kann diese nach Abschluss der Lernphase verallgemeinern. Das bedeutet, dass sich der Computer die Beispiele nicht einfach merkt, sondern Muster und Gesetze in den Lerndaten „erkennt“. Früher gab es auch einfach nicht genügend verfügbare Daten (siehe Punkt 2), um einen Computer zu trainieren, geschweige denn, um Algorithmen zu entwickeln, die es Computern ermöglichen, sich selbst zu trainieren.

Allgemein haben wir es beim Maschinellen Lernen noch mit menschlichen Auswahl-Prozessen zu tun, zum Beispiel bei der Auswahl der einfließenden Attribute oder bei der Wahl der Algorithmen selbst, und diese Verfahren sind typischerweise aus mathematischer Logik entstanden, Beispiele dafür sind Entscheidungsbäume oder Cluster. Wir haben hier noch einen großen Anteil von menschlicher Handarbeit.

Im Gegensatz dazu arbeitet das sogenannte „Deep Learning“ als Unterform des Maschinellen Lernens mit künstlichen neuronalen Netzen, die Strukturen selbst erkennen, Ergebnisse evaluieren und sich in vielen Durchläufen, während der laufenden Anwendung, verbessern, „selbst lernen“, können – ohne menschliches Zutun. Deep Learning ist zudem sehr schnell, wenn es einmal gelernt hat. Deep Learning ist in verschiedenen Eingabe- und Verarbeitungsschichten, als neuronales Netz, hintereinander geschaltet, wobei wir von groben zu immer feineren Eingabeschichten kommen, um am Ende steht immer ein „informed guess“, den wir als Menschen auf Tauglichkeit bewerten können, und im positiven Fall vom System als Erfahrungswert in seiner Lernhistorien aufgenommen werden kann.

Bezogen auf die Musikproduktion bedeutet das, dass künstliches Wissen heute aus alten Songs generiert werden kann. Das können bestimmte Datenpunkte eines Songs sein – oder die Songstruktur. Dieses Wissen kann wieder verallgemeinert werden und für neue Songs angewendet werden. Algorithmen im Bereich Deep Learning sind immer dann interessant, wenn es keine klaren Regeln für ein Ziel gibt, und große Datenmengen verfügbar sind. Beides trifft für die Kreation eines Songs zu.

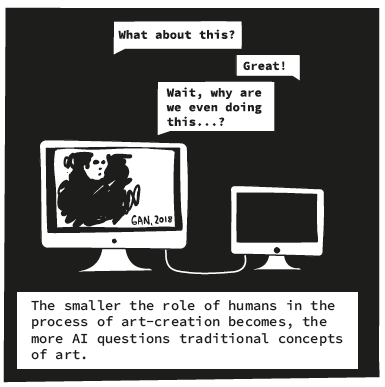

Bei der Komposition eines komplexeren Songs, wie beispielsweise des oben erwähnten KI-Popsongs Daddy´s Car, kommen Deep Learning-Algorithmen, z.B. die so genannten „Generative Adversarial Networks“ (also sinngemäß „erzeugende gegnerische Netzwerke“), zum Einsatz. GANs bestehen aus zwei neuronalen Netzen. Ein neuronales Netz schlägt basierend auf gelerntem, künstlichen Wissen neue Varianten vor und das zweite neuronale Netz bewertet die Vorschläge dahingehend, ob die Vorschläge sich von historischen Songs merklich absetzen, ob es also einen Unterschied zwischen dem künstlichen Song und alten, von Menschen gemachten Songs erkennen kann. Wenn es das nicht mehr kann, dann ist es ein „guter KI-Song“. Unterm Strich erstellt ein Neuronales Netz Song-Vorschläge und das andere Netzwerk kritisiert den Output solange, bis eine passable Song-Variante komponiert wurde.

Kann KI kreativ sein?

Aber können wir hier von Kreativität sprechen? Ahmed Elgammal vom Art & AI Laboratory an der Rutgers University in New Jersey hat sich mit Kolleginnen eine Art Turing-Test für „Kreativität“ überlegt. (Im ursprünglichen Turing-Test wird einer Maschine „Intelligenz“ attestiert, wenn ein Mensch nicht mehr mit Sicherheit sagen kann, dass er eben mit einer Maschine und keinem Menschen eine Konversation geführt hat.)

Das Ergebnis ist ziemlich interessant, wenn auch nicht überraschend: Um als künstlerische Arbeit akzeptiert zu werden, musste ein KI-generiertes Gemälde in einer künstlerischen Tradition verwurzelt sein. Zu wenig Erregungspotenzial in der Kunst gilt menschlichen Testpersonen als langweilig und zu viel aktiviert das Aversionssystem der Testpersonen, was zu einer negativen Reaktion führt. Mit anderen Worten, neue kreative Werke müssen für Menschen anders als bekannte Werke sein, gleichzeitig aber auch nicht zu unterschiedlich. Bezogen auf unser Thema, die Musikproduktion, bietet dieser kreative Turing-Test also die idealen Voraussetzungen, um Variationen von Funktionsmusik oder generische Pop-Musik zu komponieren.

Musikkulturell könnte der flächendeckende Einsatz von KI perspektivisch zu einerseits mehr gleichförmiger KI-generierter, „generischer“ Musik und andererseits zu einer Renaissance von experimenteller Musik führen, die bis auf weiteres eine Domäne des Menschen bleiben dürfte.

Selbst wenn eine Musik-KI zufällig so etwas wie die Zwölftonmusik komponieren würde, könnte sie nicht den soziokulturellen Kontext beisteuern, der allerdings notwendig wäre, um andere Menschen davon zu überzeugen, diese als Kunst zu akzeptieren.

Epilog

Tatsächlich hat KI bereits heute Musikproduktion deutlich beeinflusst und mehr und mehr Bereiche von Musik-Genres erobert. KI hat zudem bereits den Sprung von Funktionsmusik (Sounds) zum Song geschafft. Durch die Betrachtung von KI-komponierten Songs sehen wir gleichzeitig, dass die Beurteilung von Innovation in der Musik vom soziokulturellen Kontext abhängig ist.

KI kann also kreativ sein, insofern sie überraschende Variationen von Songs erschaffen kann; diese werden aber nicht unbedingt vom Menschen auch als kreativ und als Kunst akzeptiert, weil der soziokulturelle Kontext fehlt. Und dieses Beisteuern des soziokulturellen Kontextes für eine wegweisende Musikkomposition sehen wir auch in der nächsten Zukunft bei uns Menschen.

Auch andere Technologien werden die Musik als ganzheitlich sinnliche Erfahrung revolutionieren könnten. Vor allem der Bereich der Musik-Performance wird in nächster Zeit unter dem Stichwort „Gestural Music“ massiv von der Entwicklung und dem Einsatz neuer Mensch-Maschine-Schnittstellen profitieren. Spannend sind hier vor allem Wearables, die mit Bewegungssensoren bestückt werden, mit deren Hilfe elektronische Musik per Körperbewegungen oder Gesten gesteuert und manipuliert wird. Mi.Mu Gloves sind beispielsweise komplexe und hoch sensible Sensorhandschuhe, mit der die holländische Musikerin Chagall ihre eigene Stimme live verfremdet.

Wer einmal einem Elektronik-Live-Act beigewohnt hat und sich über die Anti-Show von verkopften Knöpfchen-Drehern aufgeregt hat, versteht sofort, welchen Zugewinn diese Technologie für zukünftige Bühnenshows bedeuten könnte. Im nächsten Entwicklungsschritt werden Gehirn-Computer-Schnittstellen (Brain Computer Interfaces, kurz BCI) nicht nur im Performativen Bereich die Steuerung von Geräten oder Effekten revolutionieren. Auch in puncto Barrierefreiheit böten BCIs Menschen mit schweren körperlichen Einschränkungen die Möglichkeit, Musik qua Gehirnwellen zu komponieren und auch zu performen.

Eric Eitel, bei 1E9 als @alias_eitel, kuratiert Technologie-, Kunst- und Kulturprojekte mit einem besonderen Augenmerk auf die Zukunft der Produktion. Er ist Vorstand des Kultur-Think-Tank all2gethernow e.V. und Gründungsmitglied von Music Pool Berlin, einer durch Musicboard Berlin und Europäischen Sozialfonds geförderten Beratungsstelle für Musikerinnen und Musiker in Berlin. Neben seiner kuratorischen Arbeit publiziert Eric Beiträge für Technologie- und Musikfachmedien, berät Unternehmen und Organisationen bei der inhaltlichen Positionierung und strategischen Kommunikation und twittert obsessiv als alias_eitel.

Dr. Julia Schneider, bei 1E9 als @juliaschneider, ist Autorin von Comic-Essays entlang der Dimensionen und Implikationen von Technologie und Ökonomie. Sie promovierte an der Freien Universität für ihre Forschung zu den Auswirkungen der Arbeitsmarktreform 2005. Danach arbeitete sie als Postdoc für empirische Arbeits- und Innovationsforschung mit den Schwerpunkten F&E, Diversität und Integration, Arbeitsmarktbedingungen/Arbeitsgesundheit und Digitalisierung sowie als Senior Data Strategist. Als Mitglied des wissenschaftlichen Ausschusses des VDEI Verbandes der Exoskelettindustrie e.V. koordiniert Julia die Bemühungen des VDEI zur Akzeptanz und breiten Anwendung von Exoskeletten in der Öffentlichkeit. Im Mai hat sie einen Comic zu KI veröffentlicht: We Need to Talk, AI. Ihre weiteren Veröffentlichungen sind auf ResearchGate gelistet, und sie twittert als docjsnyder.

Julia und Eric danken Dr. Helge Dauchert für die hilfreichen Kommentare.

Teaser-Bild: Getty-Images