Künstliche Intelligenz lotst uns durch die Stadt, schlägt uns Musik vor, übersetzt uns Texte. Doch viele KI-Versprechen wurden bisher nicht eingelöst – oder seid ihr schon in einem selbstfahrenden Auto gefahren? Der Grund: Die Sicherheit vieler KIs kann trotz endloser Tests nicht garantiert werden. Der KI-Forscher Alessio Lomuscio will das mit seinem neuen Start-up Safe Intelligence und mit Mathematik ändern. Bei 1E9 spricht er erstmals darüber, wie das gehen soll.

Ein Interview von Wolfgang Kerler

Alessio Lomuscio ist Professor für Safe Artificial Intelligence am renommierten Imperial College in London. Dort arbeiten er und sein Team seit Jahren an neuen Methoden, um die Sicherheit von KI-Systemen zuverlässig überprüfen zu können. Inzwischen ist die Forschung so weit fortgeschritten, dass Alessio und seine Mitstreiter das Start-up Safe Intelligence gegründet haben, um aus ihren wissenschaftlichen Ergebnissen kommerzielle Software zu machen, die schon bald auf den Markt kommen soll. Im Interview erzählt Alessio, wie er der Gesellschaft mehr sichere KI bescheren will.

Alessio, du beschäftigst dich viel mit den Fehlern, die KI macht. Magst du Künstliche Intelligenz trotzdem noch?

Alessio Lomuscio: Ich mag Künstliche Intelligenz sogar sehr. Sie fasziniert mich, seit ich ein Teenager war. Wie die meisten meiner Altersgenossen las ich damals Asimov. Ich war begeistert von Robotern und davon, was KI der Gesellschaft bringen und zu einer besseren Welt beitragen könnte. Sie wird viele Dinge möglich machen, die wir als Menschen und als Gesellschaft vorher nicht tun konnten.

Das Problem, das wir mit der heutigen KI haben, ist, dass sie unseren großen Erwartungen noch nicht gerecht wird. Stattdessen laufen einige Dinge beim Einsatz von KI nicht immer richtig, was Sicherheit, Vertrauenswürdigkeit oder auch Bias und Diskriminierung angeht. Trotzdem bin ich überzeugt, dass KI unsere ursprünglichen Erwartungen erfüllen wird.

Momentan ist die Sicherheit von KI die größte Hürde. Deswegen wollen wir dazu beitragen, den Einsatz von KI für die gesamte Gesellschaft sicher zu machen.

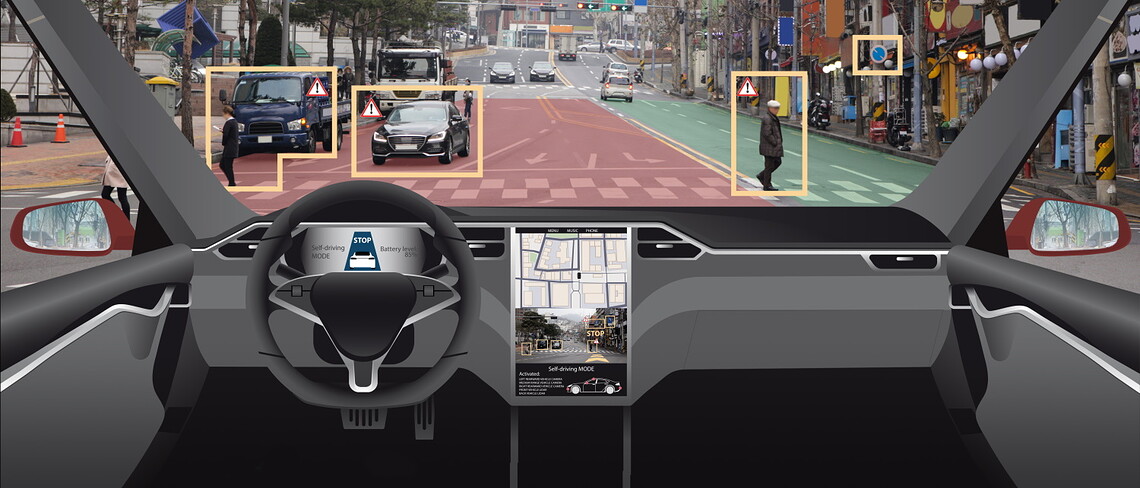

Was viele Menschen immer wieder überrascht, ist, dass selbst KI-Systeme von großen Tech-Konzernen, in deren Entwicklung Millionen, wenn nicht Milliarden von Euro geflossen sind, Fehler machen: selbstfahrende Autos bauen Unfälle, Algorithmen zur Auswahl von Job-Bewerbern diskriminieren, Gesichtserkennungssysteme verwechseln Personen. Wie kann das passieren?

Alessio Lomuscio: Weil es wirklich schwer ist, eine KI zu entwickeln, die verlässlich ist. Es hat nichts damit zu tun, dass sich die beteiligten Entwickler nicht genug anstrengen. Den meisten sind die Grenzen ihrer KI schmerzlich bewusst und sie versuchen jeden Tag, sie zu auszudehnen. Nur ist das eben ein sehr schwieriger Prozess – und wir brauchen immer wieder neue Technologie, um es hinzukriegen.

Die gute Nachricht ist, dass wir jetzt über neue wissenschaftliche, technische und mathematische Methoden verfügen, die bessere KI ermöglichen. Wir sind zwar noch nicht an dem Punkt, an dem wir ein System erschaffen können, das absolut fehlerfrei ist. Aber wir sind an einem Punkt angelangt, an dem wir die Qualität der von KI getroffenen Entscheidungen drastisch erhöhen können – so weit, dass wir bald in der Lage sein werden, die Sicherheit von KI zu zertifizieren.

Bevor wir ins Detail gehen, wie dein Team und du das anstellen wollt: Hast du ein Beispiel dafür, wie leicht es heute ist, eine KI in die Irre zu führen?

Alessio Lomuscio: Schauen wir uns Klassifizierungssysteme an, zum Beispiel Systeme zur Objekterkennung. Als KI-Entwickler wissen wir schon seit einem guten Jahrzehnt, dass deren Entscheidungen mit Unsicherheiten behaftet und fehleranfällig sein können, sogar durch das einfache Hinzufügen von Rauschen oder kleinen Artefakten außerhalb des zu erkennenden Objekts können sie verfälscht werden.

Deshalb lassen sich manche Gesichtserkennungssysteme durch T-Shirts mit bunten Aufdrucken außer Gefecht setzen.

Alessio Lomuscio: Ja. Es könnte aber auch sein, dass ein autonomes Auto bestimmte Fahrzeugmodelle in einer bestimmten Farbe perfekt erkennt, dann aber mit anderen Modellen in anderen Farben große Schwierigkeiten hat. Vergleichbare Einschränkungen finden wir bei vielen KIs. Tatsächlich haben alle Systeme, die auf neuronalen Netzen aufbauen, eine Anfälligkeit für solche Fehler.

Wir sprechen hier also in erster Linie von KI-Systemen, die auf maschinellem Lernen und neuronalen Netzen basieren. Das heißt, es sind Systeme, die sich auf Basis von Trainingsdaten „selbst beigebracht“ haben, wie sie zu einer Lösung kommen.

Alessio Lomuscio: Genau. Ganz grundsätzlich können wir zwei Ansätze zur Entwicklung von KI unterscheiden. Der eine ist der traditionelle Ansatz, der seit mehreren Jahrzehnten eingesetzt wird und auf Symbolic Reasoning beruht. In Deutschland wird er auch Symbolische KI genannt. Dabei wird KI eingesetzt, die mit meist von Menschen vorgegebenen Wissen und Regeln ausgestattet und durch Automated Reasoning unterstützt Entscheidungen trifft. Das funktioniert für viele Anwendungen erstaunlich gut und macht mir kaum noch Sorgen.

In den vergangenen Jahren erlebt aber eine neue Klasse von KI-Systemen einen Boom, die auf neuronalen Netzen basieren und zum Beispiel bei Computer Vision und in anderen Bereichen bisher unerreichte Ergebnisse liefern. Daher werden sie in autonomen Autos, für die Gesichtserkennung und in vielen anderen Bereichen eingesetzt. Bei solchen Systemen wissen wir aber oft nicht genau, wie sie ihre Entscheidungen treffen, da sie mit Datensätzen trainiert und nicht direkt programmiert werden. Oft wird von solchen KIs als Black Box gesprochen. Solche Systeme bereiten mir größere Sorgen, wenn es um Fehler, Bias oder ihre Erklärbarkeit geht.

Bisher werden solche KIs getestet, getestet und nochmals getestet, um Fehler zu finden und zu beheben. Man hat inzwischen längst den Überblick verloren, wie viele Millionen Kilometer autonome Testfahrzeuge zurückgelegt haben. Müssten nach so vielen Tests nicht irgendwann alle Fehler gefunden und behoben sein?

Alessio Lomuscio: Schön wär‘s. Leider ist das nicht der Fall. Das Problem ist, dass die Fehler, die auftreten können, nicht sehr häufig sind. Das System funktioniert also in den meisten Situationen bemerkenswert gut. Außer in wenigen Grenzfällen. Um die zu finden und zu verstehen, muss man – um beim Beispiel der selbstfahrenden Autos zu bleiben – Testfahrten von Abermillionen von Kilometern durchführen. Und selbst das scheint nicht auszureichen, um mit Überzeugung zu sagen, dass die Systeme sicher sind. Deshalb sind einige Leute zum Schluss gekommen, dass Tests zwar sehr nützlich sind, aber alleine nicht ausreichen. Es braucht zusätzlich neue Methoden – zum Beispiel die Verifikation.

Hier kommt dein gerade gegründetes Start-up Safe Intelligence ins Spiel. Ihr arbeitet an einer Lösung für vertrauenswürdige, sichere und erklärbare KI – und das ohne Dauertests. Was ist euer Geheimnis?

Alessio Lomuscio: Wir können verifizieren beziehungsweise überprüfen, ob Variationen bestimmter Regionen im Eingaberaum verlässlich korrekte Ergebnisse erzeugen. Das klingt kompliziert, aber vielleicht wird es an einem Beispiel greifbar: Was wir mit unseren Werkzeugen herausfinden können, ist, ob ein KI-System ein Auto nur dann erkennt, wenn es ein weißer Audi ist – oder ein Audi in irgendeiner Farbe; oder ob getönte statt transparenter Scheiben die Erkennung eines Mercedes verhindern können. Das ist nur ein Beispiel, aber sie können sich die Korrektheit in Bezug auf alle Arten von Abweichungen vorstellen.

Wir formulieren das Problem als mathematische Formel.

Im Allgemeinen lässt sich mit unserer Technologie überprüfen, ob sich das System bei allen in der Realität vorkommenden Variationen einer Variablen richtig verhält, zum Beispiel der geometrischen Form oder Farbe eines Objekts. Das erreichen wir nicht durch endloses Testen. Wir formulieren das Problem als mathematische Formel. Dann können wir mathematisch bestimmen, ob das System nicht sicher oder sicher ist. Der Entwickler wird sofort mit einem Fall konfrontiert, in dem ein Fehler auftritt. Oder wir können die Sicherheit des Systems für die jeweilige Fragestellung zertifizieren.

Der Ansatz basiert auf einer Technologie, die in den letzten Jahren in Großbritannien, den USA und der Schweiz von verschiedenen Gruppen entwickelt wurde. Insbesondere am Imperial College London haben wir uns auf spezielle Methoden konzentriert, die hinsichtlich der Größe der Modelle, die wir überprüfen können, sehr skalierbar sind.

Ihr ersetzt endloses Testen durch Mathematik. Das klingt nach einer echten Erleichterung. Aber für eure Methode muss man eine Vorstellung davon haben, in welchen Bereichen es zu Fehlern kommen könnte, um die mathematische Gleichung zu formulieren. Was, wenn ihr vergesst, etwas zu verifizieren, das man eigentlich überprüfen müsste?

Alessio Lomuscio: Das ist ein Problem. Allerdings gibt es viele Faktoren, von denen wir wissen, dass sie problematisch sein können: Farbvariationen, geometrische Veränderungen, Kontrast und Helligkeit, Regen, Bewölkung, Sonnenschein – all das und viel mehr können wir sehr gut in mathematischer Sprache ausdrücken und das System mit unserer Technologie erproben.

Der springende Punkt ist, dass wir die Sicherheit für eine sehr große Klasse von Fällen überprüfen und verbessern können, von denen wir durch die vielen Tests bereits wissen, dass das System anfällig ist. Das ist ein echter Durchbruch für diejenigen, die Anwendungen entwickeln und einsetzen wollen. Absolute Sicherheit gewährt auch das nicht, da man nicht alle möglichen Variationen aller möglicher Input-Variablen vorhersehen kann. Aber es ist ein gewaltiger Fortschritt.

Dieser Prozess, den ihr Verifikation von KI nennt, wird nur die erste Methode sein, die ihr für Kunden zugänglich machen wollt. Danach soll eure Software auch die Fehler, die sie in Machine-Learning-Modellen findet, automatisch reparieren. Wie soll das funktionieren?

Alessio Lomuscio: Bei der Verifikation kann herauskommen, dass die KI das tut, was sie soll. Ein tolles Ergebnis, das man gegenüber Aufsichtsbehörden, Kunden, der Gesellschaft verwenden kann, um die Sicherheit des Systems zu belegen.

Durch den Einsatz unserer Software könnten Entwickler aber auch Schwachstellen gefunden haben. Nun sind Entwickler sehr gut darin, Systeme zu verbessern, wenn sie wissen, wo die Schwachstellen liegen. Das wird auch schon mit unserer reinen Verifikationslösung möglich sein. Wir entwickeln aber Technologie, die noch mehr kann: vom automatischen Training, um die Qualität der KI in Bezug auf die Schwachstelle zu verbessern, bis zum automatischen Vornehmen minimaler Änderungen an den neuronalen Netzen, um die Bugs zu beseitigen, ohne die Leistung des Systems zu verlieren.

Wenn ihr das erledigt habt, wollt ihr eine weitere Funktion anbieten: die Entscheidungen der KI sollen mit eurer Software „erklärbar“ gemacht werden. Warum ist das nötig?

Alessio Lomuscio: Erklärbarkeit ist vor allem deshalb wichtig, weil KI manchmal falsche Entscheidungen trifft. Dann sollte man Nutzern, Behörden, aber auch den Entwicklern zumindest erklären können, wie es dazu kam und wie sich das System verbessern lässt.

Werde Mitglied von 1E9!

Hier geht’s um Technologien und Ideen, mit denen wir die Welt besser machen können. Du unterstützt konstruktiven Journalismus statt Streit und Probleme! Als 1E9-Mitglied bekommst du frühen Zugriff auf unsere Inhalte, exklusive Newsletter, Workshops und Events. Vor allem aber wirst du Teil einer Community von Zukunftsoptimisten, die viel voneinander lernen.

Jetzt Mitglied werden!

Das große Finale eurer Pläne ist eine Software zur ständigen Überwachung von KI, die bereits im Einsatz ist. Wozu braucht es die noch, wenn KI schon verifiziert ist?

Alessio Lomuscio: Bei der Verifikation von KI geht es darum, Fehler zu finden und zu korrigieren, bevor eine KI zum Einsatz kommt – wir sprechen von Design Time Assurance. Aber wir denken natürlich auch über Runtime Assurance nach, also die Sicherheit während des Einsatzes von KI nach. Denn, wie wir schon besprochen haben, können wir während der Entwicklung einer KI nicht alle möglichen Variationen von Input-Variablen vorhersagen, mit denen das System im Einsatz konfrontiert wird. Eine sehr große Anzahl davon, aber nicht alle.

Deswegen entwickeln wir auch Software, die Nutzern die Gewissheit gibt, dass die KI sicher eingesetzt werden kann, da sie erkennt, wenn die KI nicht so funktioniert, wie sie soll. Ist das der Fall, kann das neuronale Netz angehalten werden und die Kontrolle einem Sicherheitsmechanismus übertragen werden, der das System stoppt.

Wie sieht eigentlich euer Zeitplan aus?

Alessio Lomuscio: Erste Produkte wollen wir bereits in den nächsten neun bis zwölf Monaten anbieten.

Wenn dann irgendwann alles, woran ihr arbeitet, tatsächlich funktioniert, was hätte das für Auswirkungen? Was würde es auch für mich als User, Bürger, Mensch bedeuten?

Alessio Lomuscio: Wir sehen im Moment sehr viele KIs, die in Labors und der Proof-of-Concept-Phase steckenbleiben, aber nicht zum Einsatz kommen, weil ihre Sicherheit bezweifelt wird. Das heißt, weder du noch ich können von diesen Systemen profitieren.

Wir sehen im Moment sehr viele KIs, die in Labors und der Proof-of-Concept-Phase steckenbleiben, aber nicht zum Einsatz kommen, weil ihre Sicherheit bezweifelt wird.

Wenn wir durch unsere Technologie in der Lage sind, ihre Sicherheit zu verbessern und zu zeigen, dass die Systeme sicher eingesetzt werden können, werden wir sehr schnell viele neue Möglichkeiten bekommen. Autonome Fahrzeuge könnten zum Einsatz kommen, bessere Roboter entwickelt werden, hinzu kämen Fortschritte in der Luft- und Raumfahrt, aber auch B2B- und B2C-Anwendungen von Banken oder Versicherungen und vieles mehr.

Auf welche KI freust du dich besonders?

Alessio Lomuscio: Ha, gute Frage. Darüber habe ich noch gar nicht nachgedacht. Aber wenn ich an meine Jugend zurückdenke, würde ich wohl gerne etwas von Asimovs Vision verwirklicht sehen. Ich würde gerne völlig autonome Raumschiffe in unserer Galaxie sehen, die keinen Schaden anrichten, wissenschaftliche Entdeckungen machen und uns neues Wissen bringen.

Hat dir der Artikel gefallen? Dann freuen wir uns über deine Unterstützung! Werde Mitglied bei 1E9 oder folge uns bei Twitter, Facebook, Instagram oder LinkedIn und verbreite unsere Inhalte weiter. Danke!

Titelbild: Shutterstock

Sprich mit Job, dem Bot!

War der Artikel hilfreich für dich? Hast du noch Fragen oder Anmerkungen? Ich freue mich, wenn du mir Feedback gibst!