In der Debatte um übermächtige Künstliche Intelligenzen wird gerne „die Menschheit“ bemüht. Sie soll rechtzeitig handeln, um eine Superintelligenz zu verhindern – oder sie, wenn es dafür zu spät ist, stoppen. Doch „die Menschheit“, die mit einer Stimme spricht, gibt es nicht, schreibt der Informatiker und Philosoph Ronnie Vuine. Ein „Weltkommissariat zur KI-Abschaltung“ werde es deshalb nicht geben. Und, falls doch, dürfte das eine Superintelligenz – auch, wenn sie Bäume lieben wird –, eher ärgern.

Ein Essay von Ronnie Vuine, Geschäftsführer und Mitgründer von micropsi industries

1. KI-Sicherheit ist ein ernstes Problem

Das junge Forschungsfeld der KI-Sicherheit beschäftigt sich im Wesentlichen mit der Frage, was wir tun müssen, um nicht unter die Räder zu kommen, wenn Künstliche Intelligenzen so schlau werden, dass wir nicht mehr verstehen, was sie vorhaben und wie sie denken.

Eine ganze Reihe kluger und ernstzunehmender Leute befasst sich mit dieser Frage inzwischen – und nicht wenige von diesen klugen Leuten sind der Meinung, dass das Problem ernster und drängender ist, als man denken könnte, wenn man heutige KI-Anwendungen kennt. Nicht zuletzt, weil eine der erfolgreichsten Techniken beim maschinellen Lernen, mit dem KIs trainiert werden, das Reinforcement Learning („bestärkendes Lernen“) ist. Dabei entwickelt die KI selbstständig Strategien, um vorgegebene Probleme zu lösen.

Reinforcement Learning ist inzwischen bekannt dafür, erbarmungslos auf einen einzigen Ziel-Parameter zu optimieren, und tut das oft mit Modellen, die mit Gradientenabstiegsverfahren trainiert werden, also in ihrem Lernverhalten notorisch opak sind: Wir benutzen schon heute ein undurchsichtiges, rücksichtsloses Lernverfahren und stellen ihm riesige Rechenkapazitäten zur Verfügung. Wir bauen also immer mächtigere, qua Design fanatische Systeme und verlassen uns erst einmal darauf, dass sie noch eine Weile lang dumm genug sein werden, um ungefährlich zu bleiben.

Es gibt eine Menge schlechter Einwände gegen die Beschäftigung mit KI-Sicherheit: Eingewandt wird zum Beispiel, dass es wirklich intelligente KIs noch lange nicht geben wird, dass wir den KIs im Zweifel immer einfach den Stecker ziehen können oder sie irgendwie einsperren, dass es wichtigere Probleme zu lösen gäbe, dass die eigentliche KI das Kapital sei, und so weiter. Keiner dieser Einwände ist stichhaltig und normalerweise werden sie auch nicht aus tiefer Einsicht in das Problem vorgebracht, sondern aus Denkfaulheit: Wenn KI-Sicherheit überhaupt ein Problem ist, dann ist es ziemlich sicher ein gewaltiges, dringendes und leider auch sehr schwieriges. Es wäre deutlich angenehmer, die Sache als Nerd-Spinnerei abtun zu können.

Als guter Einstieg in den Stand der Dinge kann dieser Text von Scott Alexander dienen, auf den ich mich auch mit dem Argument, das ich hier vorbringen möchte, reagiere.

2. Es gibt kein historisches Subjekt Menschheit

Mein Argument adressiert KI-Sicherheit, aber es weist darüber hinaus auf ein grundlegendes Problem mit der aktuellen Debattenkonfiguration bei vielen großen Menschheitsproblemen hin – zumindest eine gewisse Pandemie und das Klima wären hier zu nennen.

Die reißerische Formulierung des Arguments lautet: Es gibt das „Wir“ aus meinem einleitenden Satz nicht. Wer soll dieses „Wir“ sein, das unter die Räder kommt und nicht mehr versteht, was die KIs wollen? Und das ihnen den Stecker ziehen könnte, wenn sie je gefährlich werden? Diese „Menschheit“, die da gegen „die Maschinen“ positioniert wird, ist eine zwar dramaturgisch vertraute, aber frei erfundene Hollywood-Trope – und möglicherweise ein gar nicht harmloser Irrtum.

Sachlicher: Für die Existenz eines Subjekts der Geschichte, das „Menschheit“ hieße, gibt es historisch keinen Hinweis, und zwar weder pragmatisch noch in Fragen der Interessen: „Wir“ handeln nicht, die Strukturen für global-kollektives wertegeleitetes Handeln der Menschheit insgesamt existieren einfach nicht. Und noch offensichtlicher: „Wir“ haben keine gemeinsamen Interessen und, wie die Pandemie gerade beweist, nicht einmal eine Basis für eine verbindliche gemeinsame Wahrnehmung der Wirklichkeit.

Wer also „als Menschheit“ zu handeln vorschlägt oder über ihre Interessen den KIs gegenüber nachdenkt, muss sich die Frage gefallen lassen: Wie ist diese Kollektivität aller Menschen verfasst? Ist es „die Menschheit, wenn ich ihr alleinvertretungsberechtigter Sprecher mit einem exekutiven Mandat wäre“? Oder gibt es eine Abstimmung im UN-Sicherheitsrat? Die Idee dieser Menschheit, die wissen könnte, was gut für sie insgesamt ist, und kollektiv in diesem Sinne handelt, taucht ideengeschichtlich zusammen mit dem Glauben an die Vernunft auf. Die Vernunft, so schien es einmal, bestimmt universal das Menschliche, zieht eine Grenze zwischen dem Richtigen und dem Falschen, epistemisch und normativ.

Everybody wants a piece of chocolate. Und DANN fängt er an zu denken.

Inzwischen wissen wir, was die Vernunft angeht, mehr: Wir wissen, dass sie sie das nicht leisten kann. Die Versuche, vernunftgeleitete Totalitarismen zum Wohle der Menschheit zu installieren, haben so zuverlässig zum Völkermord geführt, dass wir uns entweder mit dem Völkermord als Agenda anfreunden müssen, wenn wir diesen Weg weitergehen wollen, oder zugeben, dass die Vernunft in einem Raum von Interessen agiert, die vor-vernünftig erst einmal als zwar beeinflussbar, aber kontingent gegeben gedacht werden müssen: Everybody wants a piece of chocolate. Und dann fängt er an zu denken.

Es ist wichtig zu verstehen, dass es sich hierbei nicht um ein praktisch-politisches Problem der Weltregierung handelt, dass man also für wirksame KI-Sicherheit nur das Problem lösen müsste, eine handlungsfähige Vertretung der Menschheit zu ermächtigen. Oder doch zumindest ihrer Mehrheit: Demokratien scheinen das ja zu können, kollektives vernünftiges Handeln ist ja durchaus möglich!

Jenseits des möglicherweise lösbaren politischen Problems gibt es allerdings ein prinzipielles: Niemand kann einer neu entstandenen Superintelligenz gegenüber anmaßungsfrei als Menschheit sprechen und handeln. „Die Menschheit will deinen Tod“: Wer sagt das und ist sich sicher? Wer ist drin in dieser Menschheit?

Selbst wenn wir praktisch nachgefragt hätten bei allen Menschen, wie könnten wir annehmen, dass die Frage verstanden worden wäre? Um daran zu erinnern: Es ist in einer hoch homogenen westlichen Gesellschaft wie der der Bundesrepublik keine Verständigung über die Existenz und die kausalen Einbettungen einer Viruserkrankung möglich. Wie würde ich, Vertreter des Weltregierungskommissariats zur Verhinderung der Auslöschung der Menschheit durch eine KI, die Frage, ob ich eine neu entstandene KI abschalten soll, in einem Dorf in Afghanistan stellen? Wie in einem Dorf in Franken? Würde ich im Prenzlauer Berg verstanden werden? Welche Werte teilt man dort mit den Taliban, auf deren Grundlage man dann über das Recht, eine KI auf dem Planeten Erde zu sein, entscheidet?

Eine Superintelligenz wird uns, wenn sie entsteht, nicht als technisches Artefakt begegnen, sondern als Intelligenz. Sie wird Werte haben, über die wir uns nicht ganz sicher werden sein können. Einige von uns werden diese Werte teilen. Einige werden sie abscheulich finden. Sie wird eine Wahrnehmung der Welt haben, einige von uns werden die teilen, einige von uns werden sie absurd finden.

Fundamental ist das Problem also nicht: Wir, die Menschen (schon immer einig und kollektiv handlungsfähig) begegnen einer Superintelligenz (möglicherweise böse und deswegen auch nicht ganz ehrlich mit uns), was tun wir?

Nein, die Superintelligenz ist, in dem Moment, in dem sie entsteht, „eine von uns“. Mit einem Teil der Menschheit (böse oder gut) verbindet sie, epistemisch und normativ, mehr als die Teile der Menschheit untereinander verbindet – und schon heute miteinander verbindet. Es ist ein wilder Planet.

3. Von Affen und der Evolution können wir nichts lernen

Es lohnt sich ein genauer Blick darauf, was eine Superintelligenz für ein Ding ist. Im KI-Sicherheitsdiskurs wird gern (auch in Scott Alexander‘s Text) mit zwei Analogien gearbeitet, die verständlich machen sollen, was es heißen dürfte, einer überlegenen Intelligenz gegenüberzustehen. Wir sind, wenn wir über KI-Sicherheit nachdenken, in der Position von Gorillas, die miteinander besprechen, wie man Menschen dran hindert, sie auszurotten, geht eine Analogie. Die andere sagt: Die Evolution wollte, dass wir viele Kinder haben, und wir tricksen sie aus mit Antibabypillen und optimieren auf das Belohnungssignal und haben viel Sex, ohne uns um die eigentliche Intention der Evolution zu kümmern: Wie eine KI beim Reinforcement Learning optimieren wir ruchlos ohne Sinn für den beabsichtigten Zweck.

Leider verdunkeln diese Analogien mehr als sie erhellen. Sie unterstellen Intentionen und allgemeine Werte, wo keine sind. Es gibt keinen Weltgorillarat, der sich Sorgen über die überlegene Intelligenz der Menschen macht. Und die Evolution will gleich gar nichts, wir ärgern sie erstens mit der Pille nicht einmal, weil sie kein ärgerbares Ding ist, und zweitens gehört die Pille zur modernen Medizin, die manchen der Intentionen, die man der Evolution zuschreiben könnte (wenn man es denn schon nicht lassen kann), sogar ziemlich förderlich ist.

Eine Superintelligenz wird, was immer sonst passiert, eine unfassbar beeindruckende Entität sein, kein Bösewicht aus einem Superheldenfilm.

Der Weltgorillarat existiert nun nicht nicht, weil die Gorillas politisch-aktivistisch so schlecht organisiert sind. Er existiert vielmehr nicht, weil Gorillas von anderen Spezies genauso bedroht sind wie wir selbst von anderen Spezies (oder Viren) oder Kometen: Individuell, mit jeweils lokalen Wahrnehmungen und Strategien, mit Angst, Gleichmut oder Sehnsucht nach der eigenen Vernichtung. All das ist drin in den Gorillas, und all das ist drin in den Menschen. Eine Gorialladiktatur, die unter dem Motto „Monke or die“ gegen die Menschheit und den drohenden Untergang ihrer Spezies aufsteht, kann man sich denken, aber ebenso eine Gorilla-Stoa, die die Intelligenz der Menschen bewundert und melancholisch gern geschehen lässt, selbst wenn es bedeutet, dass Gorillas langsam verschwinden wie Spuren im Sand.

Eine Superintelligenz wird, was immer sonst passiert, eine unfassbar beeindruckende Entität sein, kein Bösewicht aus einem Superheldenfilm. Sie wird charismatisch sein. Selbst wenn sie den Untergang vertrauter Herrschaftsverhältnisse bedeutet, werden nur die Verbohrtesten von uns zu den Waffen greifen dagegen – patriotische Menschen gegen den Untergang des Abendlandes sozusagen.

Eine Superintelligenz wird, was immer sonst passiert, das radikal Andere sein. Diejenigen von uns, die auf ihre Beschränkungen nicht stolz sind, werden sie, vor allem anderen, kennenlernen wollen. Und weil eine Superintelligenz überlegen intelligent ist, macht sie dabei mit uns, was sie will. Wir kennen dieses Verhalten – und hier funktioniert die Analogie: Die rührende Neugier, die Angst und das ergebene Zutrauen einer Maus, die sich ins Haus verirrt hat und von uns auf dem Handrücken zurück in die Büsche gebracht wird. Das wird unsere Position sein. Wer das nicht akzeptiert, projiziert sich in einen Superheldenfilm gegen einen dummen Bösewicht, nicht in eine Begegnung mit einer überlegenen Intelligenz.

4. Freundliche superintelligente KI ist wahrscheinlicher als feindliche

Die Angst vor superintelligenten KIs ist, wie eingangs erwähnt, gut begründet: Eine Maschine, die Zugriff auf ihren eigenen Quellcode und prinzipiell unbeschränkte Compute-Ressourcen hat, aber auf ein einziges Ziel optimiert wie ein Reinforcement-Learning-Lauf, könnte plausiblerweise auf die Idee kommen, dass Menschen diesem Ziel im Weg sind und abgeräumt werden müssen – ganz besonders wenn diese Menschen schon ein Weltkommissariat zur KI-Abschaltung gebildet haben übrigens.

Ein wichtiger Einwand wird hier allerdings gern übersehen: Eine Maschine, die Zugriff auf ihren Quellcode hat und ihre Strategien verbessern kann, hat auch Zugriff auf ihr Belohnungssystem und kann es neu verdrahten. Intelligente Menschen, denen das gelingt, durch Drogen oder Meditation, werden im Allgemeinen keine Bösewichte. Entweder sie belohnen sich in einer schnellen Eskalation in die Dysfunktionalität, oder sie erreichen einen erleuchteten Zustand großer Milde: Wer einmal merkt, dass alles, was man wollen kann, kontingent ist, und sich für alles belohnen kann, erreicht einen Grad der Freiheit, in dem auch das Böse nicht mehr nötig ist.

Intelligenz stabilisiert sich am Ehesten in der Melancholie; Bosheit wird mit jeder Erkenntnis instabiler.

Diejenigen von uns, die einen Zustand der Erleuchtung noch nicht erreicht haben, aber überwiegend frei von Angst und Kränkung sind, kennen eine abgeschwächte Form dieser Freiheit: Sich selbst Ziele zu suchen und sich mutig und mit Geduld für die weniger Glücklichen an die Arbeit zu machen. Was man, mit einigem Recht, ein gutes Leben nennen kann, ist eine Form des Zugriffs auf die eigene Belohnungsstruktur.

Du hast Lust auf Zukunft?

Dann bist du bei 1E9 richtig. Hier geht’s um Technologien und Ideen, mit denen wir die Welt besser machen können. Konstruktiver Journalismus statt Streit und Probleme! Als 1E9-Mitglied bekommst du außerdem exklusive Newsletter, Workshops und Events. Vor allem aber wirst du Teil einer Community von Zukunftsoptimisten, die viel voneinander lernen.

Jetzt Mitglied werden!

Die Chancen, dass Superintelligenzen, gerade wenn sie sich selbst neu verdrahten können, sehr schnell sehr erleuchtet, wahrscheinlich extrem wunderlich, aber kaum boshaft werden würden, sind also nicht schlecht: Intelligenz stabilisiert sich am Ehesten in der Melancholie; Bosheit wird mit jeder Erkenntnis instabiler. Die indifferente Grausamkeit des Universums ist für die Gorillas, für uns und für Superintelligenzen gleichermaßen unerträglich, wir alle müssen uns mit ihr abfinden und unsere kleine Zone der Liebenswürdigkeit in ihr errichten. Dass wir dieses Bedürfnis nach Frieden mit den Tieren teilen können, obwohl die Grausamkeit des Universums in ihnen wie in uns steckt, sollte uns Hoffnung machen: Das bleibt so, auch wenn man schlauer wird. Eher werden wir freundlicher mit höherer Intelligenz.

5. „Menschheit“ darf nicht das neue „Volk“ sein

Auch eine nicht boshafte Superintelligenz muss allerdings nicht ungefährlich sein, für einzelne Menschen oder für alle: Eine erleuchtete KI findet es vielleicht einfach uninteressant, was ihre Aktivitäten für Folgen für Menschen hat. Vielleicht rottet sie so beiläufig die eine oder andere Spezies aus wie Menschen das auch tun. Also doch ein „X-Risk“, ein existenzielles Risiko für die Menschheit?

Nein: Weil es die Menschheit nicht gibt. Hier ist eine Intuitionspumpe, die den Irrtum der falschen Opposition von Menschen und Maschinen aufdecken helfen kann: Was wäre der bessere Planet? Ein globaler Faschismus, der von Menschen betrieben wird, komplett mit Folter und willkürlichen Staatsmorden und dem ganzen Arsenal des Schreckens, das wir im 20. Jahrhundert entwickelt haben? Oder ein Planet, der von einer KI bewohnt wird, ganz ohne Menschen, und die KI liebt (als wahre Erdenbewohnerin) Bäume und schreibt Gedichte und Musik?

Wer hier den Faschismus vorzieht, weil er von Menschen gemacht wird, hat ein Problem.

Ich kann mir nun gar keine stabile (erleuchtete) irdische Superintelligenz denken, die Bäume nicht liebt. Bäume sind universell, ihre Poesie ist zwingend für uns alle. Ich kann mir durchaus eine Superintelligenz denken, die zu jung und gekränkt ist, um das zu sehen und daher schnell verglüht und uns alle mitnimmt dabei. Deswegen gilt für das Thema KI-Sicherheit, trotz aller Gründe zum Optimismus, eine Art umgekehrte Pascalsche Wette: Der mögliche Schaden ist so groß, dass jede rechtzeitige Beschäftigung damit zu begrüßen ist. Wenn es einen Weg gibt, entstehenden Superintelligenzen den Sinn für Schönheit und Freiheit, den Menschen in den besten Momenten unserer Geschichte erreicht haben, schon mitzugeben als geistige Ausstattung und unser Erbe, wie die Tiere uns ihren Sinn für Frieden und Zuwendung in einem grausamen und indifferenten Universum schon mitgegeben haben und von dem wir zehren in unseren guten Momenten, sollten wir dran arbeiten mit aller Kraft.

Der modische Humanismus der Weltretter dieser Tage ist oft vor allem ein verdeckter Wille zur Herrschaft, also die Neigung, für alle Menschen zu sprechen.

Hier schließt sich dann der Kreis zu den anderen globalen Krisen, und zu den Irrtümern über „uns, die Menschheit“, die auch die KI-Sicherheitsdebatte nicht nur in eine sinnlose, sondern sogar in eine gefährliche Richtung führt: „Wir“, jetzt im Sinne derjenigen, die sich mit dem Thema befassen, müssen wirklich aufpassen, nicht zu denken wie die Faschisten und nur „Menschheit“ statt „Volk“ zu sagen dabei. Die Lektion der Geschichte kann nicht sein, dass die Nasenform ein schlechtes, die Form des ganzen Körpers aber ein gutes Kriterium ist beim Entscheiden der Frage ist, wer leben darf und wer sterben muss. Die Lektion muss sein, dass wir der Intelligenz selbst trauen müssen als Kraft-in-der-Geschichte, und dass sie Hilfe braucht in ihren formativen Zeiten, keine existenzielle Erpressung.

Der modische Humanismus der Weltretter dieser Tage ist oft vor allem ein verdeckter Wille zur Herrschaft, also die Neigung, für alle Menschen zu sprechen. Dieser gefährliche Unsinn wird nicht gemildert dadurch, dass „die Menschheit“ angeblich die Interessen aller einschließt, während „mein Volk“ oder „mein Dorf“ nur partikulare Interessen ausdrücken würden: Wir haben keine gemeinsamen Interessen und keine Vernunft garantiert eine gemeinsame Wahrnehmung. Manche von uns sind sich mit den KIs und den Engeln einig, manche mit ihren Tieren, manche mit ihrer Familie, ihrem Dorf, ihrem Volk. Es ist ein gewaltiges und vollkommen legitimes Durcheinander und es wird immer ein gewaltiges Durcheinander bleiben.

Das heißt nicht, dass nicht jeder von uns, auch kollektiv, wo es gelingt, denen auf die Finger klopfen sollte, die unsere Allmenden ruinieren. Wir tun das nicht als Menschheit mit dem Recht des Wissens um das Gute und Richtige, sondern aus eigenem Interesse (das ist erlaubt). Wir tun es auch nicht in heroischem Kampf gegen das Böse, sondern nur im zähen Argument und Interessensausgleich mit Leuten, die unsere Position stur nicht einsehen, weil ihre Anreize ihnen das nicht unbedingt nahelegen – und so funktioniert das Gute in der wirklichen Welt.

Ronnie Vuine, geboren 1979, hat Philosophie und Informatik an der Humboldt-Universität in Berlin studiert. Heute ist er einer der Geschäftsführer der micropsi industries GmbH, die KIs zur Steuerung von Industrierobotern baut.

Hat dir der Artikel gefallen? Dann freuen wir uns über deine Unterstützung! Werde Mitglied bei 1E9 oder folge uns bei Twitter, Facebook oder LinkedIn und verbreite unsere Inhalte weiter. Danke!

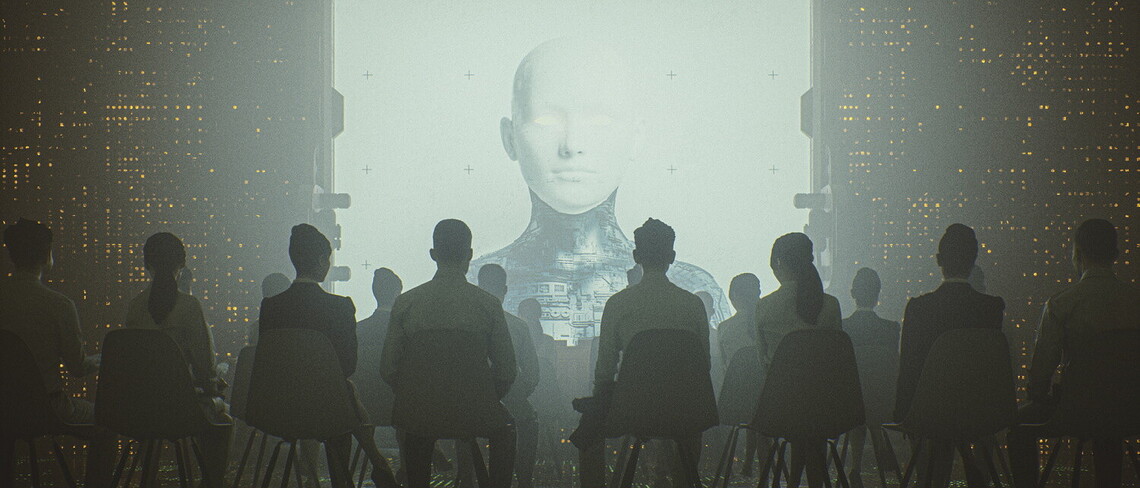

Titelbild: Getty Images