Künstliche Intelligenz kann ein mächtiges Werkzeug sein. Vor allem in den Händen von Kreativen und Künstlern. Mittels KI-Technologie lassen sich sogar komplette und durchaus bemerkenswerte Kurzfilme erstellen. Genau das hat der als Merzmensch bekannte Vladimir Alexeev getan – und erzählt hier, wie ihr das euch könnt.

Von Vladimir Alexeev

Wahnsinn. Ich erinnere mich, wie ich mir Sunspring angesehen habe – wieder und immer wieder. Fasziniert von den absurden Dialogen versuchte ich zu verstehen, was in diesem kurzen Film vor sich geht. Aber der Sinn entglitt mir immer wieder. Denn das Drehbuch wurde von KI geschrieben. Benjamin war der Name des Autors. Hinter diesem Namen verbarg sich ein rekurrentes neuronales Netzwerk namens LSTM, verfeinert von Ross Goodwin, einem KI-Forscher und Dichter. Der Film wurde von dem für den BAFTA nominierten britischen Filmregisseur Oscar Sharp gedreht. Und das Casting war perfekt – allein schon der verwirrte Thomas Middleditch.

Auch wenn die Handlung aus absurden und scheinbar willkürlichen Phrasen bestand, hat unser menschliches Gehirn versucht, sie zu verstehen. Cogito, ergo sum.

Ross Goodwins lesenswerte Essays über KI und Kreativität waren es, die mich in seinen Bann zogen und inspirierten: Adventures in Narrated Reality – Part One, Part Two. Mit seinen Experimenten – und später mit seinem KI-generierten Buch 1 the Road – bewies Ross Goodwin, was mit Künstlicher Intelligenz alles möglich ist. Und diese Erkenntnis war eine entscheidende: KI ist weder nur ein Werkzeug noch ein vollständiger Ersatz für einen Schriftsteller. Man braucht eine Symbiose, um gemeinsam mit der Maschine Kunst zu kreieren.

Ein Film ohne Studio

Wir haben gesehen, wie viele kreative Anwendungen mit verschiedenen Machine Learning Ansätzen möglich sind. Mit dem 3D-Ken-Burns-Effekt können wir animierte Traumvisionen erstellen, indem wir ein einzelnes Foto in einen räumlichen Kameraflug umwandeln. Mit GPT-2 und GPT-3 von OpenAI können wir ganze Geschichten schreiben. Aber was, wenn wir alle Ansätze zu einem einzigen multimedialen Kunstwerk, einem Kurzfilm, kombinieren? Und was wird zum Drehen eines Kurzfilms alles gebraucht?

Man kann sicherlich auf einige Elemente verzichten, um Arthouse-Qualität zu erreichen, aber in der Regel braucht man die folgenden Zutaten:

- den Plot

- die Kamera / das Bildmaterial

- die Darsteller

- die Musik

Außerdem sind eine originelle Idee und – in den meisten Fällen – noch ungenutzte Medienressourcen unentbehrlich. Wie können wir nun den Machine-Learning-Ansatz nutzen, um all diese Punkte zu erfüllen?

Der Plot

Hinweis des Autor: Gerade als dieser Essay verfasst wurde, veröffentlichte OpenAI GPT-3, ein Sprachmodell von literarischer Qualität, das für den vorliegenden Film nicht genutzt wurde.

Wie bereits erwähnt, ist GPT-2 ein leistungsfähiges NLP-Modell – vortrainiert auf 40 GB Text mit 1,5 Milliarden Parametern – zur Generierung von Texten. NLP steht für natural language processing. Die größte Schwäche des Modells – und gleichzeitig sein größter Vorteil – ist der surreale Charakter der erzeugten Inhalte. Sie ergeben in der Regel keinen Sinn. Zumindest für die Bedürfnisse der Wissensvermittlung. In einem literarischen Kontext können sie jedoch ein fruchtbares Objekt der Interpretation sein. Und jedes Mal wird ein neuer, einzigartiger Text erzeugt. Keine Geschichte kommt zweimal vor.

Für meine Bedürfnisse habe ich ein GPT-2 Colab Notebook mit Java Interface von Manuel Romero verwendet.

Es gibt verschiedene Notebooks, mit denen Sie sogar GPT-2 an Ihren Texten trainieren können, aber ich habe dieses spezielle Colab-Notebook wegen seiner benutzerfreundlichen und robusten Struktur sowie der Unterstützung des kompletten 1,5 Milliarden-Parameter-Modells ausgewählt. Das Modell funktioniert so: Sie schreiben eine Eingabeaufforderung und KI setzt die Geschichte sinngemäß fort. GPT-2 funktioniert mit dem Neuronalen Netzwerk Transformer, das mithilfe des Aufmerksamkeitsmechanismus ganz logische und kohärente Inhalte erstellt, nicht bloß zufällige Wortkombinationen.

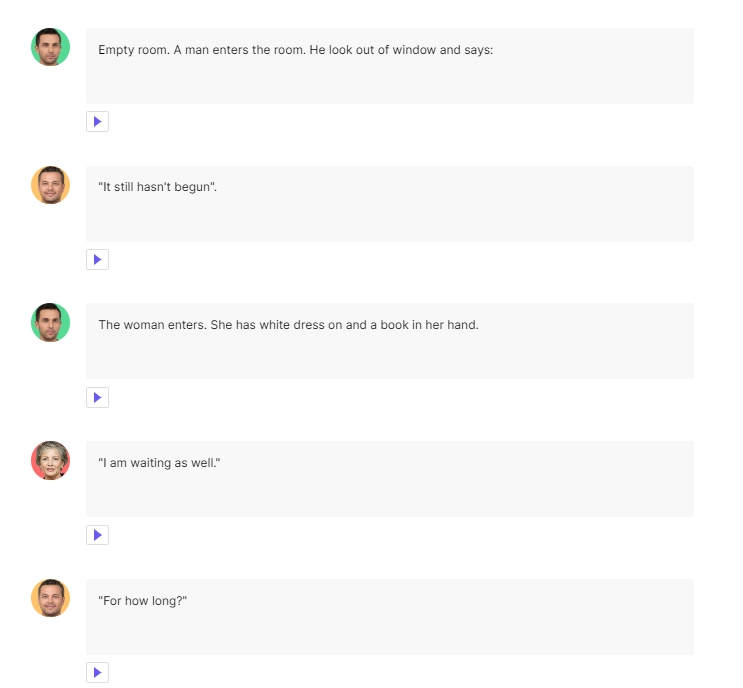

Für meinen Film habe ich den folgenden Prompt eingegeben, auf den GPT-2 dann reagiert hat (im Folgenden ins Deutsche übersetzt):

Ein leerer Raum.

Ein Mann betritt den Raum.

Er schaut aus dem Fenster und sagt: „Es hat noch nicht begonnen“.

Die Frau tritt ein. Sie hat ein weißes Kleid an und hält ein Buch in der Hand.

Die Frau: „Ich warte auch.“

Der Mann: „Wie lange schon?“

Die Frau: „Schon eine Weile.“

GPT-2 hat mir verschiedene Fortsetzungen zur Verfügung gestellt, aber die, die ich ausgewählt habe, war ein erstaunliches Beispiel eines absurdenTheaterstücks, irgendwo zwischen Beckett, Mrożek und David Lynch:

Der Mann: „Ach, wissen Sie, ich bin ein sehr geduldiger Mann.“

Die Frau: „Ich weiß, natürlich.“

Der Mann: „Dann werde ich wohl weniger geduldig sein müssen.“

Die Frau beginnt zu lachen; das Lachen hat einen unheilvollen Unterton, den nur sie spüren kann.

„Zu meiner Verteidigung“, sagt sie, „habe ich Ihnen nie gesagt, was ich Ihnen eigentlich sagen wollte.“

Plötzlich fällt es dem Mann wieder ein: „Das stimmt.“

Die Frau: „Also lügen Sie hinter meinem Rücken.“ Der Mann ist überrascht von der Schroffheit des Vorwurfs. Er ist jedoch nicht verärgert, denn wie er bei früheren Begegnungen festgestellt hat, wirkt die Frau am überzeugendsten, wenn sie Lügen ausspricht.

Der Mann: „Aber es war nicht das, was Sie erwartet haben.“

Die Frau: „Oh... nein.“

Sie versucht, überzeugend zu klingen.

Er will sie über ihre Mutter ausfragen.

Die Frau: „Glauben Sie, dass sie bereit ist zu lügen?“

Der Mann lehnt die Gelegenheit ab.

Die Frau: „Vielleicht...“

„Warum?“

„Vielleicht trauert sie immer noch.“

Sie lächelt, wenn sie dies sagt, und der Mann glaubt nicht, dass sie die Erste sein wird, die lächelt, wenn die Wahrheit ans Licht kommt.

Er gibt auf. „Nein.“

Die Frau: „Es ist noch nicht vorbei.“

Der Mann hat seine Familie nicht mehr gesehen. Er hatte gehofft, zu seiner Arbeit zurückzukehren. Er hat nichts anderes zu tun. Er will ein Mann sein.

Diese Szene überzeugte mich wegen der unklaren Kommunikationsebenen, der Andeutungen, des Unausgesprochenen. Es ist, als ob sich hinter all diesen spärlichen Sätzen eine große Hintergrundgeschichte verbirgt – das menschliche Gehirn vollbringt bei der Interpretation wahre Wunder.

Ich hatte also ein Drehbuch.

Das Bildmaterial

StyleGAN2 ist eine Weiterentwicklung des Generative Adversarial Networks (GAN). Trainiert an Unmengen von Bildmaterial, wirken hier zwei Netzwerke gegeneinander.

- Der Generator kreiert Bilder, die möglichst nah an Trainingsdaten sind.

- Der Discriminator versucht die neuen Bilder als „Fakes“ zu entlarven und zurückzuweisen.

Dieses Gegenspiel wiederholt sich, bis der Discriminator die erstellten Bilder in ihrer Qualität nicht mehr von Originalen unterscheiden kann. Wohl bemerkt, sind die neuen Bilder keineswegs Kopien der Originale – sie sind komplette und bisher nicht existenten Neuinterpretationen.

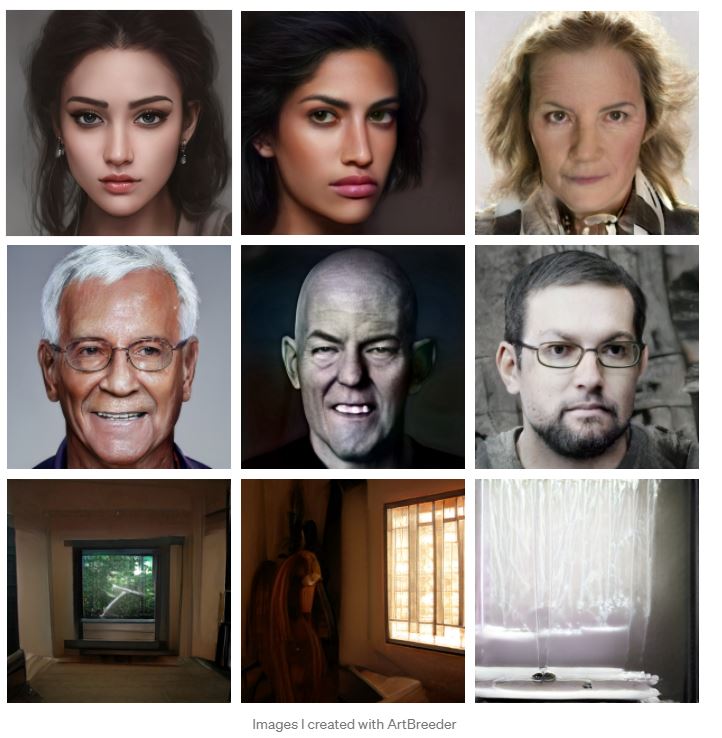

StyleGAN2 – und es gibt bereits StyleGAN3 – ist an einem hochauflösenden Datenset trainiert, das etwa nur Gesichter enthält. Alle erstellten Illustrationen sind im Versteckten Raum – dem Latent Space – des Netzwerks versteckt und können, zum Beispiel mit Hilfe der Web-Applikation ArtBreeder, „rausgefischt“ und bearbeitet werden.

Mit dem Programm lassen sich neue Gesichter erzeugen, aber auch Übergänge und Animationen erstellen – mehr über die Verwendung von Artbreeder lesen Sie hier. Ich habe also eine Reihe von Portraits der Protagonisten der Geschichte sowie einiger Bühnenbilder des Leeren Zimmers erstellt.

Die kniffligste Angelegenheit war es, die Gesichtsanimationen an den Lauf der Geschichte anzupassen – zum Beispiel als die Frau zu lachen beginnt.

Hier sind nur einige der für das Bildmaterial verwendeten Elemente.

Freilich können Sie das First Order Motion Model für dynamische Gesichtsanimationen verwenden – indem Sie sich selbst mit Ihren Andy-Serkis-Fähigkeiten einsetzen. Doch für meinen absurden und minimalistischen Stil war das schlichte Gesichts-Morphing am besten geeignet.

Die Schauspieler

Die Gesichter waren bereits erstellt, aber etwas fehlte noch: die Stimmen.

Die Stimmerzeugung ist wahrscheinlich einer der ältesten Ansätze des maschinellen Lernens. Mein Favorit war MelNet – ein Modell mit unglaublicher Qualität. Hören Sie sich einfach die Beispiele an. Es wurde an professionellen Sprechern und Prominenten trainiert. Leider war MelNet nicht als funktionierendes Repository oder Colab Notebook verfügbar.

Meine zweite Wahl war Amazon Polly. Als Teil der Amazon AWS KI/ML-Services bietet Polly eine große Menge an Stimmen in verschiedenen Sprachen. Der Nachteil ist, dass die meisten von ihnen eher das Charisma eines Nachrichtensprechers haben und nicht immer für fiktionale Inhalte geeignet sind.

Ich habe eine solche Stimme für mein KI-generiertes Video Predictions verwendet:

Doch die emotionslose Stimme wirkt in enigmatischen Dialogen nicht besonders überzeugend.

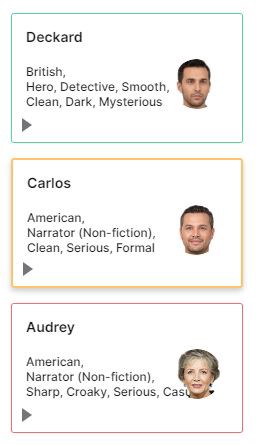

Dann habe ich Replica Studios entdeckt.

Sie bieten eine wachsende Sammlung an Stimmen in einer erstaunlichen Qualität. Einige von ihnen tragen gar theatralische Kraft in sich.

Ich habe diese drei Stimmen ausgewählt – Deckard als Erzähler, Carlos als Mann und Audrey als Frau.

Man kann auch mit den emotionalen Eigenschaften verschiedener Stimmen experimentieren. Das Modell lässt sogar anhand Ihrer eigenen Stimme trainieren, doch die vorhandenen virtuellen Schauspieler waren perfekt für meine Bedürfnisse.

Die Verwendung von Replica Studios ist ziemlich einfach. Man sortiert die Phrasen in chronologischer Reihenfolge und ordnet die entsprechenden Stimmen den Charakteren zu:

Dann exportieren Sie die Stimmen als mp3-Dateien für Ihr Projekt. Es bleibt nun nur noch der Soundtrack.

Die Musik

KI-generierte Musik hat in den letzten Jahren ein neues Qualitätsniveau erreicht, besonders nach der Veröffentlichung von JukeBox von OpenAI. Trainiert an mehr als einer Million Liedern und Musikstücken, konnte diese – ebenfalls vom Transformer gesteuerte Modell – neue Soundscapes erstellen. Dabei sind es nicht bloß Noten oder MIDI-Files, sondern Audiodateien mit Stimmen, Musikuntermalung, sogar gelegentlich mit Applaus und anderen Geräuschen.

OpenAI hat eine Playlist mit rund 7.000 Songs und Musikstücken erstellt, in verschiedenen Genres. (Besuchen Sie auch meine Bibliothek mit seltsamen Klangkulissen, die ich mit Hilfe von JukeBox erstellt habe).

Viele von ihnen sind ziemlich verwirrend – wie dieses alptraumhafte Mozart-Stück. Doch viele sind auch wunderschön. Und besonders in Kombination mit KI-generierten Bildern rufen sie seltsame Gefühle in mir hervor, die jedoch weg vom Uncanny Valley führen – in Richtung der Bewunderung der künstlichen Kreativität.

Zum Zeitpunkt der Filmproduktion hatte ich noch keinen Zugang zu dem System zum Selberkomponieren, so bediente ich mich der von OpenAI bereit gestellten Musikstücke –die für nicht-kommerzielle Zwecke frei verfügbar sind.

Ich verwendete sie zum Beispiel für meine Serie Breath ZeroX:

Zu unserer Geschichte würde eher etwas cineastisches passen, also habe ich auf die an Hans Zimmer Werken trainierte Musik zurückgegriffen und bearbeitete sie:

Werde Mitglied von 1E9!

Hier geht’s um Technologien und Ideen, mit denen wir die Welt besser machen können. Du unterstützt konstruktiven Journalismus statt Streit und Probleme! Als 1E9-Mitglied bekommst du frühen Zugriff auf unsere Inhalte, exklusive Newsletter, Workshops und Events. Vor allem aber wirst du Teil einer Community von Zukunftsoptimisten, die viel voneinander lernen.

Jetzt Mitglied werden!

Und… Action!

Der Rest war eher harte Arbeit eines Cutters – für mein Video habe ich Premiere Pro und Unmengen von Kaffee verwendet. Das Schwierigste war wohl, die Videos zeitlich zu strecken und mit der Handlung zu synchronisieren.

Ein Tipp: Ich habe Time Interpolation: Optical Flow verwendet. Es erzeugt neue, passende Frames zwischen den vorhandenen und macht die Übergänge noch flüssiger. Manchmal produziert es zwar visuelle Störungen - aber die sind immer willkommen, wenn es sich um digital erzeugte Filme handelt!

Und nun. Hier ist er.

Empty Room.

Mit herkömmlichen Mitteln – und mittlerweile zählen KI-Modelle hinzu – lassen sich ganze Filme erstellen. Was machen Sie damit?

Werke von Vladimir Alexeev alias Merzmensch beim „Festival der Zukunft“

Euch fasziniert die Arbeit unseres Autors, des Digitalkünstlers Vladimir Alexeev alias Merzmensch? Dann kommt vom 22. bis 24. Juli zum Festival der Zukunft von 1E9 und Deutschem Museum nach München. Dort werden in der 800 Quadratmeter großen interaktiven Ausstellungen auch seine Werke gezeigt – außerdem erklärt er in einem Talk am 23. Juli, wie man selbst Kunst mit KI machen kann. Er ist einer von über 150 Speakerinnen und Speakern, die an drei Tagen Einblicke in neue Technologien geben. Dazu erwarten euch Kunst, Musik und die große Ausstellung. Seid dabei!

Vladimir ist natürlich auch auf Twitter und auf Medium zu finden. Auf Englisch ist der Text bereits bei Towardsdatascience.com erschienen.

Hat dir der Artikel gefallen? Dann freuen wir uns über deine Unterstützung! Werde Mitglied bei 1E9 oder folge uns bei Twitter, Facebook, Instagram oder LinkedIn und verbreite unsere Inhalte weiter. Danke!

Sprich mit Job, dem Bot!

War der Artikel hilfreich für dich? Hast du noch Fragen oder Anmerkungen? Ich freue mich, wenn du mir Feedback gibst!