Begriffsklärung muss sein: Was Unternehmen, die Prototypen fürs Quantencomputing liefern, heute als Quantencomputer bezeichnen gilt in der Informatik als Prozessor. Zum vollständigen Rechner fehlt diesem Steuer- und Kontrollhardware. Klingt nach Haarspalterei, zeigt aber, dass die internationale Quanten-Community nicht nur technische Fragen, sondern auch ein Sprachgewirr zu klären hat. Das zeigte sich auch während des letzten virtuellen Treffens des Bavarian Quantum Computing eXchange-Netzwerkes (BQCX.de) am Leibniz-Rechenzentrum (LRZ), bei dem Hersteller-Unternehmen mit Forscher:innen des finnischen, akademischen IT-Zentrums CSC sowie des US-amerikanischen Lawrence Berkeley National Lab (LBNL) über die Ausgestaltung von Quantenprozessoren (QPU) und -Kontrolleinheiten sprachen. Moderiert wurden die lebhaften, teils kontroversen Diskussionen von Prof. Martin Schulz, Direktor am Leibniz-Rechenzentrum (LRZ) und Leiter des Lehrstuhls Rechnerarchitekturen und Parallele Systeme an der Technischen Universität München (TUM), sowie Prof Sven Karlsson vom Institut für angewandte Mathematik und Informatik der Technischen Universität Dänemark (DTU).

Neue Messeinheiten zur Leistungskontrolle

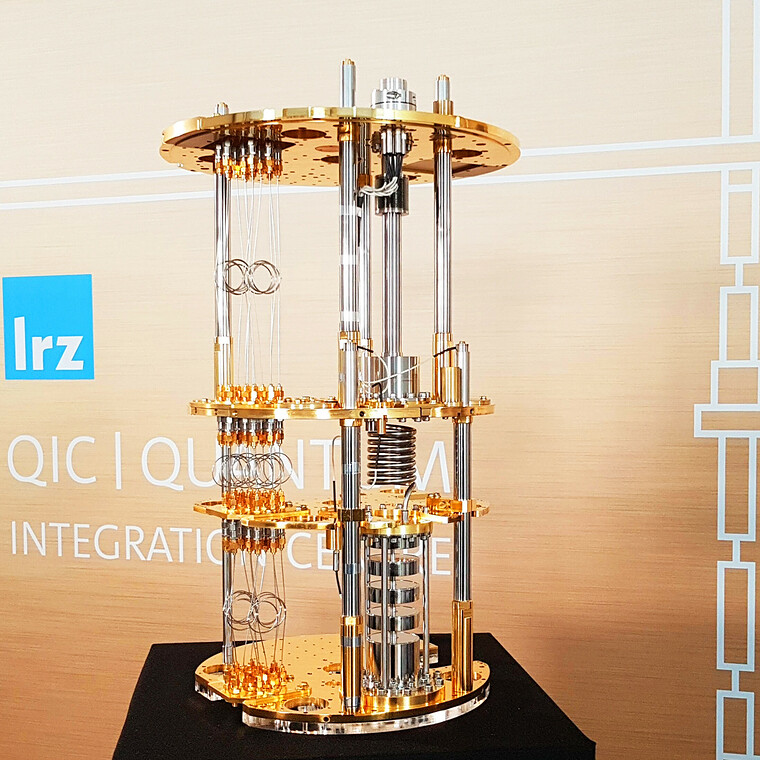

Mit der Begriffsbestimmung von Prozessor und Computer stieg Vortragsrednerin Dr. Anastasiia Butko vom LBNL (eine Informatikerin) sofort in ihr Thema ein: die Ausgestaltung von Qantenprozessoren (QPU) im Hinblick auf deren Integration in Supercomputer. Hochleistungssystemen bringen diese ersten, hybriden Recheneinheiten zum Laufen und in den Nutzungsalltag. Ähnlich wie das LRZ Quantum Integration Centre (QIC) bereitet das LBNL die Installation von QPU in seinen Supercomputern vor, 150 Millionen Dollar investiert das Department of Energy (DOE) für dieses anspruchsvolle Ziel. „Die physikalische Natur von Quantengeräten schafft nicht-triviale architektonische Herausforderungen für die Steuerungshardware, die mit den bestehenden Ansätzen nicht gelöst werden können“, stellt Butko fest. „Es wird spezialisierte Hardware benötigt.“ Um diese zu entwickeln, braucht es andere Maßstäbe zum Überprüfen der neuen Technik. Statt FLOPS, Rechenzeit und Energiebedarf oder die wenig aussagekräftige Anzahl von Qubits empfiehlt die Wissenschaftlerin die Leistung der QPU in den Test-Algorithmen mit Hilfe der Gatter, die Qubits manipulieren können, sowie mit deren Frequenz und Tiefe zu beschreiben.

Anders als die Transistoren bestehender Computer können Qubits nicht nur die Werte 1 oder 0, sondern auch alle Zwischenzustände annehmen. Außerdem verschränken sich die kleinsten Rechen- und Speichereinheiten des Quantencomputings laufend in neuen Verbindungen oder Gattern. Das potenziert zwar die Rechenleistung, macht aber störungsanfällig. QPU von Startups wie IQM Quantum Computer und Alpine Quantum Technologies (AQT) oder von Herstellern wie Google oder IBM sind noch nicht serienreif. Mit der Zahl der Qubits im Prozessor steigt die Empfindlichkeit, die Anforderung an die Kontroll- und Steuerelektronik und deren Integrier- und Skalierbarkeit. Funktionierende Prototypen bieten derzeit nicht viel mehr als 50 Qubits, für zuverlässige Computer reicht das nicht aus. Die brauchen 1000 und viel mehr Qubits, um einerseits schnell arbeiten und zusätzlich die Ergebnisse ebenfalls sofort kontrollieren zu können.

Hindernisse auf dem Weg zur Serienreife

Mit Hilfe eigens entwickelter Rocket Custom Co-Prozessoren (RoCC), standardisierter ISA-Steuerung, Algorithmen aus dem QUASAR-Framework sowie FPGA als Schnittstelle will das LBL einen ersten Schaltkreis zur Kontrolle von QPU bauen und im eigenen System ausprobieren. Quantenprozessoren könnten „bald“ programmierbar und marktreif werden, schließt Butko ihren Vortrag. Wann sie weitgehend ohne Störung und rauschfrei laufen, das sei aber ungewiss. „Die ersten kommerziell relevanten Ergebnisse fürs Quantencomputing werden von einem QPU kommen, der in einem Supercomputer arbeitet“, stellt Jan Goetz, Mitgründer von IQM, in Aussicht. „Das ermöglicht hybride Algorithmen, bei denen ein Teil des Programms anstelle eines klassischen HPC-Clusters von einem QPU ausgeführt wird.“ Für dieses Ziel sind allerdings noch neue Programmiersprachen zu entwickeln, die Kalibrierungen von QPU zu automatisierten sowie die Workflows zwischen den binären Systemen und universellen Recheneinheiten zu harmonisieren.

Weil die technischen Grundlagen zum Einsatz von QPU in den Supercomputern noch fehlen, erwartet Mikael Johansson vom CSC in Espoo (Finnland) die ersten integrationsfähigen Komponenten erst am Ende der 2020er Jahre: „HPC und Quantencomputing ähneln sich nicht besonders, das begrenzt die Funktionen“, meint er und gibt zu bedenken: „Vielleicht kommt der Vorteil von Quantum gar nicht aus ihrer Rechenkraft, sondern aus der Energieeffizienz?“ Auf jeden Fall, fordert Thomas Monz, Mitgründer des österreichischen Startups AQT, sollten Quantenprozessoren mit Hilfe von Supercomputing-Zentren einfach zugänglich und sogar für Nicht-Physiker:innen und Nicht-Informatiker:innen leicht zu benutzen sein. So könnten sie sich etablieren und Rechenkraft in Wirtschaft und Wissenschaft verstärken. Hilfreich wäre dabei sicher auch, zu einer eindeutigen Fachsprache zu kommen: Unklar ist bislang noch, wofür im Quantencomputing eigentlich die Begriffe analog und digital stehen.