Ein Team von Google-Entwicklern hat ein KI-System entwickelt, das Videospiele simulieren kann. Das Spiel läuft vollständig innerhalb einer Künstlichen Intelligenz ab, die auf der Grundlage der Aktionen des Spielers die nächsten logischen Bilder des Geschehens generiert. Als Beispiel dient der Klassiker Doom. Die Entwickler glauben, dass dies die Art und Weise, wie Videospiele entwickelt werden, verändern könnte.

Von Michael Förtsch

Moderne Videospiele entführen in riesige Welten und beeindrucken mit spektakulären Bildern. Möglich wird dies durch komplexe Engines, Sammlungen von Softwaretechnologien, die für die Grafik, die Physik und auch die Spielmechaniken zuständig sind. Bekannt und weit verbreitet sind beispielsweise die Unreal Engine oder auch Unity. Dass dies auch in Zukunft so bleiben wird, stellte Jensen Huang, Chef des Grafikkarten- und KI-Chipherstellers Nvidia, im vergangenen Jahr in Frage. Angesichts der Fortschritte bei KI-Technologien wie Stable Diffusion, DALL-E 3 und anderen sagte er, dass in Zukunft „jedes Pixel generiert werden wird. Nicht gerendert: generiert“. Jetzt zeigt Google, dass er Recht haben könnte.

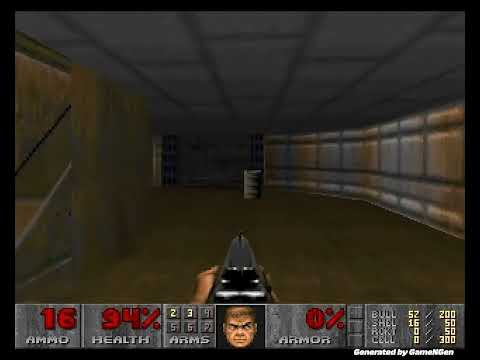

Mit GameNGen hat ein Forscherteam um Dani Valevski ein KI-System vorgestellt, das als Videospiel-Engine fungieren kann. Damit soll es möglich sein, „komplexe Umgebungen in Echtzeit über weite Strecken in hoher Qualität“ darzustellen, mit denen ein Spieler wie in einem klassischen Videospiel interagieren kann. Dass das funktioniert, beweisen die Entwickler mit dem Ego-Shooter-Klassiker Doom. Dieser soll mit GameNGen auf einer Tensor Processing Unit, einem von Google entwickelten KI-Prozessor, mit einer nicht ganz flüssigen, aber durchaus spielbaren Bildrate von 20 Bildern pro Sekunde laufen. Ein Beispielvideo zeigt, wie aus der Ego-Perspektive ein typisches Doom-Level erkundet und Gegner bekämpft werden.

Wie in einer Studie zu GameNGen beschrieben, funktioniert das alles, indem eine Künstliche Intelligenz anhand von Steuereingaben und Ereignissen in der Spielwelt das jeweils nächste Bild vorhersagt und generiert. Dazu wurde ein neuronales Netz – ein sogenannter Agent – anhand menschlicher Spielsitzungen darauf trainiert, Doom zu spielen und so die Spielwelt und ihre Regeln zu erlernen. Gleichzeitig wurden die Trainingssitzungen mit Schlüsselwörtern für die Aktionen des Spielers – schießen, rennen, Tür öffnen zum Beispiel – als Videos aufgezeichnet und damit ein auf Stable Diffusion 1.4 basierender Bildgenerator – der Generative – darauf trainiert, „abhängig von der Sequenz vorangegangener Bilder und Aktionen“ neue Bilder in der Optik von Doom zu erzeugen. Es erträumt den Ego-Shooter also mehr oder weniger.

Werde Mitglied von 1E9!

Hier geht’s um Technologien und Ideen, mit denen wir die Welt besser machen können. Du unterstützt konstruktiven Journalismus statt Streit und Probleme! Als 1E9-Mitglied bekommst du frühen Zugriff auf unsere Inhalte, exklusive Newsletter, Workshops und Events. Vor allem aber wirst du Teil einer Community von Zukunftsoptimisten, die viel voneinander lernen.

Jetzt Mitglied werden!

Noch gibt es Probleme

Wie die Entwickler betonen, sei es nicht ihr Ziel, klassische Videospiel-Engines überflüssig zu machen. Vielmehr soll gezeigt werden, dass moderne KI-Modelle in der Lage sind, komplexe interaktive Umgebungen zu simulieren. Wobei die Autoren der Studie einschränken, dass die visuelle Qualität der generierten Bilder zwar mit der des Originalspiels vergleichbar, aber nicht identisch sei. Wie im Video zu sehen ist, gibt es Momente, in denen die Optik verwischt und verzerrt wird. Auch die Simulation von Doom durch Künstliche Intelligenz sei keine „exakte Simulation“. GameNGen sei zwar in der Lage, im Bild sichtbare Faktoren wie Gesundheitszustand, Munition und Gegner über einen längeren Zeitraum zu erinnern. Aber alles, was außerhalb des Sichtfeldes liege, vergesse das Modell nach etwa drei Sekunden.

Nach Ansicht der Entwickler könnte GameNGen durchaus ein erster Schritt hin zu einem neuen Paradigma in der Entwicklung von Videospielen sein. Eine mögliche Zukunft, in der Videospiele „automatisch generiert“ werden, wie es heute schon bei Bildern und Videos der Fall ist. Bis dahin seien aber noch viele Fragen offen. Unter anderem, wie solche neuen KI-Videospiel-Engines trainiert und wie Videospiele entwickelt würden. Denn im Fall von GameNGen bräuchte es eben ein bereits fertiges Videospiel, um ein Modell für dieses Videospiel zu erstellen. Die Google-Entwickler ermutigen daher zum Experimentieren - sowohl mit anderen Videospielen als auch mit anderen „interaktiven Softwaresystemen“.

Das könnte dich auch interessieren:

- Space Vets: Die erste KI-generierte Animationsserie kommt aus München

- Nicolas Neubert von Runway über KI-Videos: „Wir stehen am Anfang dieser Bewegung“

- CAPTCHAs am Limit: Braucht es einen Menschlichkeitsnachweis?

- Werden KI-Suchmaschinen zum Problem für den Journalismus?

- Doch nur Populismus? Europas AI Act und der Schutz vor „chinesischem“ Social Scoring

Hat dir der Artikel gefallen? Dann freuen wir uns über deine Unterstützung! Werde Mitglied bei 1E9 oder folge uns bei Twitter, Facebook, Instagram oder LinkedIn und verbreite unsere Inhalte weiter. Danke!

Sprich mit Job, dem Bot!

War der Artikel hilfreich für dich? Hast du noch Fragen oder Anmerkungen? Ich freue mich, wenn du mir Feedback gibst!