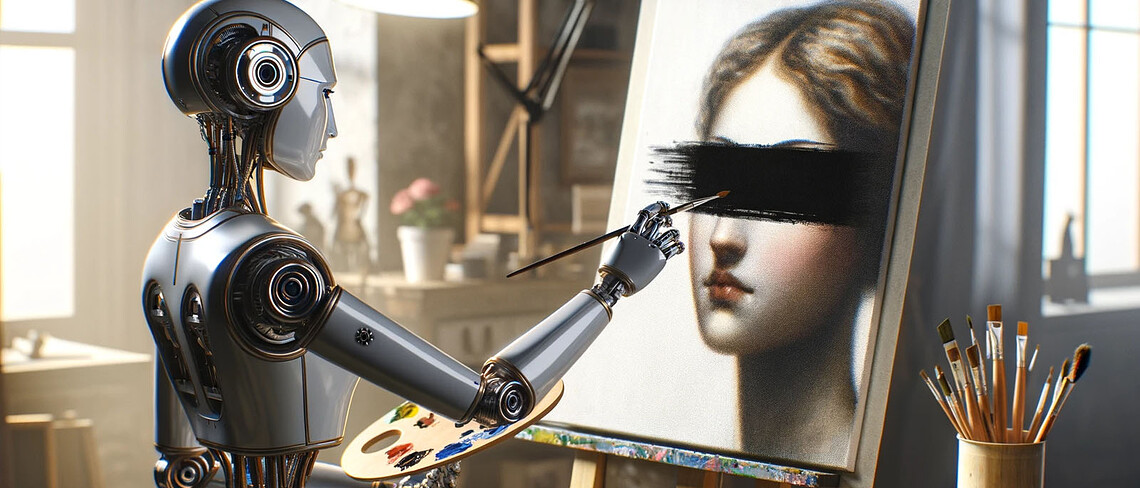

Mit Text-zu-Bild-Generatoren lassen sich täuschend echte Bilder von normalen Menschen erstellen. Mini-Modelle, die in kurzer Zeit trainiert und einfach miteinander getauscht werden können, machen das seit einigen Monaten noch einfacher. Die Plattform CivitAI erlaubt es nun, Kopfgelder auf solche Modelle auszuschreiben, die zum Beispiel für Darstelllungen bestimmter Personen trainiert wurden. Das ist problematisch.

Von Michael Förtsch

In den letzten Jahren ist die Erstellung von Deepfakes mit KI-Tools deutlich einfacher geworden. Insbesondere die Möglichkeit, Prominente mit Hilfe von Text-zu-Bild-Generatoren in nahezu fotorealistische Szenen zu montieren, ist mit etwas Vorwissen problemlos möglich. Vor allem da freie Modelle wie Stable Diffusion bereits mit Datenbanken trainiert wurden, die beispielsweise Schnappschüsse aus Filmen, Werbematerial und Fotoserien enthalten, die Stars auf dem roten Teppich oder bei Talkshow-Auftritten zeigen. Mit den aktuellen Fassungen dieser Modelle versuchten die Entwicklungsfirmen zwar, unerwünschte Fakes zu erschweren, indem die Zahl derartiger Bilder im Trainingsmaterial reduziert wurde. Allerdings konnten Nutzer die Modelle selbst mit eigenen Inhalten tunen und so Gesichter wieder hinzufügen. Bis vor wenigen Monaten war das ein relativ zeitaufwändiger Prozess. Inzwischen nicht mehr.

Anstatt einzelne Gesichter in ein mehrere Gigabyte großes Modell zu trainieren, gibt es heute sogenannte LoRA-Modelle für Stable Diffusion. Dabei handelt es sich um kleine, manchmal nur wenige Kilobyte große KI-Modelle, die mit einzelnen Konzepten trainiert werden. Zum Beispiel mit dem Farb- und Kontraststil eines Kodak-Fotofilms, einem bestimmten Zeichen- oder Malstil, bestimmten Auto- und Flugzeugmodellen, Anime-Charakteren oder eben dem Körper und dem Gesicht bestimmter Personen. Je nach Umfang und Komplexität können LoRAs in weniger als einer halben Stunde erstellt werden.

Einmal trainiert, funktionieren die LoRA-Modelle wie Erweiterungspakete oder Plug-ins, die zu den großen Basismodellen hinzugeschaltet werden können. Dazu müssen sie nur im jeweiligen Programm ausgewählt und im Prompt mit dem LoRA-Namen angesprochen werden. Für viele KI-Künstler sind LoRA-Modelle mittlerweile ein Standardwerkzeug. Sie werden in Facebook-Gruppen, auf Discord-Kanälen und auf Reddit getauscht. Vor allem aber werden sie auf CivitAI verbreitet, einer Plattform, auf der Nutzer ihre eigenen KI-Modelle anbieten, Bilder präsentieren und Artikel rund um die generative KI veröffentlichen können.

Kopfgeld für Promi-Fakes?

Seit einigen Tagen können Nutzer auf CivitAI auch sogenannte Bounties beziehungsweise Kopfgelder für Bilder, aber auch LoRa-Modelle ausschreiben. Bei den Kopfgeldern handelt es sich vor allem um Wünsche nach Modellen für einen dedizierten Grafikstil wie jenem der Videospiel-Serie Bioshock, Kleidungsstücken wie aus der 90er-Jahre-Kultserie Seinfeld oder fiktiven Figuren wie dem Horror-Clown Pennywise. Aber es werden auch Kopfgelder auf Modelle für Menschen ausgesetzt, wie beispielsweise für die Influencerinnen Charli D’Amelio und Anastasia Ditmar. Auch die deutsche Streamerin Baso und das TikTok-Model Nadya Yeremin sind betroffen.

Die Regeln von CivitAI verbieten das Verbreiten von Bildern von „realen Menschen in anzüglichen oder sexualisierten Kontexten“. Jedoch werden diese Vorschriften, wie man auf der Seite leicht überprüfen kann, offenbar nur mäßig durchgesetzt. Was LoRA-Modelle betrifft: Hier untersagt CivitAI den „kommerziellen Einsatz“ und die Nutzung, um missbräuchliche Bilder herzustellen. Aber wie und auf welche Weise die Nutzer sie letztendlich verwenden, kann praktisch nicht kontrolliert oder reguliert werden. Je nach genutztem Basismodell können die LoRAs durch missbräuchlich eingesetzt werden, um kompromittierende Fakes oder sogar pornografische Bilder zu erstellen.

Werde Mitglied von 1E9!

Hier geht’s um Technologien und Ideen, mit denen wir die Welt besser machen können. Du unterstützt konstruktiven Journalismus statt Streit und Probleme! Als 1E9-Mitglied bekommst du frühen Zugriff auf unsere Inhalte, exklusive Newsletter, Workshops und Events. Vor allem aber wirst du Teil einer Community von Zukunftsoptimisten, die viel voneinander lernen.

Jetzt Mitglied werden!

Die Bounties von CivitAI werden auch von der KI-Kunst-Community kritisch gesehen. Denn sie „rufen gerade dazu auf, dass jemand Bilder seiner Exfreundin postet, um dann Fake-Porn zu generieren“, schreibt etwa ein Nutzer auf einem dedizierten KI-Kunst-Discord-Kanal. Genau das passiert auch schon, wie 404 Media berichtet. In den vergangenen Tagen wurden mehrere Bounties veröffentlicht, in denen Nutzer offenbar darum gebeten haben, LoRA-Modelle von Personen des nichtöffentlichen Lebens zu erstellen - sprich: von Exfreundinnen, Bekannten und mehr oder minder berühmten Influencerinnen. CivitAI scheint die Bounties-Sektion der Website zwischenzeitlich strenger zu moderieren. Dutzende Ausschreibungen wurden in den vergangenen Tagen gelöscht.

Eine Anfrage von 1E9 danach, ob und wie CivitAI den Missbrauch von LoRAs verhindern und die eigenen Regeln durchsetzen will, wurde nicht beantwortet.

Hat dir der Artikel gefallen? Dann freuen wir uns über deine Unterstützung! Werde Mitglied bei 1E9 oder folge uns bei Twitter, Facebook, Instagram oder LinkedIn und verbreite unsere Inhalte weiter. Danke!

Sprich mit Job, dem Bot!

War der Artikel hilfreich für dich? Hast du noch Fragen oder Anmerkungen? Ich freue mich, wenn du mir Feedback gibst!