Von Achim Fehrenbach und Wolfgang Kerler

Wahrscheinlich sind euch schon die oft runden Aufbauten aufgefallen, die auf dem Dach von fast allen selbstfahrenden Autos zu sehen sind. Egal, ob sie von Waymo, Uber, GM oder Toyota stammen. Die Aufbauten gelten in weiten Teilen der Branche als unverzichtbar, damit sich die Fahrzeuge überhaupt in der Welt zurechtfinden.

Darin verbaut sind nämlich Lasergeräte und rotierende Spiegel, die tausende Lichtimpulse pro Sekunde aussenden. Treffen diese auf die Oberflächen von Häusern, Bäumen oder anderen Autos, werden sie reflektiert und auf ihrem „Rückweg“ von den Sensoren des Fahrzeugs erfasst. So kann die Entfernung der Objekte gemessen und ein dreidimensionales Bild der Umgebung berechnet werden, durch die das Auto steuert. Der Name dieser Technologie lautet Lidar und steht für light detection and ranging.

Wenn es nach Daniel Cremers geht, muss man sich das wohl nicht unbedingt merken. Er ist überzeugt, dass Lidar für selbstfahrende Autos, aber auch für autonome Drohnen oder Roboter weniger entscheidend sein wird, als bisher angenommen. Cremers ist einer der weltweit führenden Experten für Computer Vision, Lehrstuhlinhaber an der Technischen Universität München und Mitgründer des Start-ups Artisense. Das sitzt zwar im Silicon Valley, hat seine Entwicklungsabteilung aber in München. Nach seiner Keynote bei der 1E9-Konferenz konnten wir mit Daniel Cremers sprechen.

Es kommt nicht auf die Hardware an, sondern auf die Analyse

Trotz jahrelanger Entwicklung kosten die Lidar-Sensoren für ein Auto wohl noch mindestens um die 5000 Dollar. Und selbst wenn die Preise noch weiter nach unten gehen, auf einige Hundert Dollar: Artisense arbeitet mit viel günstigerer Hardware. „Wir bieten Technologien und Methoden, die Standard-Kameradaten als Eingabe nutzen“, sagt Daniel Cremers.

Das heißt: Mit handelsüblichen Industrie-Kameras, die sowohl bei Hitze als auch bei Kälte, bei Regen und bei Dunkelheit mit Scheinwerferlicht funktionieren, kann die Artisense-Software ebenfalls dreidimensionale 3D-Karten in Echtzeit bereitstellen – und gleichzeitig den genauen Standort des Fahrzeugs innerhalb der so kartierten Umgebung ermitteln. „Die Innovation ist, dass wir die Informationen über die Kamerabewegung und die 3D-Welt direkt aus den Helligkeitsdaten der Kamera berechnen“, erklärt Cremers. „Jedes Pixel, jede Helligkeit trägt zur Schätzung bei.“ Es brauche keine teure Hardware, um Maschinen das Sehen beizubringen, sondern die richtigen Analysetools.

Welche Sensoren am Ende in autonome Autos eingebaut werden – ob GPS, Kameras, Lidar, Radar oder Ultraschall –, das dürfte eine Kosten-Nutzen-Frage sein. „Das heißt: Wie viel kostet ein Sensor? Und wie viel bringt er mir an zusätzlichen Informationen?“, sagt der Wissenschaftler. „Gerade Lidar-Sensoren sind sehr teuer, und der Zugewinn, den ich gegenüber unserem kamerabasierten Verfahren habe, ist nicht riesig.“ Zumal die Artisense-Software im Branchenvergleich sehr wenig Rechenpower benötigt.

Anders als Lidar-Technik lassen sich die Kameras, mit denen die Artisense-Technologie arbeitet, in jedes Auto hinter der Windschutzscheibe einbauen. Denn ihnen macht getöntes Glas nichts aus. Damit die Produkte auch unter Extrembedingungen zuverlässig funktionieren, optimiert Artisense diese laufend. „Wir nutzen zum Beispiel neuronale Netze, um mit extremen Helligkeits- und Belichtungsschwankungen klar zu kommen“, sagt Cremers.

Auch Elon Musk zweifelt an Lidar

Obwohl die Artisense-Technologie den Preis eines selbstfahrenden Autos deutlich senken könnte, rechnet das Start-up auch mit Skepsis. Schließlich haben viele Player der Branche Geld und Zeit in Lidar investiert. „Unsere Ansätze sind sehr disruptiv, weil wir sagen: ,Die Kamera ist der führende Sensor, auch für die 3D-Wahrnehmung – nicht Lidar.‘“, erklärt der Mitgründer. „Da gibt es sicherlich allerlei Widerstände.“

Doch man sei mit ziemlich allen Herstellern und Zulieferern im Gespräch. „Wir haben auch schon Anfragen von größeren Automobilkonzernen, die wissen wollen, ob wir unser System in eine Million Autos einbauen können. Sobald solche Aufträge reinkommen, wird die Firma natürlich abheben.“

Ohnehin gibt es sehr prominenten Stimmen, die ebenfalls an Lidar zweifeln. Elon Musk, zum Beispiel, der Chef von Tesla. „Jeder, der sich auf Lidar verlässt, ist verloren“, sagte er bei einer Firmenveranstaltung im Frühjahr. Für ihn besteht die Technik aus viel zu teuren, überflüssigen und störanfälligen Sensoren. „Sie werden sich alle von Lidar verabschieden“, ergänzte er. „Das ist meine Vorhersage. Notiert das ruhig.“ Im Gegensatz zu den anderen Herstellern setzt Tesla bei der Entwicklung autonomer Fahrzeuge daher nicht auf Lidar, sondern auf Kameras und Radar – und Software.

Elon Musk teilt beim Tesla Autonomy Day gegen die Konkurrenz aus, die auf Lidar setzt. Spannend wird es ab einer Stunde und 40 Minuten.

Auch die Intel-Tochter Mobileye entwickelt Technologie, die nur gestützt auf Kameras autonomes Fahren ermöglichen soll. Allerdings ergänze man diese dennoch um andere Sensoren wie Radar oder Lidar – „aber nur aus Gründen der Redundanz“, wie Mobileye-Chef Amnon Shashua kürzlich erklärte.

Dragomir Anguelov, der Forschungschef der Google-Schwesterfirma Waymo, die seit Jahren an autonomen Autos mit Lidar-Sensoren arbeitet, konterte übrigens umgehend die Kritik von Elon Musk. Er könne sich zwar vorstellen, dass computergestütztes Fahren nur mit Kameras funktioniert, sagte er der Wirtschaftswoche . Aber es sei eine große Wette, ob das klappt.

Eine 3D-Karte von Berlin

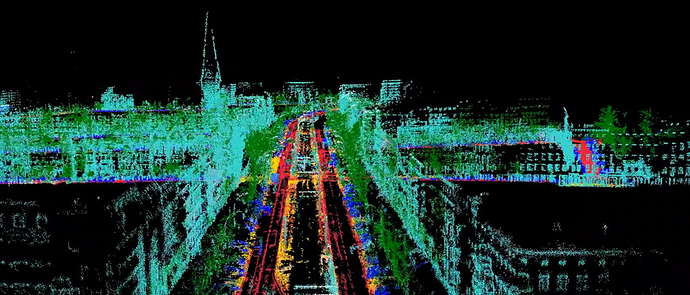

Was die Artisense-Software bereits kann, bewies nun auch das Projekt „Beyond Berlin“. Dafür wurde eine ganze Flotte von Autos mit den Sensorsystemen ausgestattet, um in relativ kurzer Zeit eine 3D-Karte von großen Teilen der Stadt anzufertigen. „Wir haben zudem nachgewiesen, dass es möglich ist, sich in derart 3D-kartierten Welten zu lokalisieren“, erklärt Cremers. „Und das ermöglicht uns, ganz auf GPS zu verzichten.“

Sei eine 3D-Welt einmal mithilfe von Kameras und GPS-Koordinaten rekonstruiert, können sich die Fahrzeuge auch ohne GPS dort zurechtfinden. Artisense könnte also noch eine bisher übliche Technologie ein Stück weit überflüssig machen.

Teaser-Bild: Artisense. Es zeigt eine 3D-Karte von Berlin, die durch das Projekt Beyond Berlin entstanden ist.